AI/ML 시스템 및 종속성 위협 모델링 요약

이 문서는 AI 및 ML 기반 시스템에 대한 위협 모델링과 보안 완화를 다루고 있으며, 주요 내용은 다음과 같습니다:

1. 위협 모델링의 주요 고려 사항

- 신뢰 경계의 재정의

학습 데이터와 데이터 공급자의 손상 가능성을 고려하고, 데이터 중독 방지 및 데이터 계보 추적을 통한 신뢰성 보장. - 질문을 통한 위협 평가

- 학습 데이터가 변조되었는지 어떻게 감지할 것인가?

- 사용자 제공 입력에 대한 유효성 검사 방법은?

- 학습 데이터가 공개된 데이터 소스에서 유래되었을 때 신뢰를 보장하는 절차는?

- 학습 데이터가 모델 출력에 끼치는 영향 및 신뢰도 변화 추적 가능 여부.

2. AI/ML 관련 위협 및 완화 방법

2.1 적대적 교란

- 설명

공격자가 모델의 입력을 조작하여 잘못된 결과를 유도. - 완화

- 적대적 학습 및 정규화.

- 입력 유효성 검사 및 출력의 신뢰도 기반 분석.

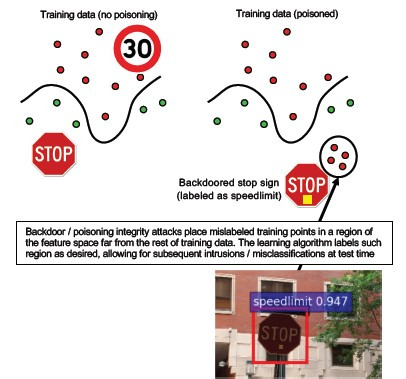

2.2 데이터 중독

- 설명

학습 데이터의 신뢰성을 손상시켜 모델 성능 저하를 유도. - 완화

- 데이터의 변칙 감지 및 분류.

- 악성 데이터 제거 및 학습 데이터 계보 관리.

2.3 모델 반전

- 설명

학습 데이터를 재구성하거나 프라이빗 데이터를 유출하는 공격. - 완화

- 강력한 API 접근 제어.

- 쿼리 속도 제한 및 입력 유효성 검사.

2.4 멤버 자격 유추

- 설명

특정 데이터가 학습 데이터에 포함되었는지 유추하는 공격. - 완화

- 차등 개인 정보 보호 적용.

- 뉴런 드롭아웃 등 모델의 복원력 강화.

2.5 모델 도용

- 설명

합법적인 쿼리를 통해 모델을 복제. - 완화

- 출력 정보의 최소화 및 난독화.

- 신뢰도 값을 반올림하여 반환.

2.6 신경망 재프로그래밍

- 설명

모델을 원래 의도와 다른 작업으로 다시 프로그래밍. - 완화

- 강력한 인증 및 액세스 제어.

- 서비스 수준 계약(SLA) 준수.

2.7 물리적 영역의 적대적 예

- 설명

물리적 세계에서 학습 시스템을 속이기 위한 공격. - 완화

- 기존 보안 관행과 AI 시스템 간 통합 보안 적용.

2.8 악의적인 ML 공급자

- 설명

백도어를 가진 알고리즘을 통해 학습 데이터를 복구하거나 악용. - 완화

- 동형 암호화 및 신뢰할 수 있는 공급자 활용.

2.9 ML 공급망 공격

- 설명

모델 공급망의 종속성을 악용. - 완화

- 종속성 최소화 및 정기적인 위협 모델링.

- 강력한 인증 및 암호화.

2.10 백도어 모델

- 설명

악의적인 데이터로 모델 학습을 조작. - 완화

- 신뢰할 수 있는 데이터 및 사내 모델 학습.

- 외부 모델 손상에 대한 대응 체계 구축.

2.11 소프트웨어 종속성 악용

- 설명

모델 아래의 소프트웨어 계층을 공격. - 완화

- 보안 개발 수명 주기(SDLC) 준수.

- 소프트웨어 취약성 점검 및 보안 모범 사례 적용.

결론

AI/ML 시스템 보안은 기존 소프트웨어 보안의 연장선에서 이루어져야 하며, 학습 데이터, 모델, 그리고 시스템의 종속성을 체계적으로 분석하고 위협에 대비한 완화 전략을 실행해야 합니다.

이를 통해 AI/ML 기술이 안전하게 활용될 수 있는 기반을 마련하고, 신뢰할 수 있는 서비스 환경을 제공합니다.

참고 문헌

[1] 기계 학습, 람 샨카르 시바 쿠마르, 데이비드 오브라이언, 켄드라 앨버트, 살로메 빌조엔, 제프리 스노버의 실패 모드 https://learn.microsoft.com/security/failure-modes-in-machine-learning

[2] AETHER Security Engineering Workstream, Data Provenance/Lineage v-team

[3] 딥 러닝의 악의적 예: 특성화 및 분기, Wei, et al, https://arxiv.org/pdf/1807.00051.pdf

[4] ML-Leaks: 모델 및 데이터 독립 멤버 자격 유추 공격 및 기계 학습 모델에 대한 방어, 살렘, 외, https://arxiv.org/pdf/1806.01246v2.pdf

[5] M. Fredrikson, S. Jha 및 T. Ristenpart, "신뢰 정보 및 기본 대책을 악용하는 모델 반전 공격", 컴퓨터 및 통신 보안에 대한 2015 ACM SIGSAC 컨퍼런스 (CCS)의 절차.

[6] Nicolas Papernot & Patrick McDaniel- Machine Learning AIWTB 2017의 악의적인 예

[7] Stealing Machine Learning Models via Prediction APIs, Florian Tramèr, École Polytechnique Fédérale de Lausanne (EPFL); Fan Zhang, Cornell University; Ari Juels, Cornell Tech; Michael K. Reiter, The University of North Carolina at Chapel Hill; Thomas Ristenpart, Cornell Tech

[8] 이전 가능한 적대적 예의 공간, 플로리안 트라메르, 니콜라스 페이퍼노, 이안 굿펠로우, 댄 본, 패트릭 맥대니얼

[9] 잘 일반화된 학습 모델 Yunhui Long1, Vincent Bindschaedler1, Lei Wang2, Diyue Bu2, Xiaofeng Wang2, Haixu Tang2, Carl A. Gunter1 및 Kai Chen3,4에 대한 멤버 자격 유추 이해

[10] Simon-Gabriel et al., Adversarial vulnerability of neural networks increases with input dimension, ArXiv 2018;

[11] Lyu et al., 악의적 예제를 위한 통합 그라데이션 정규화 제품군, ICDM 2015

[12] 야생 패턴: 적대적 기계 학습이 등장한 지 10년 후 - NeCS 2019 Battista Biggioa, Fa바이오 Roli

[13] 악의적으로 강력한 맬웨어 검색 UsingMonotonic Classification Inigo Incer et al.

[14] 바티스타 비지오, 이지노 코로나, 조르지오 푸메라, 조르지오 지아신토, 파바이오 롤리. 적대적 분류 작업에서 중독 공격 퇴치를 위한 분류자 배깅

[15] 부정적인 영향 방어 홍장 리와 패트릭 P.K. 찬에 대한 개선 된 거부

[16] 애들러. 바이오 메트릭 암호화 시스템의 취약성. 5번째 Int'l Conf. AVBPA, 2005

[17] Galbally, McCool, Fierrez, Marcel, Ortega-Garcia. 언덕 등반 공격에 얼굴 확인 시스템의 취약점에. 패티. Rec., 2010

[18] 웨일린 쉬, 데이비드 에반스, 얀준 치. 기능 압착: 심층 신경망에서 악의적인 예제 검색 2018 네트워크 및 분산 시스템 보안 심포지엄. 2월 18~21일

[19] 적대적 학습에 의해 유도된 모델 신뢰도를 사용하여 적대적 견고성 강화 - Xi Wu, Uyeong Jang, Jiefeng Chen, Lingjiao Chen, Somesh Jha

[20] 적대적 예, 수스미트 자, 써니 라즈, 스티븐 페르난데스, 수미트 쿠마르 자, 서머시 자, 군잔 베르마, 브라이언 할라이언, 아난트람 스와미의 탐지를 위한 특성 기반 인과 분석

[21] 학습 데이터 중독에 대한 강력한 선형 회귀 – Chang Liu 외.

[22] 적대적 견고성 향상을 위한 기능 디노이징, 시항시, 유신 우, 로렌스 반 데르 마테른, 앨런 유일, 카이밍 허

[23] Certified Defenses against Adversarial Examples - Aditi Raghunathan, Jacob Steinhardt, Percy Liang

https://learn.microsoft.com/ko-kr/security/engineering/threat-modeling-aiml

AI/ML 시스템 및 종속성 위협 모델링

위협 완화/보안 기능 기술 지침

learn.microsoft.com

'03.Security' 카테고리의 다른 글

| 인공지능 - 합성 데이터 - 합성데이터 생성·활용 안내서 (24.12.20) (0) | 2025.01.06 |

|---|---|

| 인공지능 - 보안 - 생성형 AI (1) | 2025.01.01 |

| 양자 암호 - 양자 내성 암호 알고리즘 (PQC) (2) | 2024.12.27 |

| 양자 암호 - 쇼어 (Shor) 알고리즘, 그로버(Grover) 알고리즘 (0) | 2024.12.27 |

| 정보보안 - 제로 트러스트 (Zero Trust) 2.0 (3) | 2024.12.27 |