728x90

반응형

1. 서론

1.1 배경

생성형 AI는 텍스트, 이미지, 음성 등 다양한 형태의 콘텐츠를 생성할 수 있는 기술로, 디지털 전환과 함께 급격히 확산되고 있습니다. 그러나 이러한 기술은 새로운 형태의 보안 위협을 유발하며, 개인과 조직의 프라이버시와 보안을 위협할 가능성이 있습니다【14†출처】.

1.2 목적

본 보고서는 생성형 AI 기술의 확산에 따른 주요 보안 위협을 분석하고, 이를 대응하기 위한 기술적, 정책적 방안을 제시합니다.

2. 주요 보안 위협

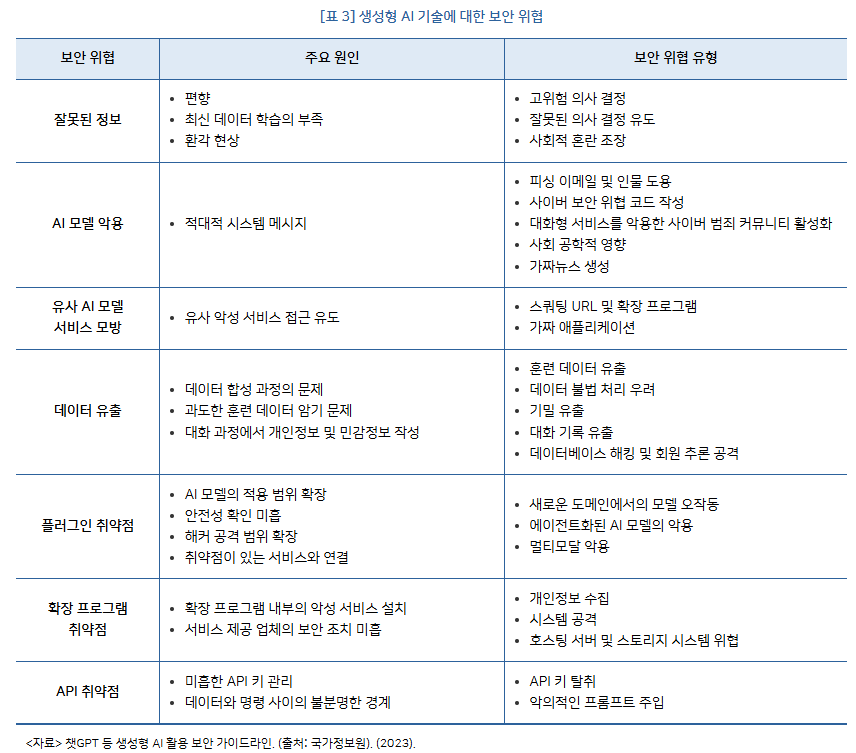

| 위협 유형 | 원인 | 결과 | 사례 |

| 잘못된 정보 생성 | AI 모델의 편향, 환각 현상, 최신 데이터 부족 | 사회적 혼란 조장 및 의사 결정 오류 유발 | 딥페이크 기반 가짜 뉴스가 선거 및 사회적 이슈에 악용되는 사례【14†출처】. |

| AI 모델 악용 | 적대적 시스템 메시지 및 악성 프롬프트 주입 | 피싱 이메일, 멀웨어 생성, 사이버 공격 자동화 | WormGPT, FraudGPT와 같은 악성 도구가 대규모 사이버 범죄에 활용【14†출처】. |

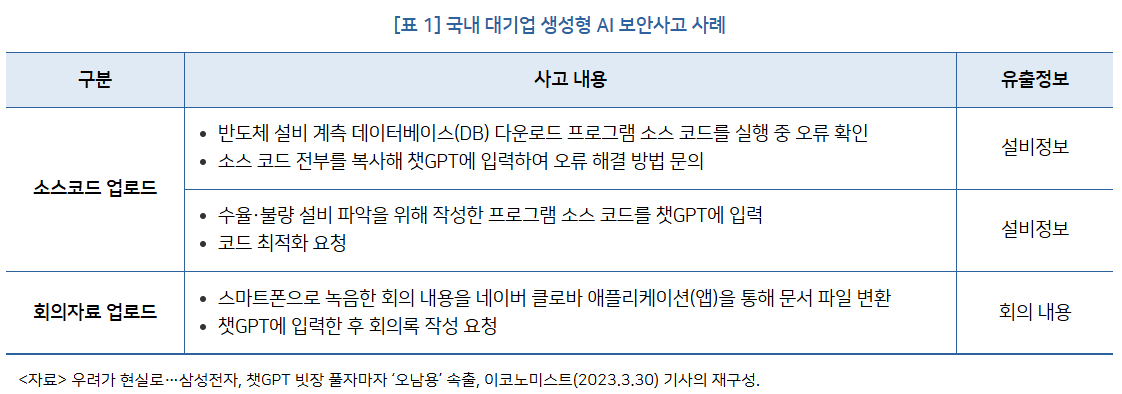

| 데이터 유출 | 과도한 훈련 데이터 암기 및 기밀 정보 포함 | 개인정보 및 기밀 정보 노출 | 기업 내부 데이터가 챗GPT 사용 중 외부로 유출된 사례【14†출처】. |

| API 및 플러그인 취약점 | 보안 설정 부족 및 확장 프로그램 악용 | 백도어 설치, 개인정보 수집, 악성코드 배포 | - |

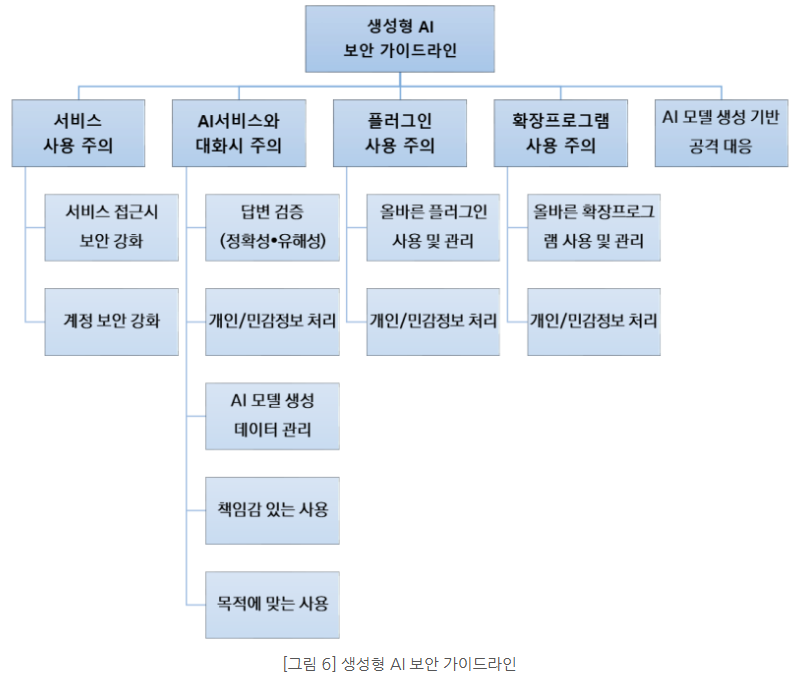

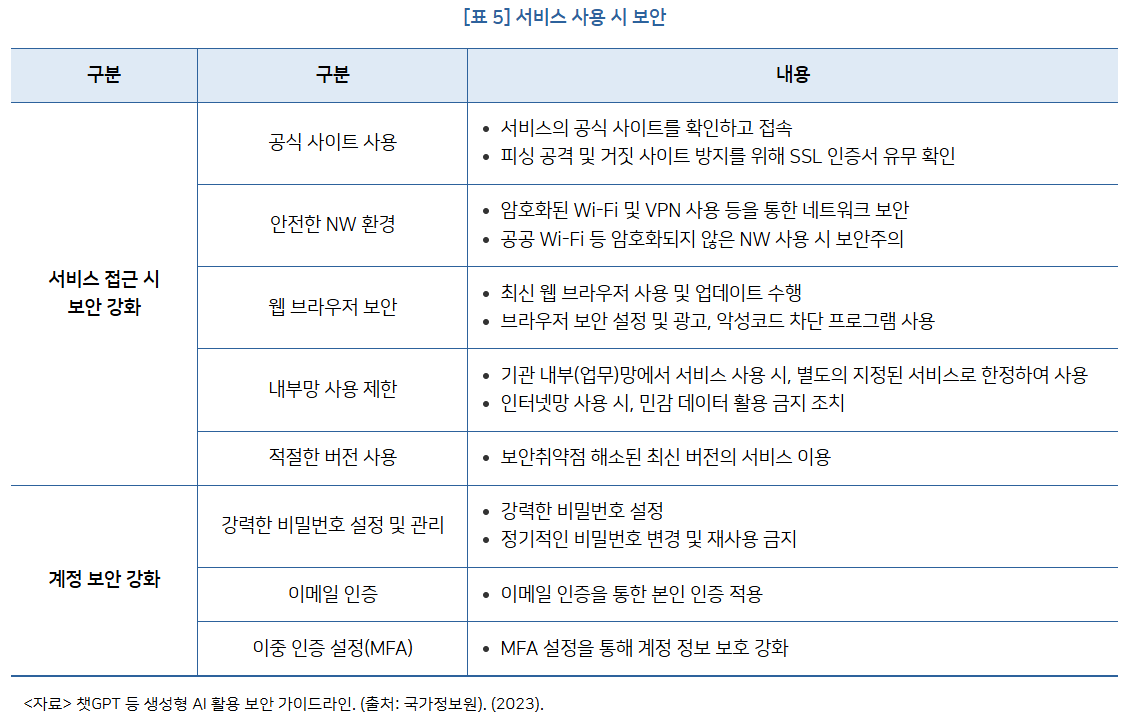

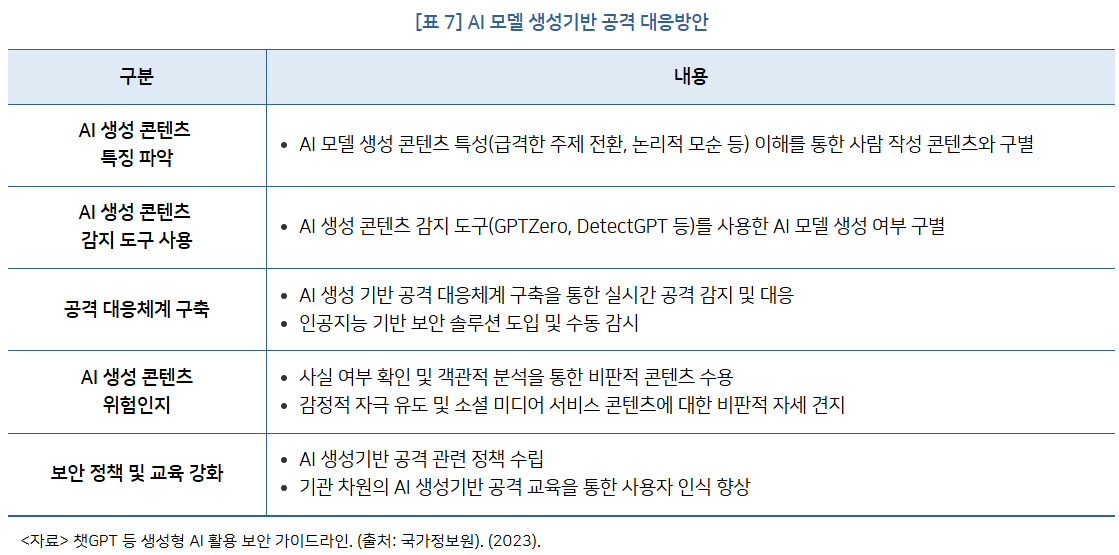

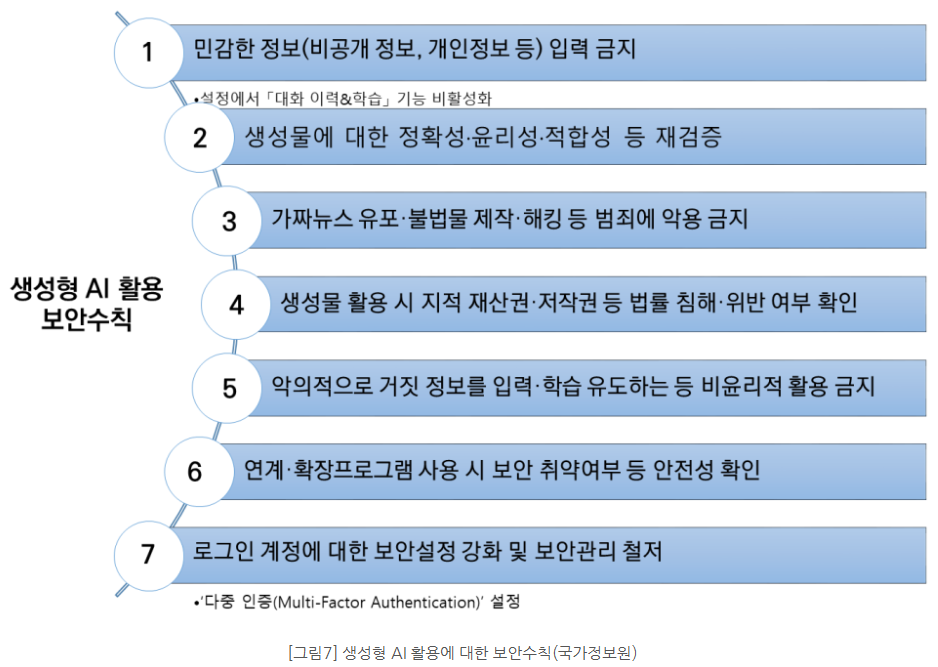

3. 대응 방안

| 대응 방안 유형 | 세부 내용 |

| 기술적 대응 | - AI 모델의 결과를 다중 출처로 교차 검증하는 시스템 도입. |

| - AI 모델에 유해 콘텐츠 생성을 방지하는 필터링 시스템 구축. | |

| - 훈련 데이터의 비식별화 및 암호화, 접근 제어 시스템 강화. | |

| 정책적 대응 | - AI 윤리 및 보안 기준 설정을 포함한 규제 및 법제화. |

| - 차등 프라이버시(Differential Privacy), 동형 암호화(Homomorphic Encryption) 기술 활용【14†출처】. | |

| - 글로벌 AI 거버넌스 구축 및 데이터 보호 법제화. | |

| 교육 및 인식 제고 | - 개발자, 사용자, 정책 입안자를 대상으로 AI 보안 위협 및 윤리적 활용 방법에 대한 교육 강화. |

4. 사례 분석

4.1 글로벌 동향

- 미국: AI 안전성을 위한 NIST의 프레임워크 및 행정명령 발표.

- EU: AI법(Artificial Intelligence Act) 제정으로 AI의 위험 관리 및 보안 의무 강화【14†출처】.

- 한국: 국가정보원의 양자내성 암호 기술 및 AI 보안 강화 방안 추진【14†출처】.

4.2 기업 사례

- 삼성전자: AI 활용 중 내부 데이터 유출 사례 발생.

- 구글 및 MS: AI 모델 보안을 위한 TensorFlow Privacy, Prompt Shield 등의 솔루션 도입【14†출처】.

5. 결론

생성형 AI 기술의 확산은 정보 생성 및 활용의 혁신적 도구를 제공하지만, 그와 동시에 보안 위협과 프라이버시 문제를 심화시키고 있습니다. 기술적, 정책적, 사회적 대응 방안을 통합적으로 수립하여 AI 기술의 안전한 활용과 지속 가능한 발전을 도모해야 합니다.

https://www.kistep.re.kr/board.es?mid=a10306010000&bid=0031&act=view&list_no=93889

데이터・AI 보안 | 전체브리프 | KISTEP 브리프 | KISTEP 발간물 : KISTEP 한국과학기술기획평가원

KISTEP 한국과학기술기획평가원

www.kistep.re.kr

https://blog.naver.com/cslee_official/223505486963

[Tech 리포트] 생성형 AI 보안 위협과 대응방안

전경화_(주)LG CNS_책임 I. 생성형 AI에 대한 기대와 우려 2022년 11월 인공지능 연구소 OpenAI...

blog.naver.com

관련 동영상

728x90

'03.Security' 카테고리의 다른 글

| 가상화 - 망분리 - 다층보안체계(MLS) 로드맵 (1) | 2025.01.18 |

|---|---|

| 인공지능 - 합성 데이터 - 합성데이터 생성·활용 안내서 (24.12.20) (0) | 2025.01.06 |

| 정보보안 - 위협 모델링 - AI/ML 시스템 및 종속성 위협 모델링 (0) | 2025.01.01 |

| 양자 암호 - 양자 내성 암호 알고리즘 (PQC) (2) | 2024.12.27 |

| 양자 암호 - 쇼어 (Shor) 알고리즘, 그로버(Grover) 알고리즘 (0) | 2024.12.27 |