728x90

반응형

< 인공지능의 프로세스와 데이터활용>

-인공지능의 프로세스

데이터수집(Raw 데이터확보) -> 데이터전처리 (데이터준비) -> 데이터학습(머신러닝 알고리즘적용) ->모델적용(태스크수행)

-

데이터 수집과 전처리 단계 (인공지능에서 프라이버시 이슈가 가장 많이 제기)

|

데이터 수집

|

전처리 단계

|

|

-과도한 데이터 수집

-수집경로, 가명화 수준의 적절성

-개인정보의 목적 외 활용여부

|

-데이터 결합/분석과정 개인정보 식별가능성

|

인공지능이 내리는 결정에 따른 윤리적인 문제뿐만 아니라 데이터를 처리하는 과정 자체에서도 프라이버시와 관련한 여러 가지 문제가 발생

-데이터 활용 (개인정보 포함)

|

학습

|

사례

|

|

지도학습

|

-신용 등급 의 분류

-주차 게이트의 번호판 인식

-페이스북이나 구글 포토 의 얼굴에 대한 사용자 태깅 등

-회귀 분석의 경우, 마케팅 분야의 수요예측 시 개인정보가 사용

-신경망 분석에서는 음성 인식, 엑스레이나 CT 사진을 통한 질병 진단

|

|

비 지도학습

|

-군집 알고리즘 통한 바이오 정보의 패턴 인식과 고객 집단 분류를 통한마케팅 활용

-연관규칙학습 통한 쇼핑몰의 상품 추천, 특정 상품을 구매할만한 고객 탐색 등에 활용

|

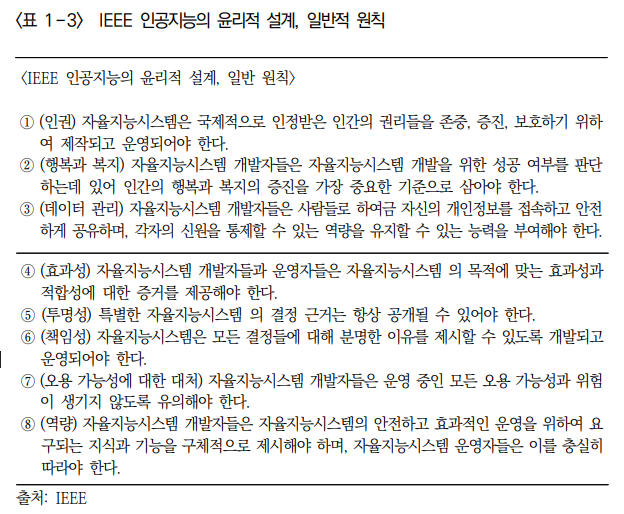

인공지능 윤리

(1) 주요 윤리적 문제와 고려사항

하버드대 버크 만 센터: 주요 인공지능 원칙 36개 분석 8가지 핵심 주제를 선정

(추상적인 가치들까지 포함하는 방대한 범위)

|

8가지 핵심주제

|

|

개인정보(privacy)

책무(accountability)

안전 및 보안(safety and security)

투명성 및 설명가능성(transparency and explainability),

공정성 및 비 차별(fairness and nondiscrimination)

인간의 기술 통제(human control of technology)

전문가 책임(professional responsibility)

인간 가치 증진(promotion of human values)

|

CIPL(Centre for Information Policy Leadership)의 “난제와 실제적 해결안(Hard Issues and Practical Solutions)” 연구에서 제시하는 4개의 이슈를 구체적으로 검토

|

이슈

|

이슈설명

|

예시

|

고려사항

|

|

공정성

(fairness)

|

1.주관적 개념으로 인공지능의 복잡성이 결합되면서 명확하고 일관성 있는 공정성의 적용이 더욱 어려움

|

IBM, MS, 아마존 등의 글로벌 기업 안면인식기술, 유색인종에게 불리한 결과 도출, 기술중지

|

개념은 절대적일 수 없고 지속적이며 반복적인 재평가 필요

|

|

투명성

(transparency)

|

설명가능성, 추적 성, 소통 등 모두 포함하는 개념

1.복잡성 인해 인공지능 의사결정 과정을 명확히 설명 하기 어려운 한계

2.같은 결정 재현의 어려움

|

항공사가 탑승권을 확인하거나 세관원이 입국 허가 시에 활용하는 안면인식 기술

|

단순히 알고리즘을 공개하는 것이 아닌 도출된 결과를 개인이 검토하고 피드백을 제공하도록 하는 것이 중요

|

|

목적 명확화 및

활용 제한

(purpose specification

And use limitation)

|

1.데이터를 분석하면서 의도했던 목적 과 다른 유의미한 결과도 도출

|

|

연구의 효용

용을 저해하지 않으면서 원칙도 준수할 수 있는 균형점 필요

|

|

데이터 최소화

(data minimization)

|

대량의 데이터를 필요로 하는 인공지능 기술의 본질상 대치가 불가피한 이슈-알고리즘개발에 문제, 편향된 일부 데이터만 학습하는 경우 인공지능 윤리 문제 중 하나인 공정성도 저하

|

인공지능 면접 시 데이터 세트에 내재된 편향으로 백인 남성만 채용하는 결과만 도출된다면 선별 도구의 공정성 제고를 위해 인종과 성별 정보를 추가 수집하는 것이 바람 직

|

학습용(training)과 활용(deployment) 단계를 구분해서 학습에 활용하는 데이터의 최소화의 기준을 유연하게 적용하는 등 인공지능 기술의 특성을 반영한 ‘최소화’의 기준 정립이 중요

|

인공지능 윤리 가이드라인 사례

1. 미국 연방거래위원회(FTC) “인공지능과 알고리즘 이용에 대한 지침

인공지능 활용기업대상 윤리적 문제 해결을 위한 가이드 구체적 제시

-불리한 조치를 내리는 경우 사전 고지

-소비자에게 데이터 접근 권한을 부여

-인공지능 모델의 타당성 확보를 위한 정책과 절차를 마련하게 하는 등의 기업의 의무 명시

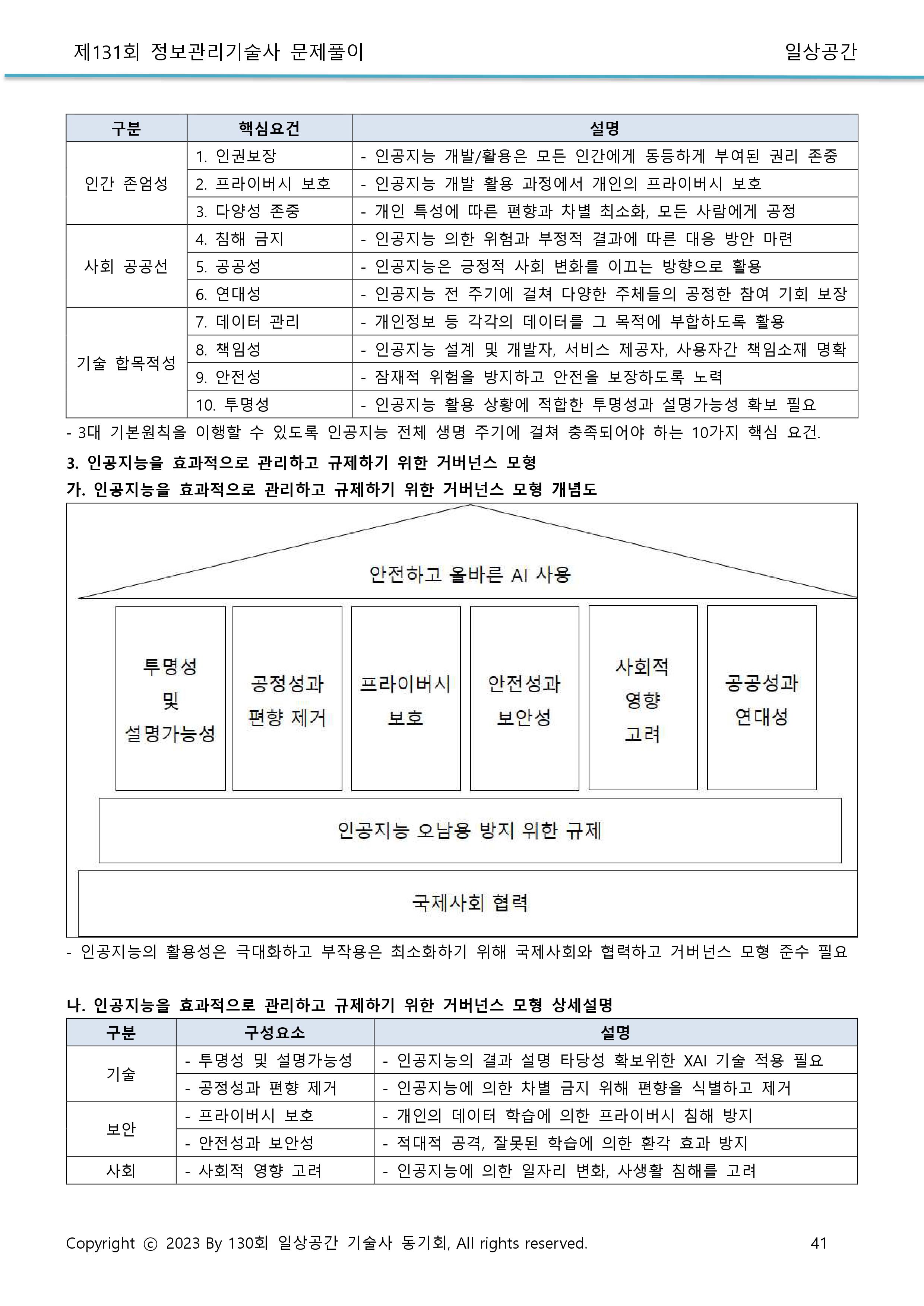

2 유럽연합의 가이드라인(신뢰할 수 있는 인공지능 가이드라인(Ethics guidelines for trustworthy AI)(2019.4.))

신뢰할만한 인공지능 확립(foundation), 구현(realisation), 적용(assessing) 등으로 구성

윤리적 문제 해결과 신뢰할 수 있는 인공지능 시스템 마련 목표, 가이드라인은 정기적으로 업데이트해야 살아 있는 문서로 간주되어야 하고 신뢰할 수 있는 인공지능 구현을 위한 토론 의 출발 점이 되어야 한다고 밝힘.

3. 유럽연합 가이드라인 과 미국 FTC 가이드라인의 차이

|

차이항목

|

유럽연합의 가이드라인

|

미국 연방거래위원회의 지침

|

|

구체성

|

인공지능 가치와 인간 생활에 미치는 영향 포함하는 포괄적 연구

|

구체적이고 실용적인 지침

|

|

목적

|

고위급 전문가 그룹(AI high-level expert group)에 의

한 인공지능 윤리적 질문에 대한 해답을 얻기 위한 연구 결과

|

신기술이나 프라이버시 연구기관이 아닌 경제 규제기관으로서 직접적 적용을 위해 제정

|

시사점

-

신뢰할 수 있는 인공지능 기술이 확립될 수 있도록 개인정보보호 원칙의 재 검토가 필요

: 인공지능 환경의 데이터 활용과 프라이버시 조화를 위해 개인정보보호 원칙의 재해석과 개선 작업 필요

-

기술적·관리적 측면에서 사업자와 개발자들이 준수하고 참고할 수 있는 가이드라인이나 지침, 기술 표준을 제정 필요

: 사업자들- 인공지능 활용을 감독할 내부 거버넌스를 정립하는 기준개발자- 윤리중심의 설계(ethics by design)를 구현하는 방안 등이

※윤리 중심의 인공지능 정책에 대한 회의적인 시각도 존재

신뢰 할 수 있는 인공지능 기술을 구현하고 문제를 해결하는 것들도 물론 중요하지만 기술 자체의 발전이 전제되어야 윤리적 논의도 의미가 있음. 따라서 인공지능과 윤리 문제, 데이터 활용에 대한 이슈는 기술 개발이 가능한 환경과 양립할 수 있도록 균형 있는 시각을 견지 필요

https://www.globalict.kr/news/trend/weekly.do?menuCode=020200&knwldNo=142846#none

file1554485075278067103-196602.pdf

다운로드

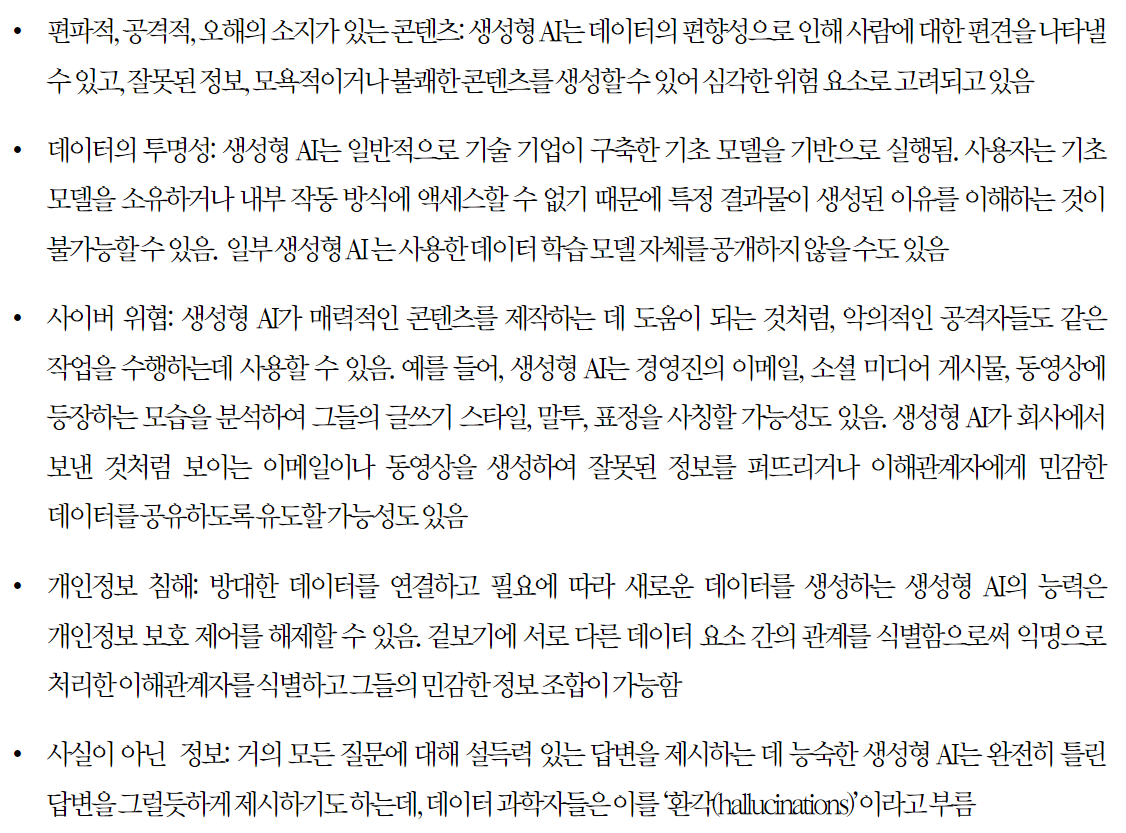

인공지능 기술의 특성상 사람이 완벽하게 메커니즘을 이해하거나 검증할 수 없고 우리 사회의 편향된 데이터로 학습하게 되면서 프라이버시 침해, 공정성과 차별, 투명성, 설명 가능성, 책임성 등의 문제가 주목받고 있다. 데이터를 소유하고 통제하는 주체들에 의해 데이터를 제공하는 개인의 정보가 과도하게 혹은 원치 않는 목적에 활용되거나 식별될 수 있고, 소수의 그룹에 속하는 사람들이 차별을 받을 수 있는 환경이 조성된 것이다.

그림 1. 인공지능의 개념

인공지능의 개념을 보다 구체화시키기 위해 [그림 1]과 같이 인공지능 개념을 구분해보 면, 인공지능은 좁은 인공지능과 일반 인공지능, 슈퍼 인공지능으로 나누어진다. 인간보다 스마트한 슈퍼 인공지능과 인간과 같은 추론과 인지 능력을 갖춘 일반 인공지능 외에 오늘 날 실현되고 있는 인공지능은 좁은 인공지능(Narrow A.I)이다. 좁은 인공지능은 알파고, Watson, Siri처럼 특정 분야에서 신속한 의사결정을 지원하며 정해진 작업만을 하도록 (one specific task) 프로그램화되어 있다.

[그림 2] 인공지능의 프로세스

인공지능 시스템의 프로세스는 데이터를 수집하는 작업부터 시작된다. [그림 2]처럼 로 데이터(raw data)를 확보한 후 데이터 전처리(data pre-processing)를 거쳐 데이터 준 비가 끝나면 머신러닝 알고리즘을 적용시키고 데이터를 학습하며 태스크를 수행하게 된 다. 그 결과 적절한 모델을 선택함으로써 결정을 내리고 특정 액션이 행해지도록 인공지능 모델을 활용하게 된다[5].

[5] PDPC, Discussion paper on artificial intelligence and personal data-fostering responsible development and adoption of AI, 2018. 6, p.4.

- 투명성: 좋은 시스템은 반드시 되먹임 장치(Feedback Mechanism)를 갖고 있다. 이는 정상 항로를 벗어날 경우 경고를 하고, 오류를 토대로 시스템을 지속적으로 개선하여 더욱 완벽하게 만든다.

- 공정성:

- 다양성:

카카오 - 알고리즘 윤리 헌장

FLI - 아실로마 AI 원칙

MS - 인공지능 윤리 디자인 가이드

[주말판] 인공지능의 막다른 골목, ‘인공 공감 능력’

여러 기업들에서 AI에 대한 투자를 진행하고 있다. 투자까지 안 가더라도, 최소한 알아보고는 있다. 인공지능이라는 것을 통해 운영 효율을 얼마나 높일 수 있고, 고객들을 얼마나 만족시킬 수

www.boannews.com

‘디지털 시민성(Digital Citizenship)

인공지능 시대의 윤리규범, 어떻게 정립해야 하나

4차산업혁명 시대가 도래하면서 인공지능 관련 기술이 급속도로 발전하고 있지만, 윤리적 측면에서는 여러 문제들이 산재해 있다. 이러한 가운데 국회입법조사처와 한국인터넷윤리학회는 ‘인

www.boannews.com

728x90

'07.AI' 카테고리의 다른 글

| SW 개발 방법론 - MLOps: 머신 러닝 작업(Machine Learning Operations) (0) | 2023.10.11 |

|---|---|

| 품질관리 - 데이터 품질 - AI 품질관리 수행절차 (0) | 2023.10.11 |

| 빅데이터 - 분석기술 - 기계학습 시각화 (1) | 2023.10.09 |

| 통계 - 가설검정 - 독립표본 t-검정과 대응표본 t-검정 비교 (0) | 2023.10.06 |

| 통계 - 가설검정 (0) | 2023.10.06 |