728x90

반응형

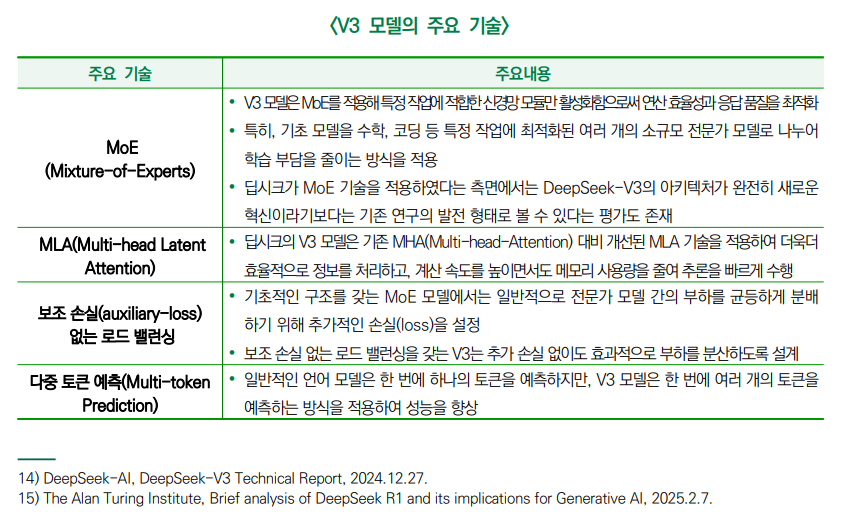

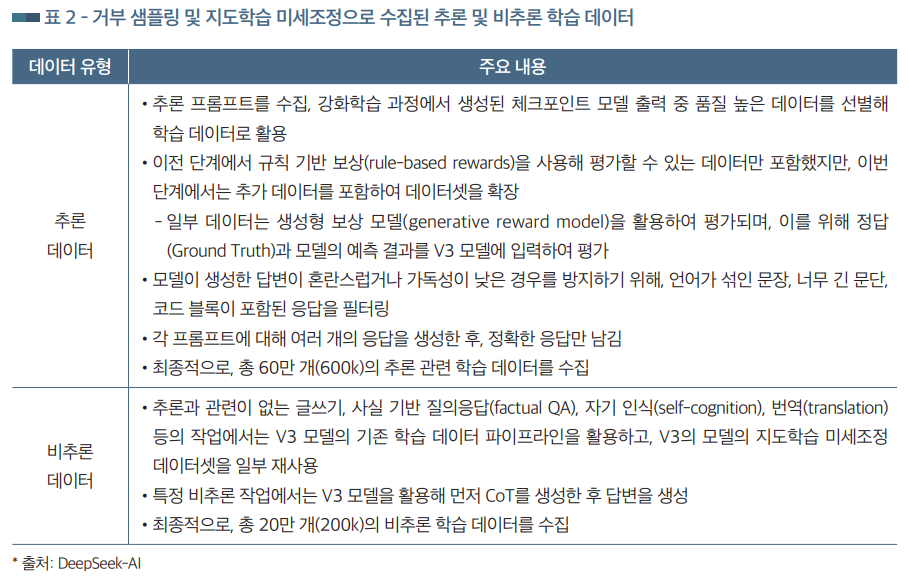

(개념) 전문가 혼합(Mixture-of-Experts, MoE) 아키텍처 기반한 언어모델로, 딥시크 R1 모델 개발을 위한 기초 모델(Basic Model)로 사용

https://keri.koreaexim.go.kr/HPHFOE052M01/110023?curPage=1

https://spri.kr/posts/view/23823?code=AI-Brief&s_year=&data_page=1

728x90

'07.AI' 카테고리의 다른 글

| LLM - 성능 - 최적화 - LoRA(Low-Rank Adaptation) 튜닝 (0) | 2025.02.25 |

|---|---|

| LLM - 딥시크 (DeepSeek) - DeepSeek-R1 (0) | 2025.02.25 |

| OpenAI, Deep Research 문제 (feat. 모델은 틀린다 vs 모델은 맞다) (0) | 2025.02.20 |

| LLM - xAI Grok 3 (1) | 2025.02.20 |

| 인공지능 - 법/규제 - EU, 파리 AI회의 (0) | 2025.02.11 |