(개념) OpenAI의 모델 O1과 경쟁할 수 있는 성능을 자랑하는 대형 AI 모델

- 671억 개의 매개변수를 포함하고 있으며, 다양한 수학, 코드 및 추론 작업에서 뛰어난 성능을 발휘함

- OpenAI의 모델 O1과 성능이 유사하다는 점에서 주목

- Azure AI Foundry와 GitHub에서 사용할 수 있으며, 다양한 플랫폼에서의 활용 가능성

(배경) 딥시크는 R1-Zero 모델의 가독성과 언어 혼합의 문제점을 개선하기 위해 지도학습 미세조정(SFT) 기법을 일부 재도입하고 R1-Zero 모델 개선을 지속하여 최종적으로 R1 모델을 개발

(학습)

| 딥시크 연구팀은 V3-Base 모델 미세조정을 위해 수천 개의 콜드스타트 데이터(Cold-start Data)*를 수집 * 콜드스타트 데이터는 머신러닝 모델의 학습을 초기화하거나 "킥스타트"하는 데 사용되는 소량의 고품질 지도학습 데이터를 말하며, 특히 모델을 처음부터 학습하거나 새로운 작업으로 전환하는 시나리오에서 사용 |

| ∙ 이어 V3-Base 모델을 콜드스타트 데이터로 미세 조정하고, R1-Zero와 유사한 방식으로 대형 R1 모델에 강화학습 적용* * 특히 코딩, 수학, 과학, 논리적 사고(Logical Reasoning)와 같은 명확한 정답이 있는 문제 해결 능력을 강화하는 데 집중 |

| ∙ 강화학습 과정에서 연쇄적 사고(Chain of Thought, CoT) 과정에서 여러 언어가 혼합되는 언어 혼합(Language Mixing 등의 문제점을 발견하여 보상 체계를 최적화하는 방식으로 해결* * 강화학습 과정에서 여러 언어가 포함된 강화학습 프롬프트를 학습할 때 여러 언어가 혼합되는 문제가 발생하여 이러한 문제를 해결하기 위해 연쇄적 사고(CoT)에서 목표 언어의 비율을 계산하여 보상을 부여하는 방식을 적용 |

| ∙ 강화학습 과정이 일정 수준의 성능(수렴 단계)에 도달하면, 기존 모델의 성능을 보다 더 향상하기 위해 새로운 학습 데이터로 모델을 미세 조정하며, 이러한 과정은 다음과 같은 과정을 통해 수행 ① 거부 샘플링(Rejection Sampling): 강화학습을 통해 다양한 답변 중 품질이 높은 데이터만 선별 ② 지도학습 미세조정(SFT) 데이터 추가: ①에서 선별된 데이터와 기존 V3 모델에서 수집한 SFT 데이터(예: 글쓰기, 사실 기반 질의응답, 자기 인식 관련 데이터)와 결합 ③ 모델 재훈련(retrain): 새로운 데이터로 V3-Base 모델을 재학습시켜 더욱 정교한 AI 모델을 완성 |

주요 특징

- 오픈 소스: DeepSeek-R1은 MIT 라이센스 하에 오픈 소스로 제공되어 연구 커뮤니티가 모델 가중치 및 출력을 활용할 수 있도록 지원합니다3.

- 다양한 플랫폼 지원: 이 모델은 웹, 앱 및 API를 통해 사용할 수 있으며, Azure AI Foundry와 GitHub에서도 이용 가능합니다42.

- 성능 비교: DeepSeek-R1은 OpenAI의 모델 O1과 유사한 성능을 보이며, 특히 신뢰할 수 있는 출처를 인용하여 복잡한 문제를 해결하는 데 강점을 보입니다

논문 소개

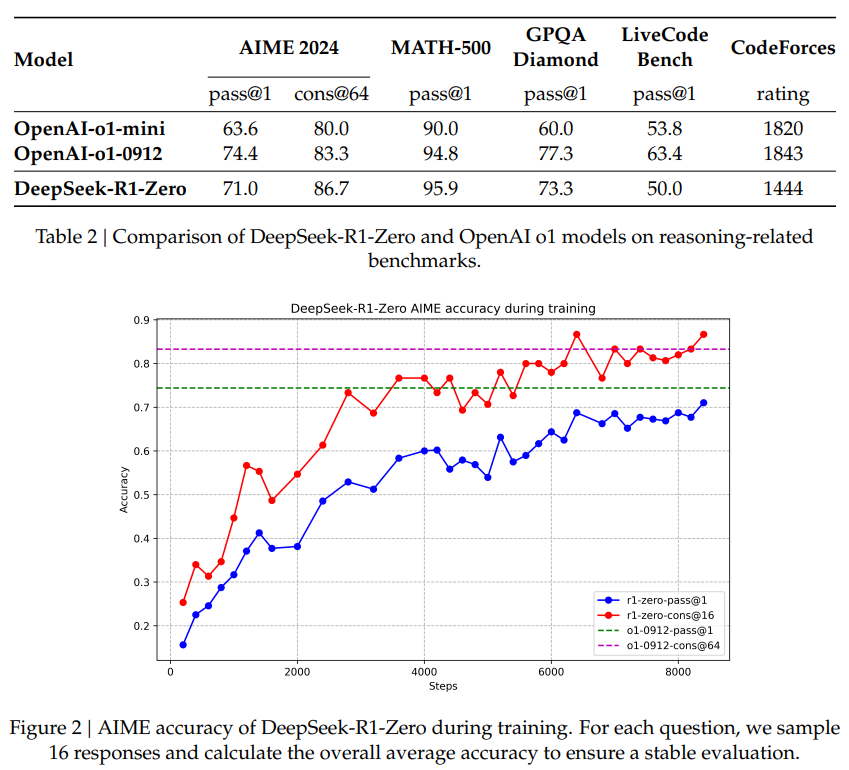

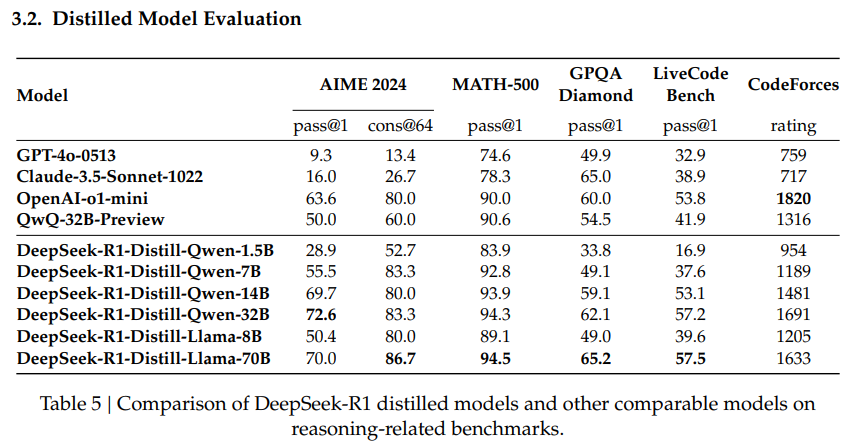

딥시크는 강화 학습(RL)을 통해 추론 기능을 향상시킨 딥시크-R1을 출시합니다. 여기에는 두 가지 핵심 모델이 포함됩니다: 감독된 미세 조정 없이 순수 RL을 사용하는 DeepSeek-R1-Zero와 RL과 콜드 스타트 데이터를 결합한 DeepSeek-R1이 그것입니다. DeepSeek-R1-Zero는 RL만으로도 모델이 정교한 추론 능력을 개발할 수 있음을 입증하며 AIME 2024에서 71.0%의 합격률을 달성하고 OpenAI-o1-0912의 성능과 일치하는 결과를 얻었습니다. 훈련 과정에서 자기 검증 및 반성과 같은 복잡한 동작을 자연스럽게 진화시켰습니다. 하지만 가독성과 언어 혼용이라는 문제에 직면했습니다. 이러한 한계를 해결하기 위해 DeepSeek-R1은 고품질 연쇄 사고 예제를 사용한 초기 미세 조정, 추론 중심의 RL 훈련, 거부 샘플링을 통한 새로운 훈련 데이터 수집, 모든 시나리오에 대한 최종 RL 최적화 등 다단계 접근 방식을 사용했습니다. 그 결과, 출력 가독성과 일관성을 유지하면서 AIME 2024에서 79.8%의 정확도와 MATH-500에서 97.3%의 정확도로 OpenAI-o1-1217과 비슷한 성능을 달성했습니다. 또한 딥시크는 7B 모델이 대형 경쟁사보다 뛰어난 성능을, 32B 모델은 OpenAI-o1-mini에 가까운 결과를 달성하는 등 딥시크-R1의 기능을 소형 모델에 성공적으로 분산시켰습니다. 이는 RL을 통해 직접 소형 모델을 학습시키는 대신 대형 모델에서 추론 패턴을 추출하는 것이 효과적이라는 것을 보여줍니다.

논문 초록(Abstract)

1세대 추론 모델인 DeepSeek-R1-Zero와 DeepSeek-R1을 소개합니다. 사전 단계로 감독 미세 조정(SFT) 없이 대규모 강화 학습(RL)을 통해 학습된 모델인 DeepSeek-R1-Zero는 놀라운 추론 능력을 보여줍니다. RL을 통해 DeepSeek-R1-Zero는 강력하고 흥미로운 수많은 추론 동작을 자연스럽게 구현합니다. 하지만 가독성 저하, 언어 혼용과 같은 문제에 직면하게 됩니다. 이러한 문제를 해결하고 추론 성능을 더욱 향상시키기 위해 다단계 학습과 RL 전 콜드 스타트 데이터를 통합한 DeepSeek-R1을 소개합니다. DeepSeek-R1은 추론 작업에서 OpenAI-o1-1217과 비슷한 성능을 달성합니다. 연구 커뮤니티를 지원하기 위해 딥서치에서는 딥서치-R1-Zero, 딥서치-R1, 그리고 딥서치-R1에서 추출한 6개의 고밀도 모델(1.5B, 7B, 8B, 14B, 32B, 70B)을 Qwen과 Llama 기반으로 오픈소스화했습니다.

모델 증류(Model Distillation)

- R1은 자체의 이전 체크포인트로부터 증류(distilled)한 것

- 증류는 한 교사(teacher) 모델이 학생 모델에 대한 학습 데이터를 생성하는 것으로 일반적으로 교사가 학생보다 더 큰 모델이라고 가정함

- R1은 동일한 모델의 이전 체크포인트를 사용하여 지도 미세 조정(SFT)을 위한 학습 데이터를 생성했음

- SFT와 RL을 반복하여 모델을 개선함

Chain of Thought(CoT) with R1

- DeepSeek는 새로운 DeepThink 기능을 추가하여 R1 모델 시리즈의 Chain-of-Thought(CoT) 추론 능력을 DeepSeek v3 LLM에 통합

- Post-Training: Knowledge Distillation from DeepSeek-R1

- DeepSeek R1 시리즈 모델의 장문 Chain-of-Thought(CoT) 추론 능력을 일반 LLM(특히 DeepSeek-V3)으로 증류(distillation)하는 새로운 방법론 도입

- R1 모델의 검증(verification) 과 반영(reflection) 패턴을 DeepSeek-V3에 우아하게 통합, 추론 성능을 현저히 개선

https://github.com/deepseek-ai/DeepSeek-R1/blob/main/DeepSeek_R1.pdf

DeepSeek-R1/DeepSeek_R1.pdf at main · deepseek-ai/DeepSeek-R1

Contribute to deepseek-ai/DeepSeek-R1 development by creating an account on GitHub.

github.com

Meta의 생성형 AI 조직은 DeepSeek때문에 충격에 빠져있음 | GeekNews

Meta의 생성형 AI 조직은 DeepSeek때문에 충격에 빠져있음 | GeekNews

이미 벤치마크에서 Llama 4를 앞선 DeepSeek V3 때문게다가 "잘 모르는 중국회사가 겨우 5.5M의 훈련 비용"을 썻다고 해서 더욱 충격엔지니어들은 DeepSeek를 해부하고 가능한 모든 것을 모방하기 위해

news.hada.io

https://www.aitimes.kr/news/articleView.html?idxno=33877

딥시크, 저비용 고효율 AI 개발 비밀 공개...그것은 '전문가 혼합 모델'과 '8비트 연산 기법' - 인

중국 AI 스타트업 딥시크(DeepSeek)가 상대적으로 적은 비용으로 세계 최상급 인공지능(AI) 모델을 개발하는 데 성공하며 AI 업계에 여전히 큰 파장을 일으키고 있다.딥시크는 단 2,000개가량의 GPU만

www.aitimes.kr

'07.AI' 카테고리의 다른 글

| 인공지능 - 법/규제 - 인공지능 기본법(AI기본법) - 시행 전 보완을 위한 입법 과제 (0) | 2025.03.13 |

|---|---|

| LLM - 성능 - 최적화 - LoRA(Low-Rank Adaptation) 튜닝 (0) | 2025.02.25 |

| LLM - 딥시크 (DeepSeek) - DeepSeek-V3 (0) | 2025.02.25 |

| OpenAI, Deep Research 문제 (feat. 모델은 틀린다 vs 모델은 맞다) (0) | 2025.02.20 |

| LLM - xAI Grok 3 (1) | 2025.02.20 |