[개념] OpenAI가 만든 언어 AI의 이름

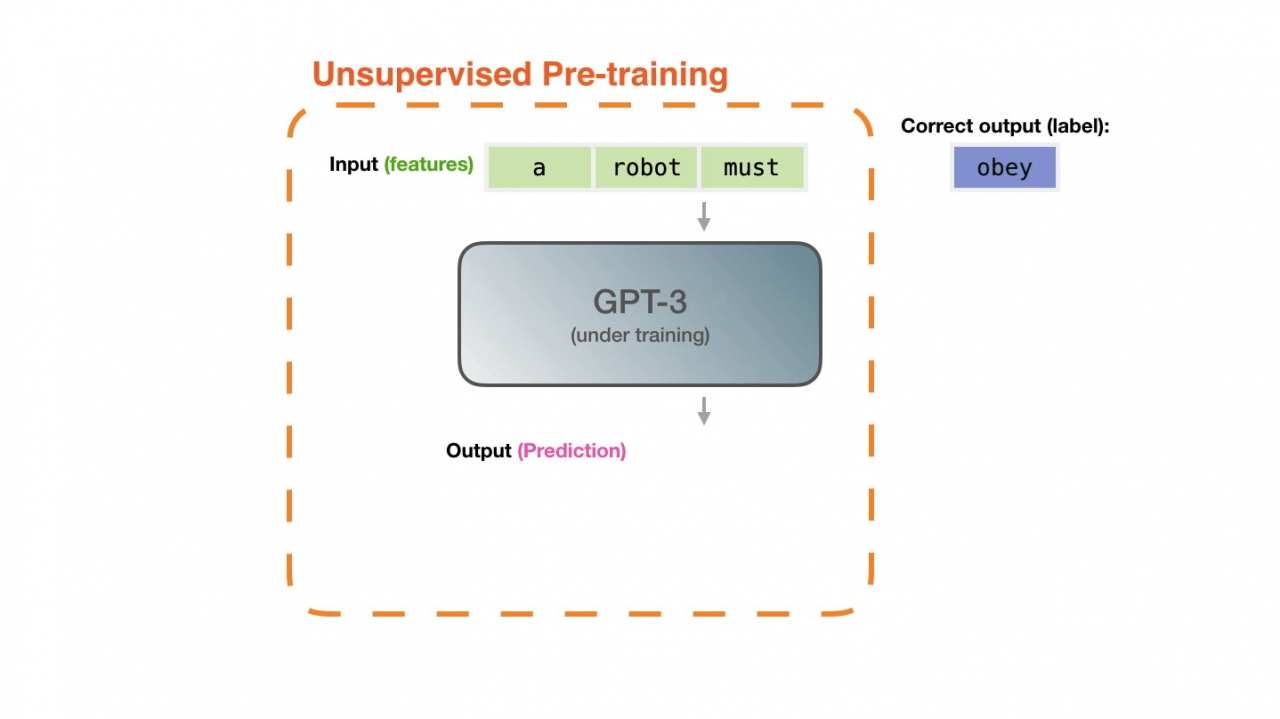

- 학습에 활용된 데이터(단어)는 크롤링(4,100억개), 웹텍스트(190억개), 책1(120 억개), 책2(550억개), 위키피디아(30억개)로 초대규모 데이터셋

-

상황별 보정 메서드 사용 결과 정확도 30% 향상, 분산 저하

-

데이터셋 : 텍스트 분류, 사실 검색, 정보 추출

Calibrate Before Use: Improving Few-Shot Performance of Language Models

GPT-3 can perform numerous tasks when provided a natural language prompt that contains a few training examples. We show that this type of few-shot learning can be unstable: the choice of prompt format, training examples, and even the order of the training

arxiv.org

어떻게 GPT-3를 30% 향상시켰나?

최근 인도에서 발행하는 애널틱스 온라인 매거진 뉴스레터를 읽다가 한 가지 GPT-3에 대해 흥미로운 논문이 있어서 읽어 보고 간추려 정리해 보았습니다. UC 버클리, 메릴랜드 대 및 UC 얼바

brunch.co.kr

Jay Alammar – Visualizing machine learning one concept at a time.

Visualizing machine learning one concept at a time.

jalammar.github.io

조인스프라임 종료 안내

조인스프라임 조인스프라임 서비스가 2022년 6월 30일 종료되었습니다. 그동안 조인스프라임 서비스를 이용해주신 분들께 감사드립니다.

www.joins.com

'07.AI' 카테고리의 다른 글

| 자연어처리 (NLP) - GloVe (0) | 2023.05.15 |

|---|---|

| 머신러닝 - 파이프라인 (0) | 2023.05.10 |

| 자연어처리 (NLP) - SpanBERT (1) | 2023.05.09 |

| 자연어처리 (NLP) - ALBERT (0) | 2023.05.09 |

| 자연어처리 (NLP) - word2vec (0) | 2023.05.08 |