GRPO 101

대규모 언어 모델(LLM)을 위한 RL의 "르네상스"는 DeepSeekMath에서 GRPO(그룹 상대 정책 최적화 ) 도입으로 거슬러 올라갈 수 있습니다 . 개방형 언어 모델에서 수학적 추론의 한계를 넓히다 2024년 4월. GRPO는 검증 가능한 보상을 기반으로 하는 강화 학습(RLVR) 유형 학습의 실행을 크게 단순화한 기본 기술이었습니다. 이후 2025년 1월 세계 금융 시장을 뒤흔든 유명한 DeepSeek R1 모델 에 적용되었습니다 .

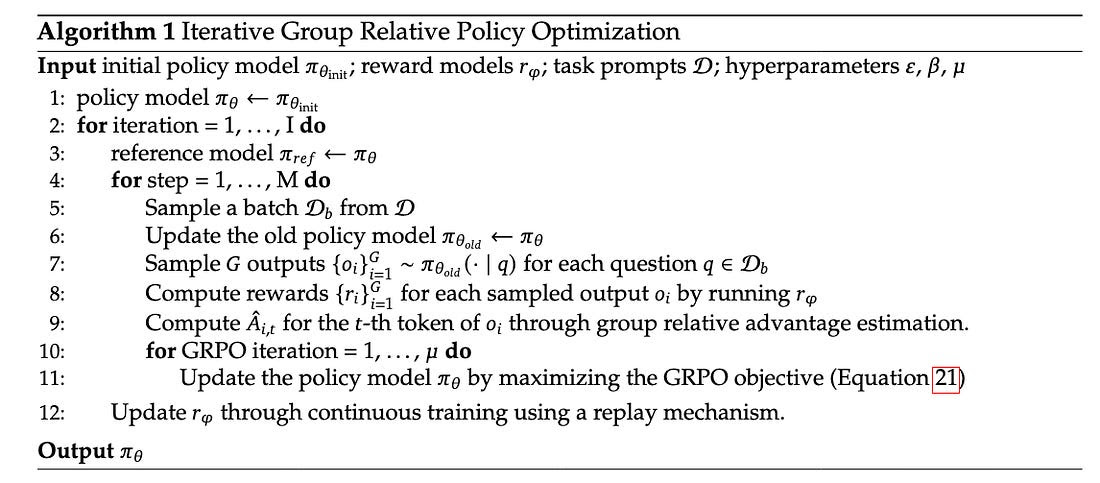

GRPO 알고리즘은 개념적으로 매우 간단합니다. 12줄의 의사 코드로 압축할 수 있습니다(그림 4 참조). 주요 혁신은 PPO 와 같은 기존 강화 학습 기법과 달리 구현이 훨씬 간단하다는 점입니다. 별도의 비평가 모델을 학습할 필요가 없으며, 경험적으로 측정한 결과 훨씬 더 안정적이고 표본 효율성이 높은 것으로 나타났습니다.

RL 표기법에 익숙하지 않은 독자라면 처음에는 복잡해 보일 수 있지만, 자세히 살펴보면 매우 간단합니다. 표 1에서는 그림 4의 알고리즘에 사용된 모든 기호에 대한 자세한 설명과 예시 값을 제시합니다.

GRPO는 소위 그래디언트 정책 최적화 알고리즘의 한 예입니다. 이 이름은 그래디언트를 사용하여 정책(모델)의 매개변수를 직접 조정하여 기대 누적 보상을 극대화하는 강화 학습 방법을 지칭합니다. 그래디언트 정책 최적화 알고리즘은 전통적으로 두 단계로 구성됩니다.

- 롤아웃 생성: 현재 정책을 사용하여 출력을 생성합니다. LLM의 경우, 롤아웃은 주어진 프롬프트에 대해 생성된 토큰의 시퀀스입니다 (그림 5의 `outputs` 변수 참조).

- 최적화 단계 : 생성된 롤아웃을 보상 신호로 평가한 다음, 정책의 그래디언트(보상을 높이기 위해 매개변수를 변경하는 방법을 보여줌)를 사용하여 모델 매개변수를 조정합니다.

GRPO에서는 각 프롬프트에 대해 G개의 답변을 샘플링하고, 이 그룹에 대한 평균 보상을 계산한 다음, 각 개별 보상에서 빼서 이점을 얻습니다. 따라서 이를 "그룹 상대적" 정책 최적화라고 합니다(그림 5 참조).

학습 단계에서는 먼저 로그 확률의 비율, 즉 새 정책을 기존 정책으로 나눈 값을 계산합니다(그림 6 참조). 이 비율에 PPO(Property Point Oriented Policy) 방식의 클리핑을 적용하여 모델이 이전 버전(이전 최적화 단계)에서 너무 크게 벗어나지 않도록 합니다. 이렇게 클리핑된 비율에 이점(advantage)을 곱합니다. 그림 5에서 볼 수 있듯이 이점은 각 완료가 해당 프롬프트에 대해 다른 완료보다 그룹 평균 대비 얼마나 더 나은(또는 더 나쁜) 성능을 보이는지 측정합니다.

모든 RL 알고리즘의 핵심 아이디어는 모델의 가중치를 바꾸어 높은 점수의 출력이 나올 가능성이 높아지고 낮은 점수의 출력이 나올 가능성이 낮아지도록 하는 것입니다.

GRPO의 주요 한계 는 학습된 Critic(예: PPO)을 사용하는 방법과 달리 시퀀스의 모든 토큰에 동일한 이점을 부여한다는 것입니다. 이는 혼합된 품질의 출력에서도 동일한 점수를 부여한다는 것을 의미합니다. 예를 들어, 모델이 세 턴 동안은 틀렸지만 네 번째 턴에서는 성공하는 멀티턴 WORDLE 게임의 경우, 이러한 근사치를 채택하는 이유는 가치 모델의 막대한 오버헤드를 제거하기 때문입니다. 실제로 DeepSeek은 이러한 거친 휴리스틱이 계산 비용이 상당히 저렴할 뿐만 아니라 복잡한 토큰 수준 가치 함수를 학습하는 것보다 더 안정적인 학습 역학을 제공하는 경우가 많다는 것을 관찰했습니다.

http://open.substack.com/pub/tensoreconomics/p/ai-infrastructure-in-the-era-of-experience

'07.AI' 카테고리의 다른 글

| 성과측정 - AI 검증 및 평가 - LLM-as-a-Judge (0) | 2025.12.06 |

|---|---|

| 생성형 AI - 소버린 AI(Sovereign AI) (5) | 2025.12.02 |

| 인공지능 - 위험관리 - AssurAI 데이터셋 (0) | 2025.11.25 |

| LLM - 딥시크 (DeepSeek) - 미 NIST, DeepSeek AI 모델 평가 결과 발표 (0) | 2025.11.18 |

| LLM - 성능 - 최적화 - 양자화 인식 훈련(QAT, Quantization-Aware Training) (0) | 2025.11.17 |