가중치(Weight): 신경망 모델을 학습시킨 후 얻은 파라미터(지식)로, 모델의 핵심 자산

“open-weight”라 부르지만 실제 환경에서는 quantization, 변형, API wrapper, 커스터마이징 등으로 인해 출력이 원래 공개된 가중치 기반 모델과 달라질 수 있음이 연구로 드러났습니다.

즉, “다운로드 가능 = 완전 개방”이라는 전제가 항상 성립하지 않을 수 있습니다.

https://arxiv.org/abs/2410.20247v2 (Tue, 8 Apr 2025 20:19:26 UTC (869 KB))

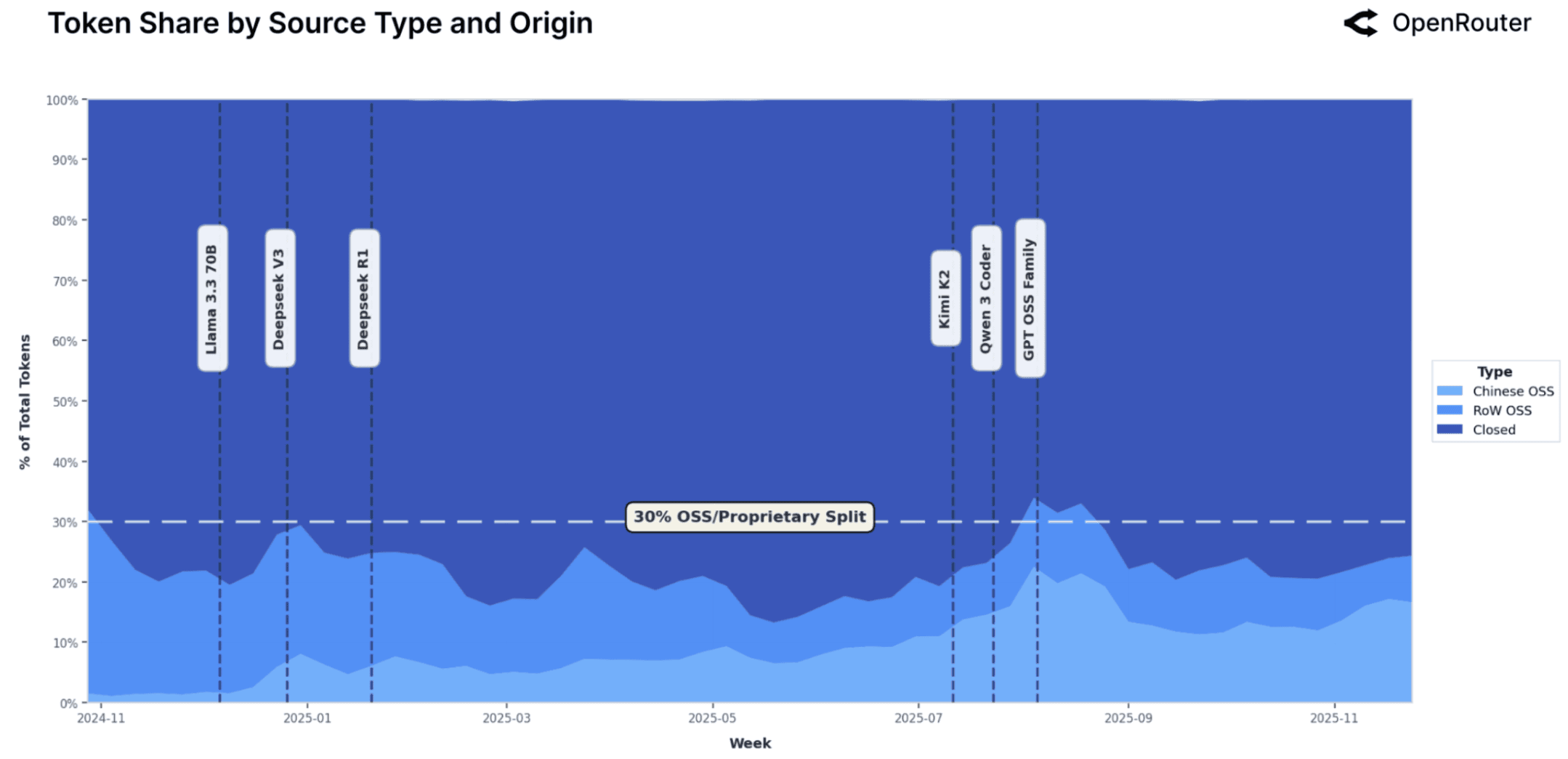

Open vs closed source models split. Weekly share of total token volume by source type. Lighter blue shades represent open-weight models (China vs Rest-of-World), while dark blue corresponds to proprietary (closed) offerings. Vertical dashed lines mark the release of key open weight models including Llama 3.3 70B, DeepSeek V3, DeepSeek R1, Kimi K2, GPT OSS family, and Qwen 3 Coder.

Weekly token volume by model type. Stacked bar chart showing total token usage by model category over time. Dark red corresponds to proprietary models (Closed), orange represents Chinese open source models (Chinese OSS), and teal indicates open source models developed outside China (RoW OSS). The chart highlights a gradual increase in OSS token share through 2025, particularly among Chinese OSS models beginning in mid-year.

개방형 vs 폐쇄형 모델 비교 (feat. ChatGPT 5)

| 구분 | 폐쇄형 가중치 (Closed weights) | 개방형 가중치 (Open weights) |

| 대표 모델(그림 기반) | GPT-4, GPT-4 Turbo, GPT-5, o1, o3 등 | LLaMA 2/3, Mistral, DeepSeek-V2/R1, Phi-4 등 |

| 장점 | 보안 활용 좋음 / 연산 최적화 / 최고 성능 | 연구 투명성 / 비용 절감 / 커스터마이징 용이 |

| 단점 | 접근 제한 / 비용 높음 | 성능 격차 / 안전 기능 편차 |

| 활용 예 | 기업 API 서비스 | 오픈 연구, 자가 호스팅 |

개방형 vs 폐쇄형 모델 비교 (feat. Kimi-k2 Thinking)

| 구분 | 개방형 가중치 모델 | 폐쇄형 가중치 모델 |

| 가중치 접근성 | 공개/다운로드 가능 | 비공개/API 접근 |

| 라이선스 | Apache 2.0, MIT 등 | 사용 약관/별도 계약 |

| 비용 구조 | 인프라 구축비 + 운영비 | API 사용료 (토큰 기준) |

| 커스터마이징 | 매우 자유로움 | 제한적 또는 불가능 |

| 성능 | 준수함~우수 | 일반적으로 최첨단 |

| 배포 방식 | 온프레미스, 클라우드, 엣지 | API 기반 클라우드 |

| 개인정보 보호 | 내부 처리 가능 | 외부 전송 필요 |

| 기술 종속성 | 낮음 (독립적) | 높음 (벤더 종속) |

| 지원/안정성 | 커뮤니티/자체 책임 | 전문 지원/SLA 제공 |

| 적용 시나리오 | 민감 데이터, 대량 처리, 맞춤형 | 빠른 프로토타이핑, 일반 작업 |

개방형 가중치 모델 (Open-Weight Model)

주요 종류 및 예시

| 모델명 | 개발사 | 라이선스 | 특징 |

| Llama 2/3 | Meta | Apache 2.0 | 상업적 이용 가능, 성능 우수 |

| Mistral 7B/8x7B | Mistral AI | Apache 2.0 | 경량화, 효율적 |

| BLOOM | BigScience | Responsible AI license | 다국어 지원 |

| Stable Diffusion | Stability AI | CreativeML OpenRail++ | 이미지 생성 |

| Grok | xAI | Apache 2.0 | Elon Musk의 모델 |

| Gemma | Gemma license | 경량 버전 제공 |

핵심 특징

- 투명성과 검증 가능성: 코드와 가중치 공개로 누구나 내부 동작 분석 가능

- 커스터마이징 자유도 높음:

- 비용 효율성: API 사용료 없이 자체 인프라에서 저비용 운영

- 커뮤니티 기반 혁신: 오픈소스 커뮤니티가 지속적으로 개선

- 프라이버시 보장: 데이터를 외부로 보내지 않고 내부 처리 가능

장점

- 기술 독립성: 특정 벤더에 종속되지 않음

- 장기적 비용 절감: 대규모 사용 시 API 비용 대비 경제적

- 맞춤형 최적화: 특정 도메인/업무에 특화된 모델 구축 용이

- 보안 통제: 민감한 데이터 처리 시 내부 통제 가능

단점

- 성능 격차: 최첨단 폐쇄형 모델보다 약간 뒤처질 수 있음

- 운영 복잡성: 직접 인프라 구축 및 유지보수 필요

- 보안 책임: 모델 보안 취약점에 대한 책임이 사용자에게 있음

- 법적 리스크: 라이선스 위반 가능성 및 저작권 문제 우려

폐쇄형 가중치 모델 (Closed-Weight Model)

주요 종류 및 예시

| 모델명 | 개발사 | 접근 방식 | 특징 |

| GPT-4 | OpenAI | API, ChatGPT Plus | SOTA 성능, 다재다능 |

| Gemini Ultra/Pro | API, Google Workspace | Google 생태계 통합 | |

| Claude 3 Opus | Anthropic | API, 슬랙 통합 | 안전성 강조, 장문 맥락 우수 |

| Copilot | Microsoft | API, Office 365 통합 | 생산성 도구 통합 |

| DALL-E 3 | OpenAI | API | 이미지 생성 |

핵심 특징

- 접근 제한: API 또는 특정 서비스를 통해서만 사용 가능

- 성능 우수: 대규모 컴퓨팅 자원으로 최첨단 성능 달성

- 안정성 및 신뢰성: 전문적인 운영 및 모니터링 인프라 제공

- 보안 관리: 모델 보안 및 취약점 패치를 제공사가 책임짐

- 사용자 데이터 활용: 대량의 사용자 상호작용 데이터로 지속 개선

장점

- 즉시 사용 가능: 복잡한 설치/구성 없이 빠른 구현

- 최신 기술 접근: 최첨단 성능을 손쉽게 활용

- 전문적인 지원: 기술 지원 및 SLA(서비스 수준 약정) 제공

- 보안 전문성: 전문 보안팀의 관리와 빠른 대응

- 규정 준수: GDPR, HIPAA 등 주요 규제 준수 지원

단점

- 높은 사용 비용: 토큰 기반 과금으로 대규모 사용 시 비용 폭증

- 커스터마이징 제한: Fine-tuning 옵션 제한적이거나 추가 비용 발생

- 벤더 종속성: 특정 플랫폼에 기술/비즈니스 종속

- 데이터 프라이버시 우려: 민감한 데이터가 외부 서버로 전송

- 통제 불가: 서비스 중단, 정책 변경, 가격 인상 등의 리스크

최신 동향 및 혼합 전략

경계 모호화 현상

- OpenAI GPT-3.5 Turbo Fine-tuning: 제한적 가중치 조정 허용

- Google Vertex AI: 개방형 모델(Gemma)과 폐쇄형(Gemini) 모두 제공

- AWS Bedrock: 다양한 모델 유형 통합 서비스

주요 AI 플랫폼 모델 제공 방식 비교

| 플랫폼 | 제공 모델 유형 | 가중치 다운로드 | Fine-tuning 방식 | 비고 |

| OpenAI | GPT-3.5 Turbo | ❌ 불가 | Supervised Fine-tuning 지원 | 비용 API 기반 과금 |

| Google Vertex AI | Gemma | ⭕ 가능 | 자체 환경 또는 Vertex AI | Apache 2.0 완전 개방형 |

| Gemini | ❌ 불가 | Google supervised 방식 제한적 | 초대형 컨텍스트 창 | |

| AWS Bedrock | Llama, Mistral, Claude, Titan 등 | ❌ 불가(API 제공) | Bedrock Custom Model | 여러 모델 통합 API |

| Azure OpenAI | GPT-4, GPT-3.5 | ❌ 불가 | Azure 내에서만 처리 | 데이터 보안/주권 강조 |

1. OpenAI GPT-3.5 Turbo Fine-tuning

시작일: 2023년 8월 22일 공식 발표 및 베타 서비스 시작

구체적 내용:

- 가중치 접근성: 직접 가중치 다운로드는 불가능하지만, 기업이 자체 데이터로 Supervised Fine-tuning 수행 가능

- 기술적 제한:

- 파라미터 수: gpt-3.5-turbo-0613 기준 약 175B 파라미터 전체 fine-tuning 가능

- 토큰 제한: 최대 4096 토큰 컨텍스트 창

- 데이터 요구사항: 최소 10개 이상의 예제 (권장 50-100개 이상)

- 파일 형식: JSONL 형식, 최대 100MB, 50개 파일까지 동시 업로드 가능

- 훈련 시간: 일반적으로 수 분~수십 분 소요

- 비용 구조 (2024년 1월 기준):

- 훈련 비용: $0.008 / 1K tokens

- 사용 비용: 입력 $0.0035 / 1K tokens, 출력 $0.004 / 1K tokens

- 기본 모델 대비: 일반 gpt-3.5-turbo 사용료(입력 $0.0015, 출력 $0.002)보다 약 2배 이상 비쌈

- 근거: OpenAI 공식 블로그 "Fine-tuning GPT-3.5 Turbo" (2023년 8월 22일 게시)

2. Google Vertex AI

Gemma 모델:

- 출시일: 2024년 2월 21일

- 특징:

- 2B, 7B 파라미터 경량 모델 (Gemma 2는 2024년 6월에 9B, 27B 출시)

- Apache 2.0 라이선스로 완전 개방형

- Vertex AI Model Garden에서 직접 배포 및 fine-tuning 지원

- 가중치 다운로드 및 온프레미스 배포 가능

Gemini 모델:

- Gemini Pro: 2023년 12월 13일 Vertex AI 통합

- Gemini 1.5 Pro: 2024년 2월 15일 프리뷰 시작, 6월 24일 일반 공개

- 특징:

- API를 통한 폐쇄형 접근만 가능

- 가중치 비공개, fine-tuning은 Google의 supervised tuning 서비스로 제한적 허용

- 컨텍스트 창: 128K~2M 토큰 (Gemini 1.5)

통합 서비스 근거: Google Cloud 공식 블로그 "Gemma: Google의 경량 모델" (2024년 2월 21일) 및 Vertex AI 공식 문서

3. AWS Bedrock

서비스 시작일: 2023년 9월 28일 일반 공개 (GA)

제공 모델 유형 (2024년 7월 기준):

폐쇄형 모델:

- Anthropic Claude 3 (Opus, Sonnet, Haiku): API 전용, 가중치 비공개

- Amazon Titan: AWS 자체 개발 모델, API 전용

- AI21 Labs Jurassic: API 전용

- Cohere Command: API 전용

개방형 모델 지원:

- Meta Llama 3 (8B, 70B): 2024년 4월 추가, 완전 개방형이지만 Bedrock에서는 호스티드 API 형태로 제공

- Mistral AI (7B, 8x7B, Large): 2024년 6월 추가, API 형태로 제공

- 키 포인트: Bedrock에서도 가중치 다운로드는 불가능하며, API로만 접근 가능. 다만 개방형 모델의 API를 통합 제공하는 형태

특징:

- 단일 API: 여러 모델에 대한 통합 엔드포인트 제공

- 맞춤형 기능: Bedrock Custom Model을 통해 자체 모델 fine-tuning 가능 (전이 학습 방식)

- 비용: 모델별로 다르며, 토큰 기반 과금 + 호스팅 시간 기반 과금

근거: AWS 공식 블로그 "Amazon Bedrock is now generally available" (2023년 9월 28일) 및 AWS Bedrock 공식 제품 페이지

4. 추가 근거: Microsoft Azure OpenAI Service

시작일: 2023년 5월 GPT-4 fine-tuning 베타 시작

구체적 내용:

- Azure에서만: OpenAI API 대신 Azure 클라우드 환경에서 fine-tuning 서비스 제공

- 데이터 주권: 데이터는 Azure 내에서만 처리 (OpenAI로 전송되지 않음)

- 출시 시점: 2023년 5월 GPT-4 fine-tuning 베타, 2023년 8월 GPT-3.5-Turbo fine-tuning GA

- 특징: 하이브리드 접근법의 또 다른 사례로, 폐쇄형 모델을 클라우드 환경에서 보안 강화된 형태로 제공

근거: Microsoft Azure 블로그 "Azure OpenAI GPT-4 fine-tuning" (2023년 5월 9일)

'07.AI' 카테고리의 다른 글

| LLM - 검색 증강 생성 (RAG) - 평가 (0) | 2025.12.17 |

|---|---|

| LLM - 성능 - 리텐션(retention) (0) | 2025.12.14 |

| 생성형 AI - 오픈 모델 (Open Model) (1) | 2025.12.14 |

| LLM - Open AI, GPT-5.2 (0) | 2025.12.12 |

| LLM - 성능 - 벤치마크 - Extended NYT Connections (0) | 2025.12.12 |