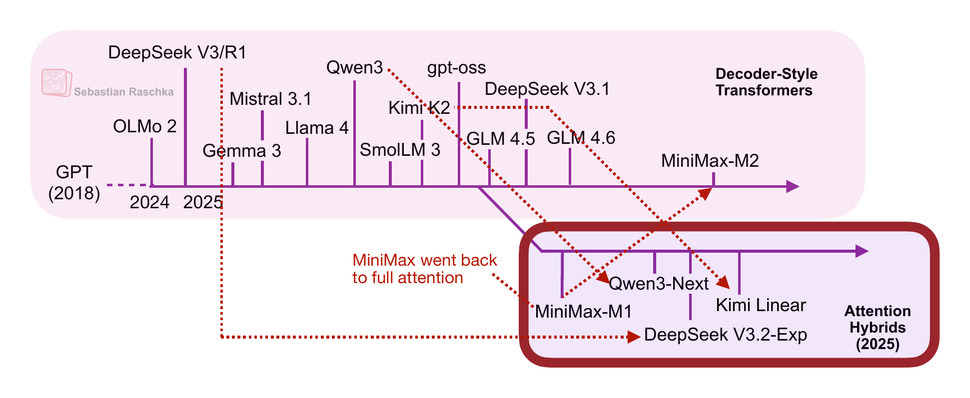

가장 먼저 주목할 만한 모델은 엄청난 주목을 받은 MiniMax-M1 이었습니다.

MiniMax-M1은 46B 활성 매개변수를 갖춘 456B 매개변수 전문가 혼합(MoE) 모델로, 6월에 출시되었습니다.

8월에는 Qwen3 팀이 Qwen3-Next를 출시했는데, 앞서 더 자세히 설명했습니다. 9월에는 DeepSeek 팀이 DeepSeek V3.2를 발표했습니다 . (DeepSeek V3.2의 희소 어텐션 메커니즘은 엄밀히 말하면 선형적이지는 않지만, 계산 비용 측면에서 적어도 준이차적(subquadratic)이므로 MiniMax-M1, Qwen3-Next, Kimi Linear와 같은 범주에 속하는 것이 타당하다고 생각합니다.)

세 가지 모델(MiniMax-M1, Qwen3-Next, DeepSeek V3.2) 모두 대부분 또는 모든 레이어에서 기존의 2차 어텐션 변형을 효율적인 선형 변형으로 대체했습니다.

흥미롭게도, 최근 MiniMax 팀이 선형 어텐션 없이 일반 어텐션으로 돌아가는 새로운 230B 매개변수 M2 모델을 출시하면서 반전이 있었습니다. 연구팀은 선형 어텐션이 프로덕션 LLM에서는 까다롭다고 지적했습니다 . 일반 프롬프트에서는 잘 작동하는 듯했지만, 추론 및 다중 턴 작업에서는 정확도가 떨어졌는데, 이는 일반 채팅 세션뿐만 아니라 에이전트 애플리케이션에도 중요한 요소입니다.

이는 선형적 주의가 결국 추구할 가치가 없게 되는 전환점이 될 수도 있었습니다. 하지만 더 흥미로운 사실이 드러납니다. 10월에 키미 팀은 선형적 주의가 적용된 새로운 키미 선형 모델을 출시했습니다.

이러한 선형적 주의 측면에서 Qwen3-Next와 Kimi Linear는 모두 Gated DeltaNet을 채택했습니다. 저는 다음 몇 섹션에서 이를 하이브리드 주의 아키텍처의 한 예로 논의하고자 합니다.

2.4 Qwen3-넥스트

Qwen3-Next부터 시작해 보겠습니다. 이 메커니즘은 일반적인 어텐션 메커니즘을 Gated DeltaNet + Gated Attention 하이브리드로 대체하여 메모리 사용량 측면에서 기본 262k 토큰 컨텍스트 길이를 지원하는 데 도움이 됩니다(이전의 235B-A22B 모델은 기본적으로 32k를 지원했고 YaRN 스케일링 을 통해 131k를 지원했습니다 ).

이들의 하이브리드 메커니즘은 아래 그림에서 볼 수 있듯이 3:1의 비율로 Gated DeltaNet 블록과 Gated Attention 블록을 혼합합니다.

https://youtu.be/lONyteDR4XE?si=Uu-rGsDypg3VEtIr

https://magazine.sebastianraschka.com/p/beyond-standard-llms

'12. 메일진' 카테고리의 다른 글

| 2026 - 가트너, 10대 전략 기술 발표 (0) | 2025.11.14 |

|---|---|

| 2025 - MAD Landscape (0) | 2025.11.14 |

| DB 유형 - 벡터 DB (벡터 데이터베이스) - Vector Databases for Machine Learning (0) | 2025.11.02 |

| ITFIND 메일진 제1235호 산업분야별 정보메일 (발행 : 2025-10-17 ) (0) | 2025.11.02 |

| 인공지능 - 인공지능 에이전트 (Agent) - 피지컬 AI (Physical AI) (2) | 2025.11.02 |