‘Large Language Model Meta AI’

(정의) 올해 초 메타가 공개한 대규모 AI 언어 모델

(매개변수) 70억에서 650억 매개변수(Parameter)에 이르는 다양한 모델 크기가 학습

- LLama 2를 코드에 특화된 데이터 셋으로 더 많은 데이터를 샘플링하고 오래 훈련시킨 코드 생성을 위한 고성능 LLM

- HumanEval 에서 67.8으로 오픈 모델중 최고의 성능을 보임

- 이전 라이센스와 마찬가지로 연구/상업적 목적 모두 사용 가능

- 3가지 모델

- CodeLlama-70B

- CodeLlama-70B-Python

- CodeLlama-70B-Instruct

- 이제 4가지 사이즈로 제공됨 7B/13B/34B/70B

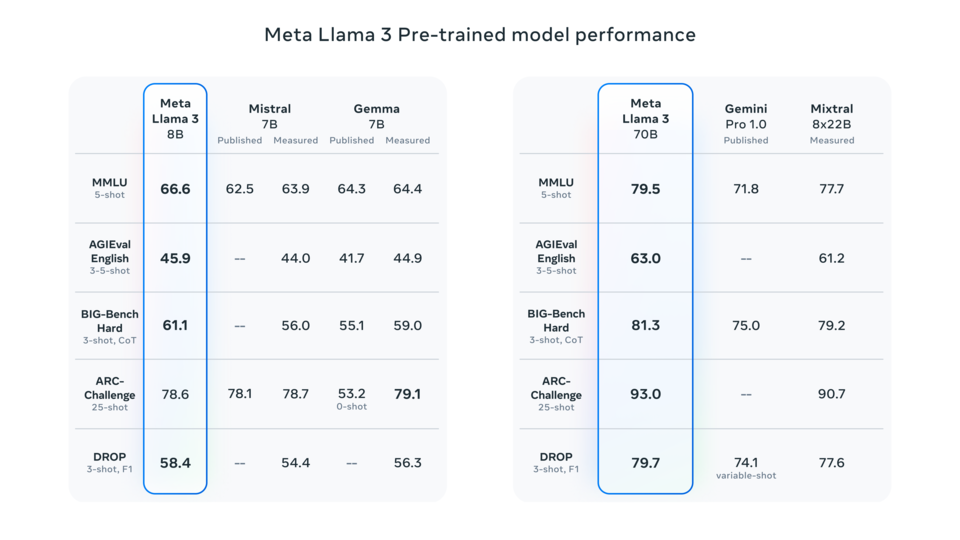

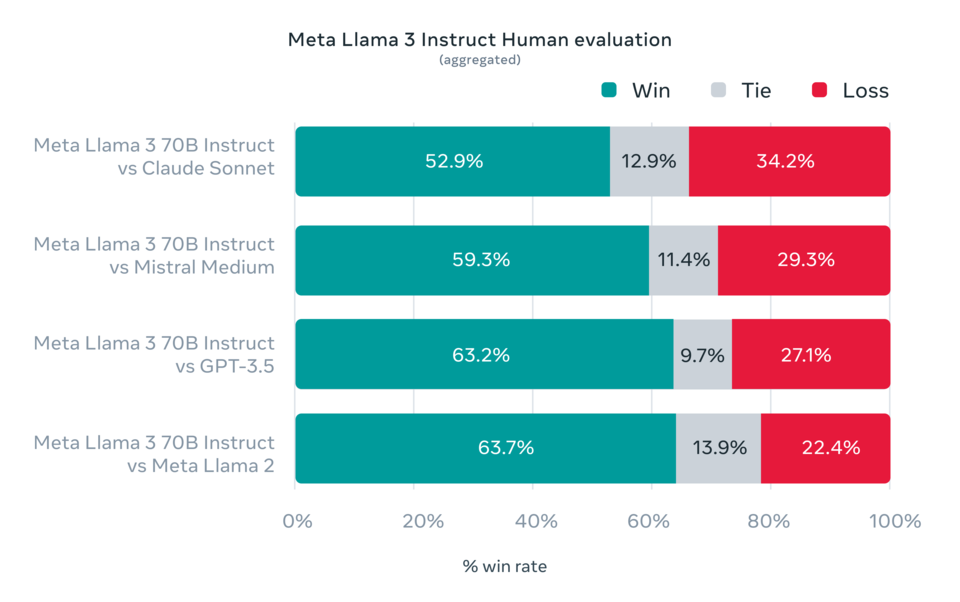

라마3 특징

- 학습 데이터를 2T에서 15T로 늘림

- context window를 4096에서 8192로 늘림

- GQA를 70B뿐만아니라 8B 모델에도 적용

- 토크나이저 크기를 32k에서 128k로 늘림

- instruction tuning시 SFT, rejection sampling, PPO, DPO 모두 적용

- 8B는 2023년 3월, 70B는 2023년 12월까지의 데이터로 학습

- 400+B 모델 학습중

- Multimodal 모델 공개 예정

- Jetbrains 플러그인인 CodeGPT를 개발하여 로컬에서 실행할 수 있음. 해당 플러그인은 여기에서 확인 가능.

- Hugging Face에서 모델을 확인할 수 있음: CodeLlama-70b-hf.

- ChatGPT와 GitHub Copilot을 사용하는 한 사용자는 VS Code에서 이러한 모델을 어떻게 활용할 수 있는지 궁금해 함. VS Code용 GPT 확장 프로그램이 많지만 대부분 업데이트가 없거나 유료 플랜으로 이어지기 때문에 GitHub Copilot을 계속 사용하는 것이 낫다고 생각함.

- Meta가 오픈 소스 머신러닝에 대한 훌륭한 헌신을 보여준 것에 대해 인정해야 함.

- 작은 코드 모델들이 얼마나 좋은지를 보면, 이 70B 모델이 어떤 능력을 보여줄지 궁금함.

- 많은 사람들이 4090과 작은 모델 사용을 언급하지만, 에너지 소비에 대한 분석은 드물게 볼 수 있음. Microsoft가 Copilot을 크게 보조하고 있다고 생각하며, 하루 중 30%의 시간 동안 Copilot을 사용한다면, 한 달에 4090에서 7B 또는 13B 모델이 소비하는 kWh가 얼마인지, 그리고 에너지 비용이 얼마나 드는지 궁금함.

- 현재 최고의 로컬 Copilot 모델이 무엇인지, vscode에서 비슷한 경험을 제공하는 확장 프로그램이 있는지 궁금함. 4090을 가지고 있으니, 상당한 수의 모델을 실행할 수 있을 것으로 기대함.

- Baptiste Roziere가 최근에 Code Llama에 대한 훌륭한 강연을 했으며, 강연은 여기에서 시청 가능함.

- M2 Max와 같은 기기에서 로컬로 실행할 수 있고 IDE 플러그인을 통해 Copilot과 같은 기능을 할 수 있다면 흥미로움. 프로젝트에서 지루한 문제를 해결하거나 "보일러플레이트" 코드를 작성하는 데 시간을 절약할 수 있어 더 어려운 소프트웨어 엔지니어링 작업에 집중할 수 있음.

- 평균 프로그래머가 필요한 속도로 이를 실행할 장비를 가지고 있지 않을 가능성이 있어, 이 플러그인이 누구를 대상으로 하는지 확실하지 않음. 그럼에도 불구하고 멋진 기능임.

(특징)

- - Llama 2는 기존 버전보다 40% 더 많은 2조 개의 토큰으로 학습되었어요(1.4T→2T 토큰).

- - 컨텍스트 길이도 2배 증가한 4095으로 설정됐습니다(2K→4K).

- - 매개변수 규모에 따라 세 가지 모델이 제공됩니다(Llama-2-7B, 13B, 70B).

- - 안전성(Safety)과 유용성(Helpfulness)을 위한 두 보상 모델(Rewards Model, RM)을 만들었어요.

- - 추론, 코딩, 지식 태스크를 포함하는 벤치마크 테스트에서 ‘MPT’, ‘Falcon’ 등의 타 LLM들보다 성능이 뛰어났어요.

- - 무료로 상업적 이용이 가능합니다. 단, 월간 활성 사용자(MAU)가 7억 명⁺의 회사가 활용할 경우 메타와 별도의 라이센스 계약이 필요해요.

- - MS와의 파트너십을 더욱 확대할 예정이에요.

Meta, 생성형 AI의 신뢰와 안전을 위한 Purple Llama 프로젝트 발표

개발자들이 책임감 있게 생성 AI 모델을 배포할 수 있도록 지원하기 위해, 개방형 신뢰 및 안전 도구와 평가를 제공하는 엄브렐라 프로젝트

첫번째 단계로 두가지 도구를 공개

CyberSec Eval : LLM들을 위한 사이버보안 안전 평가 벤치마크

Llama Guard : 배포가 쉽도록 최적화된 입출력 필터링을 위한 Safety Classifier

AI Alliance, AMD, AWS, Google Cloud, Hugging Face, IBM, Intel, Lightning AI, Microsoft, MLCommons, NVIDIA, Scale AI 등과 협력하여 이러한 도구를 오픈 소스 커뮤니티에 제공할 예정

왜 Purple 인가?

제너레이티브 AI가 제시하는 도전들을 진정으로 완화하려면 공격(레드팀)과 방어(블루팀) 태세를 모두 갖춰야 한다고 믿음

레드팀과 블루팀의 조합으로 구성된 퍼플팀은 잠재적 위험을 평가하고 완화하기 위한 협업적 접근 방식

Purple Llama 프로젝트는 연구 및 상업적 사용을 가능하게 하는 허가적 라이선스로 제공될 예정

이는 커뮤니티 협업을 촉진하고 생성 AI 개발을 위한 신뢰 및 안전 도구의 개발 및 사용을 표준화하는 중요한 단계

https://modulabs.co.kr/blog/llama-2-intro/

Llama 2에 세계가 열광하는 이유는? (메타 라마2 개념/특징/사용법까지)

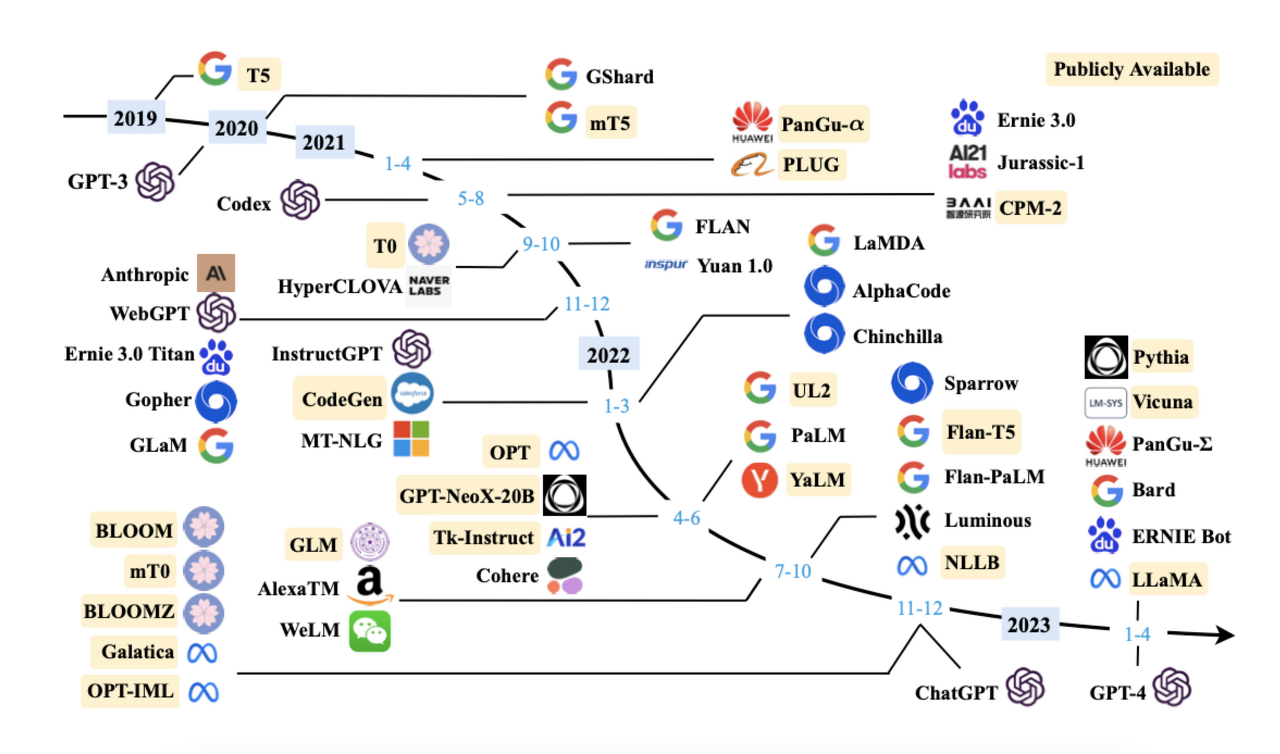

AI 분야에서 가장 핫한 키워드 중 하나가 바로 대형 언어 모델(Large Language Model, LLM)일 거예요. 오늘 다룰 내용은 이 LLM에서 요즘 가장 뜨거운 'Llama 2 (라마2)'에 대한 이야기입니다.

modulabs.co.kr

https://ai.meta.com/blog/purple-llama-open-trust-safety-generative-ai/

Announcing Purple Llama: Towards open trust and safety in the new world of generative AI

Cybersecurity and LLM prompt safety are important areas for generative AI safety today. We have prioritized these considerations in our first party products and highlighted them as best practice in the Llama 2 Responsible Use Guide. We are sharing what we

ai.meta.com

https://huggingface.co/codellama

codellama (Code Llama)

🦙 Code Llama This organization is the home of the Code Llama models in the Hugging Face Transformers format. Code Llama is a code-specialized version of Llama 2 that was created by further training Llama 2 on its code-specific datasets, sampling more da

huggingface.co

https://devocean.sk.com/blog/techBoardDetail.do?ID=165832&boardType=techBlog

Meta Llama 3 간단한 분석

devocean.sk.com

https://www.aitimes.kr/news/articleView.html?idxno=30960

메타, 최고 성능의 LLM ‘라마 3’와 인공지능 챗봇 ‘메타AI’ 오픈소스로 공개... 글로벌 생성AI

메타가 대화형 생성 인공지능(Generative AI)과 대형언어모델(LLM) 글로벌 생태계에 새로운 지평을 열었다.지난 18일(현지시간) 메타는 차세대 대형언어모델(LLM) \'라마 3(LLaMa3)\' 세 가지 모델 중 80억

www.aitimes.kr

'07.AI' 카테고리의 다른 글

| 2024 - ML/AI/Data 업계 지도와 최신 트렌드 (0) | 2024.05.09 |

|---|---|

| 인지 - 감성 컴퓨팅 (Affective Computing) (0) | 2024.04.30 |

| 성과측정 - AI 검증 및 평가 (0) | 2024.04.23 |

| 생성형 AI - 정책 - 미국 AI 이니셔티브 법 (NAII) (0) | 2024.04.18 |

| 생성형 AI - 정책 - 미국 AI 이니셔티브 (AAII) (0) | 2024.04.18 |