https://www.seangoedecke.com/fast-llm-inference/

빠른 LLM 추론을 위한 두 가지 기술적 접근법

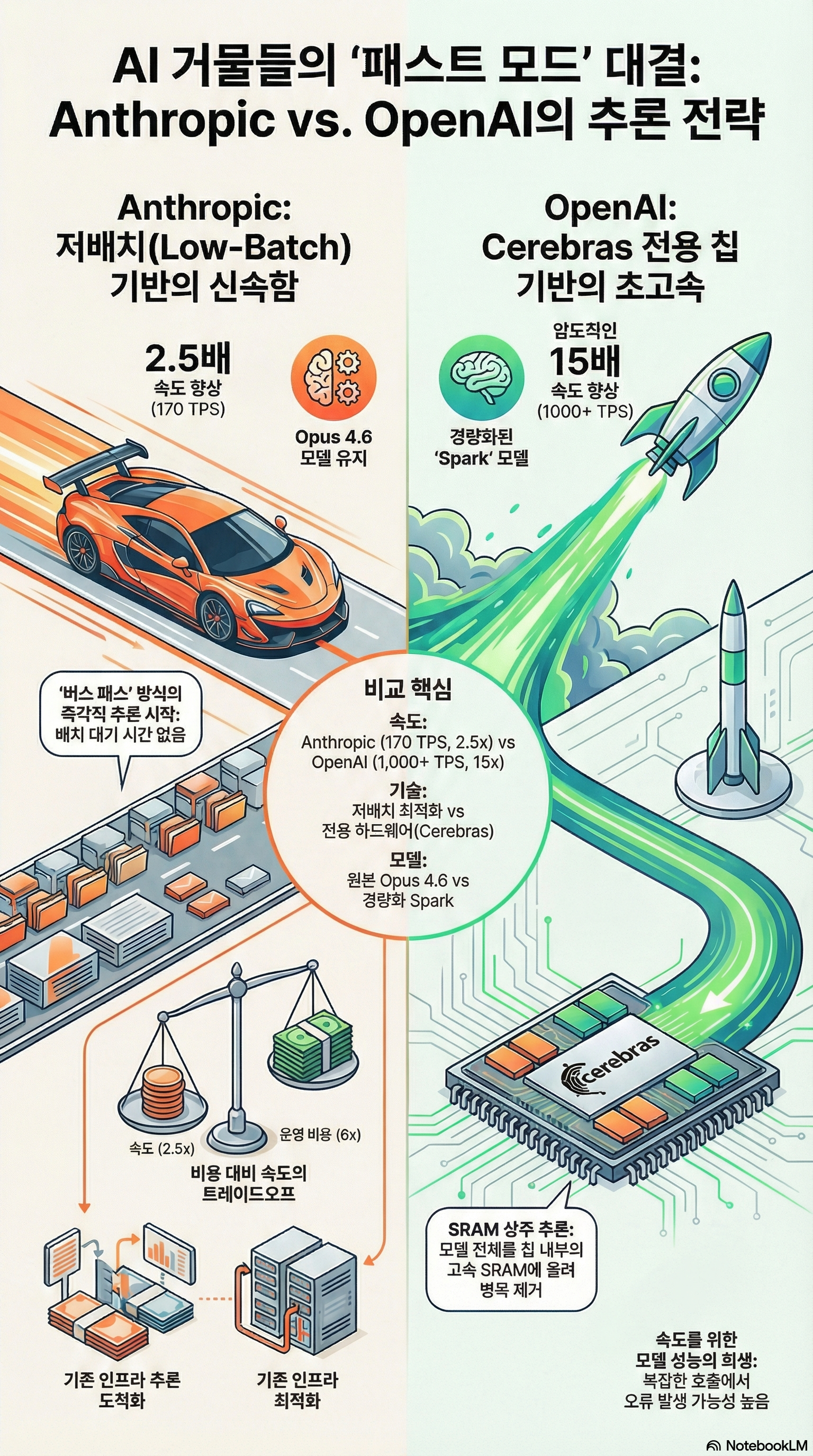

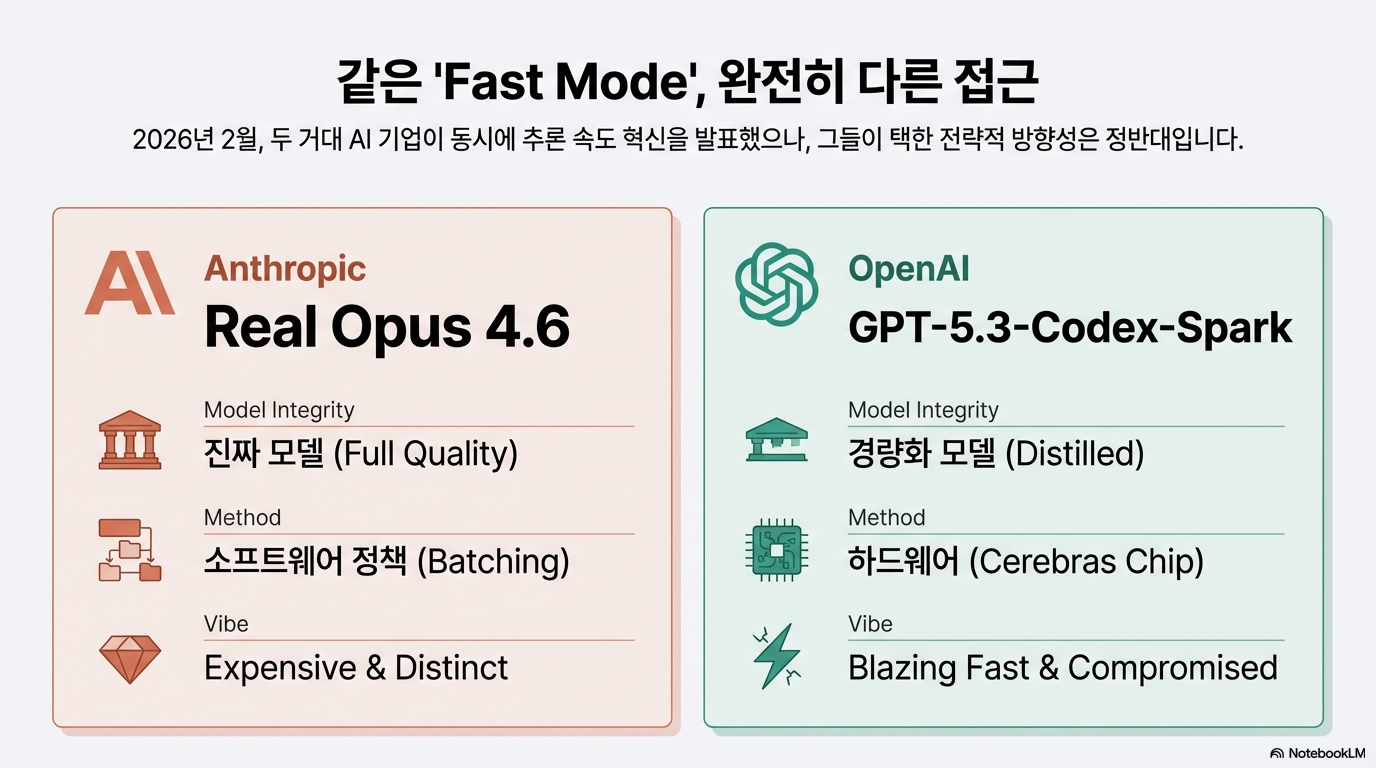

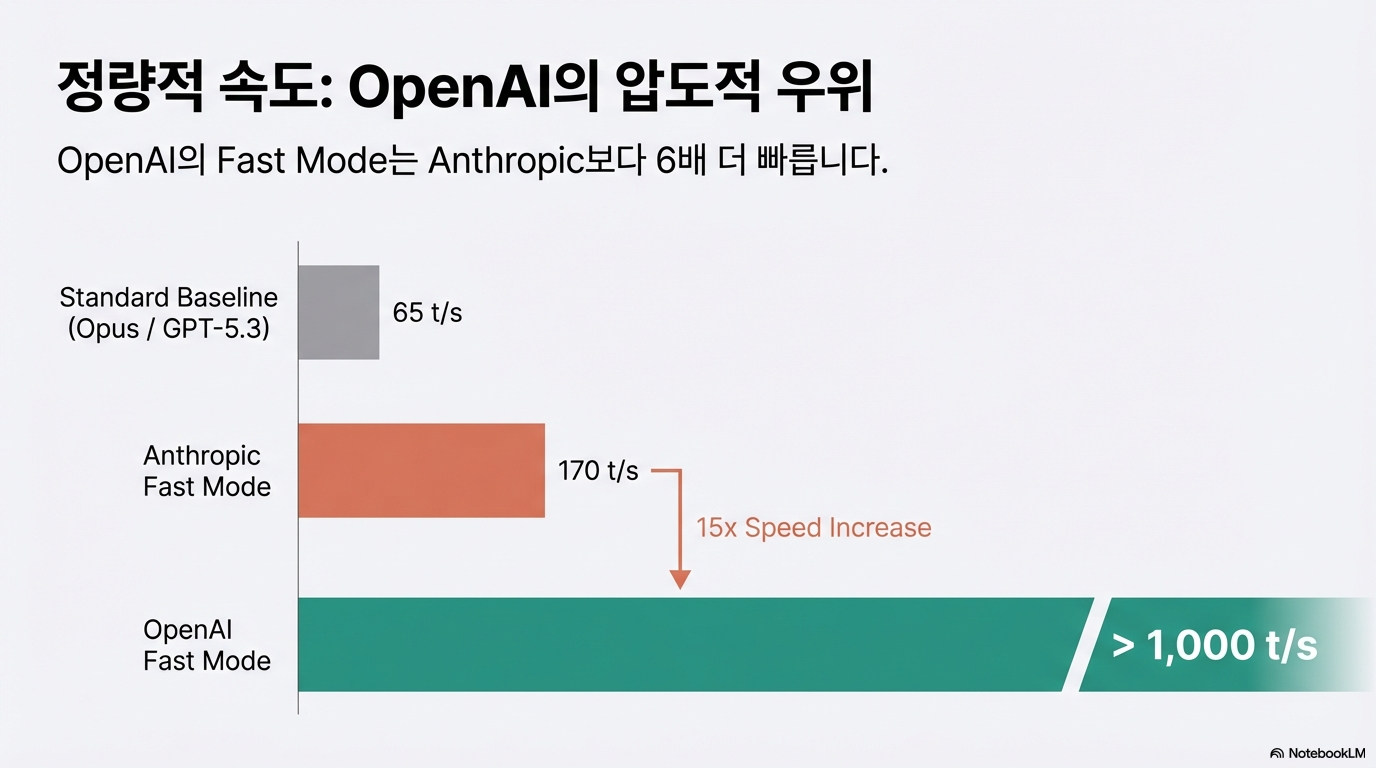

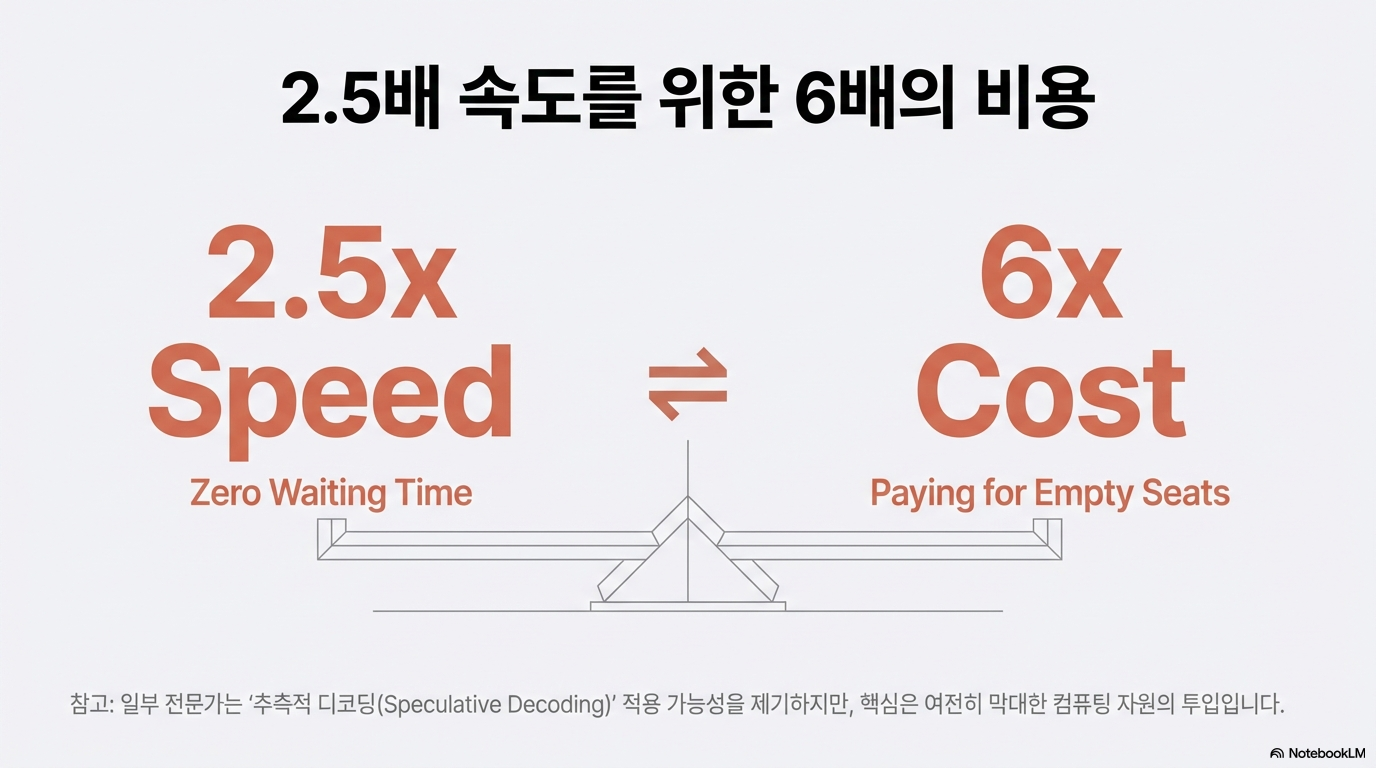

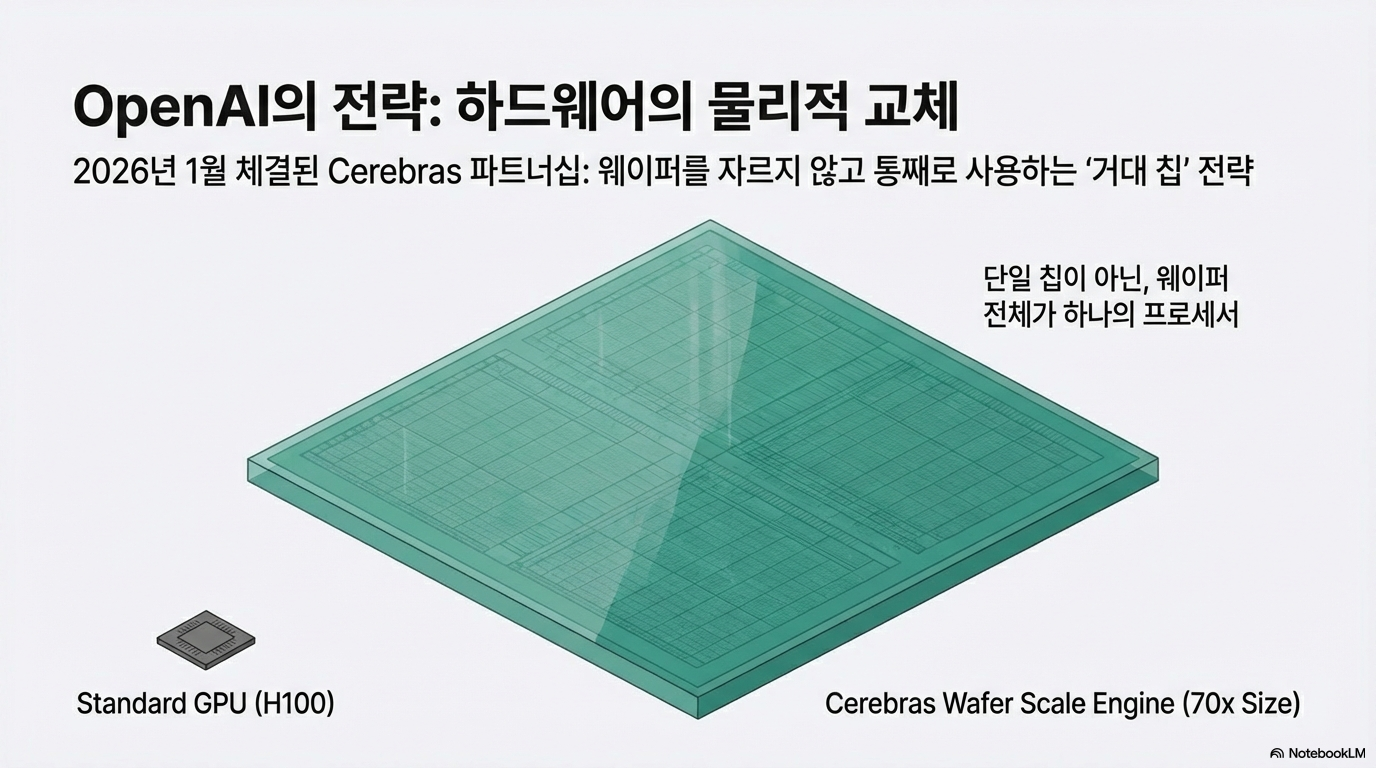

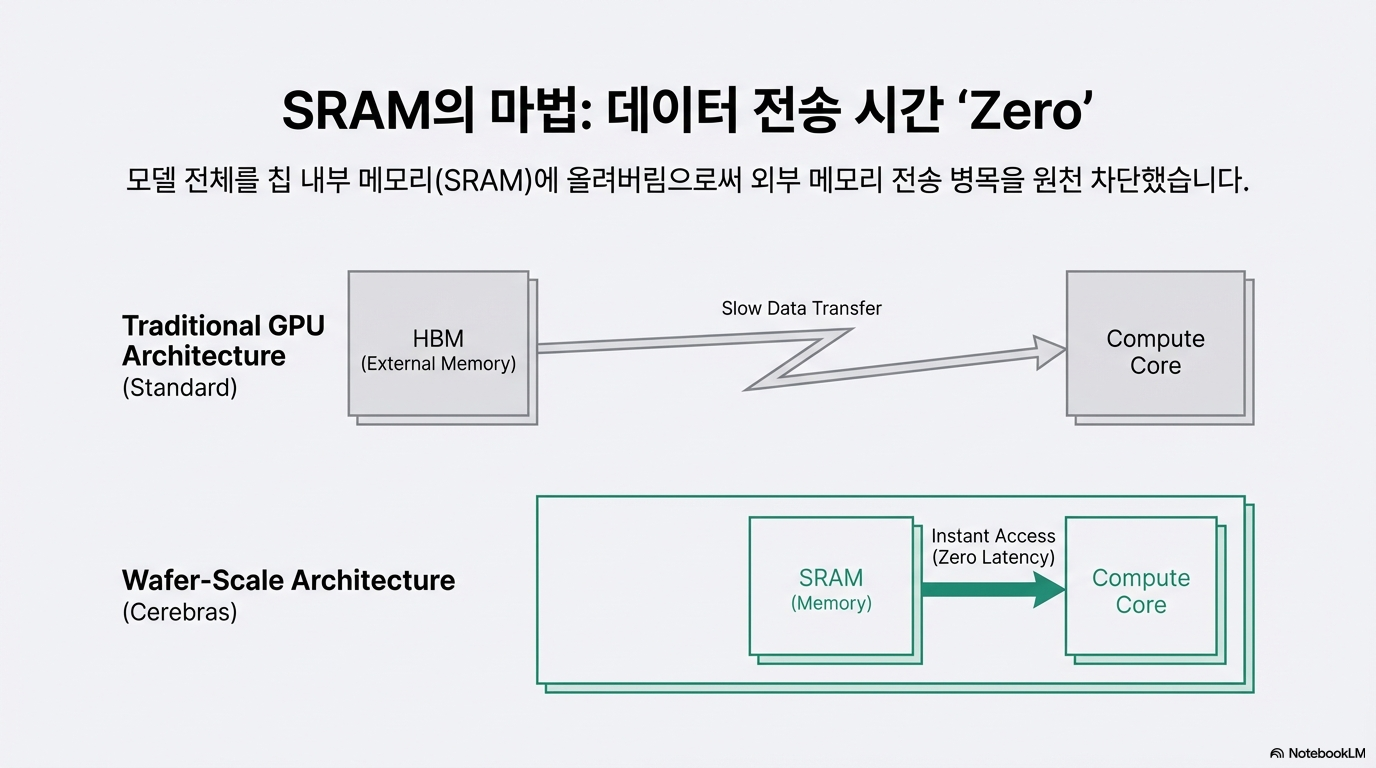

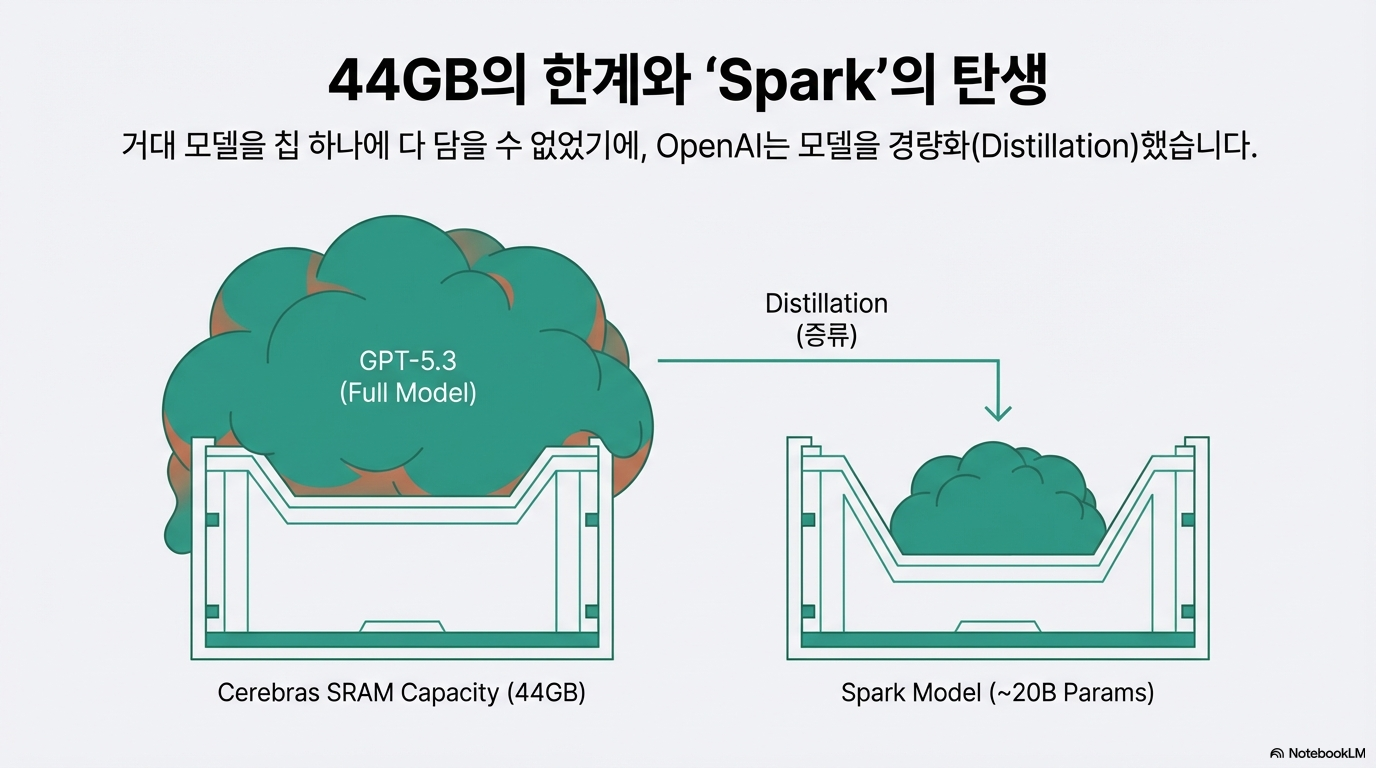

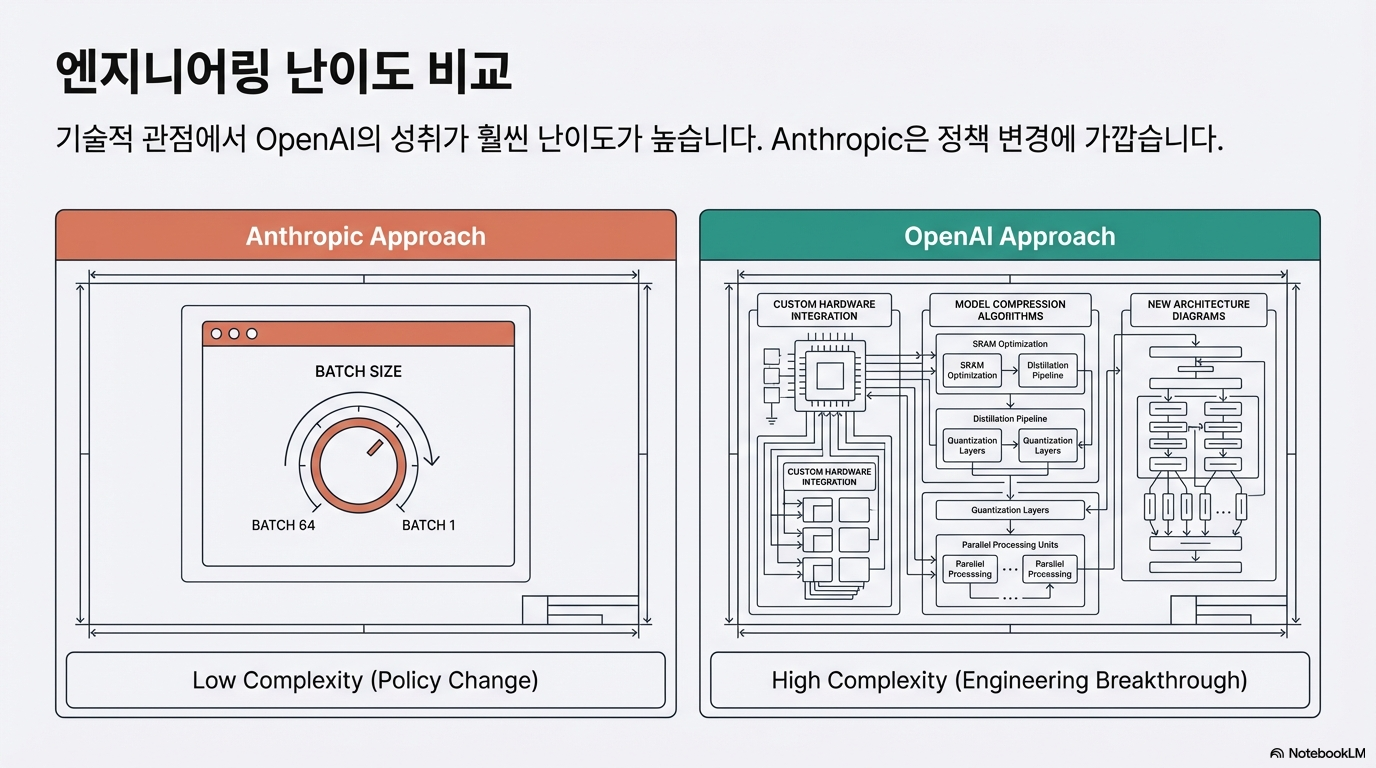

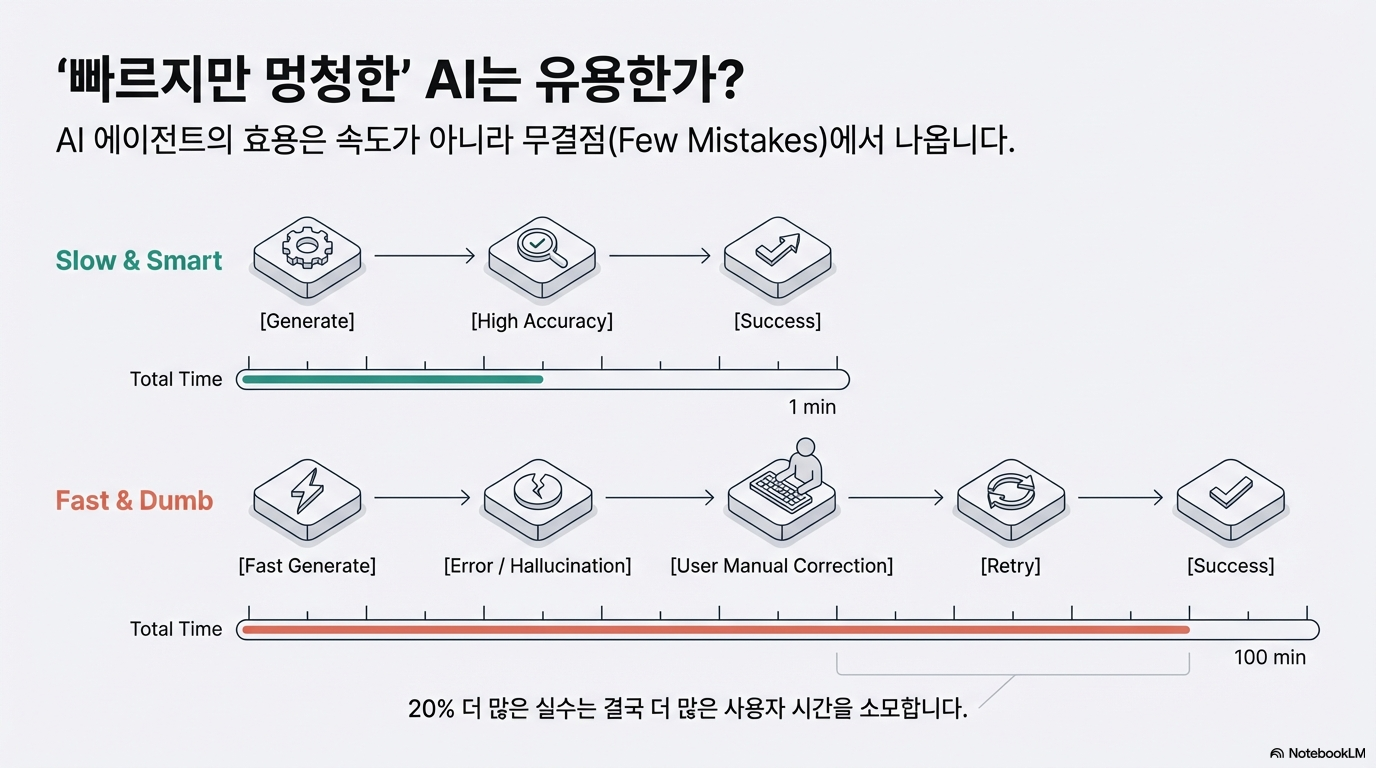

이 글은 인공지능 업계의 양대 산맥인 앤스로픽과 오픈AI가 출시한 '패스트 모드'의 기술적 차이점과 전략을 비교 분석합니다. 저자는 앤스로픽이 기존 모델의 배치 크기(Batch size)를 줄여 대기 시간을 제거하는 소프트웨어적 접근을 취했다고 설명합니다. 반면, 오픈AI는 세레브라스(Cerebras)의 거대 칩을 활용해 모델 전체를 메모리에 올리는 하드웨어적 혁신을 시도했으나, 그 과정에서 성능이 다소 낮은 경량화 모델을 사용하게 되었다고 지적합니다. 또한 이러한 속도 경쟁이 기술적 우위를 점하기 위한 심리전의 성격이 강하며, 사용자에게는 단순한 속도보다 모델의 정확도가 더 중요할 수 있음을 강조합니다. 마지막으로 빠른 추론 기술이 향후 AI 시스템의 보조적인 도구로 자리 잡을 가능성을 시사하며 글을 맺습니다.

1. 서론: LLM 추론 속도가 중요한 이유

원문 요지 해석

저자는 LLM을 실제 제품에 적용할 때 가장 큰 병목은 “추론(inference) 속도”라고 설명한다. 모델을 학습하는 비용보다, 실제 사용자 요청을 처리하는 속도와 비용이 더 중요한 문제가 된다는 점을 강조한다.

보완 설명 (2026년 기준)

2026년 기준으로 상용 LLM 서비스는 대부분 학습 비용보다 추론 비용이 운영비의 핵심으로 자리 잡았다. 특히 API 기반 SaaS, 에이전트형 시스템, 실시간 코파일럿 서비스에서는 다음이 중요하다:

- Latency(지연 시간): 사용자 체감 품질을 결정

- Throughput(초당 처리량): 단위 GPU당 수익성 결정

- Token 비용 구조: 긴 컨텍스트 사용 시 비용 급증

2025–2026년 사이 대형 모델(예: GPT-4급, Claude Opus급, Gemini Ultra급)은 컨텍스트 길이가 200k~1M 토큰까지 확장되면서 KV-cache 메모리 사용량이 급격히 증가했고, 이는 추론 비용 구조를 바꾸는 주요 요인이 되었다.

근거 및 출처

- OpenAI DevDay 발표 자료 (2024–2025) – 긴 컨텍스트 모델 및 추론 비용 구조

- Google DeepMind, Gemini Technical Report (2024–2025)

- NVIDIA, “Transformer Engine & Inference Optimization” 기술 문서 (2025)

- Microsoft Azure AI Infrastructure 보고서 (2026)

2. 추론 속도의 기본 구조: Prefill vs Decode

원문 요지 해석

LLM 추론은 크게 두 단계로 나뉜다:

- Prefill 단계: 입력 토큰 전체를 한 번에 처리

- Decode 단계: 토큰을 하나씩 생성

이 두 단계는 성격이 다르고 병목 지점도 다르다.

보완 설명

2026년 기준 추론 성능 최적화는 거의 항상 이 두 단계를 분리해서 분석한다.

(1) Prefill 단계

- 입력 전체를 한 번에 행렬 연산으로 처리

- GPU의 병렬 연산을 잘 활용

- 주로 연산량(compute bound) 문제

긴 컨텍스트 모델에서는 prefill FLOPs가 급증한다. 예를 들어 128k 토큰 입력은 8k 대비 연산량이 16배 이상 증가할 수 있다(어텐션 복잡도 O(n²) 구조 때문).

최근에는:

- FlashAttention-2

- PagedAttention

- RoPE scaling + Linear attention 변형

등이 도입되어 메모리 사용을 줄이고 연산 효율을 개선하고 있다.

(2) Decode 단계

- 토큰을 1개씩 생성

- KV-cache를 반복 사용

- GPU 연산보다 메모리 대역폭(memory bandwidth) 병목이 큼

특히 decode는 메모리 바운드(memory-bound) 작업이기 때문에, FLOPs가 아닌 HBM bandwidth가 성능을 좌우한다.

2025–2026년 NVIDIA H100/H200, AMD MI300X 같은 고대역폭 GPU가 LLM 추론 시장에서 각광받는 이유도 decode 최적화 때문이다.

근거 및 출처

- Dao et al., FlashAttention-2 논문 (2023–2024 업데이트)

- NVIDIA H100/H200 Architecture Whitepaper (2024–2025)

- AMD MI300X Technical Overview (2024)

- Microsoft, “Optimizing LLM Inference at Scale” (2025)

3. 배치(batch)와 병렬화 전략

원문 요지 해석

속도를 높이는 핵심은 배치를 잘 구성하는 것이다. 여러 요청을 동시에 묶어 GPU 활용도를 높인다.

보완 설명

2026년 LLM 서빙의 핵심은 Continuous Batching(연속 배치) 이다.

전통적 배치는 모든 요청이 동일 길이일 때 효율적이지만, 실제 서비스에서는:

- 입력 길이 다름

- 출력 길이 다름

- 요청 시점 다름

이를 해결하기 위해:

- vLLM의 PagedAttention 구조

- TensorRT-LLM의 dynamic batching

- Triton Inference Server 기반 스케줄링

이 도입되었다.

Continuous batching은 다음을 가능하게 한다:

- GPU 유휴 시간 최소화

- 토큰 단위 스케줄링

- 동적 메모리 재할당

이로 인해 GPU당 처리량이 2~4배 개선되는 사례가 2024–2026년 다수 보고되었다.

근거 및 출처

- vLLM GitHub & 논문 (UC Berkeley, 2023–2025 업데이트)

- NVIDIA TensorRT-LLM 문서 (2025)

- Anyscale Ray Serve 최적화 보고서 (2025)

4. KV Cache와 메모리 병목

원문 요지 해석

디코드 단계에서 가장 큰 문제는 KV cache가 GPU 메모리를 많이 차지한다는 점이다.

보완 설명

KV cache는 각 레이어의 key, value를 저장한다.

토큰 수 × 레이어 수 × hidden dimension에 비례하여 메모리가 증가한다.

예시 (70B 모델 기준 대략):

- 32 레이어

- hidden 8192

- 128k context

→ KV cache만 수십 GB 필요

2026년 기준 해결 전략:

- PagedAttention (메모리 페이지화)

- KV cache 압축 (8-bit, 4-bit)

- Speculative decoding으로 토큰 생성 수 감소

- Multi-query attention (MQA, GQA)

특히 GQA(Grouped Query Attention)는 메모리 사용을 크게 줄이며, LLaMA-2 이후 대부분의 상용 모델이 채택하고 있다.

근거 및 출처

- LLaMA 2 Technical Report (Meta, 2023)

- Mistral Architecture Notes (2024)

- vLLM 논문 및 기술 블로그 (2024–2025)

- NVIDIA Inference Optimization Guide (2026)

5. 양자화(Quantization)

원문 요지 해석

모델을 낮은 정밀도로 변환하면 속도와 메모리를 줄일 수 있다.

보완 설명

2026년 기준 실서비스에서는 다음이 일반적이다:

- INT8: 안정적, 정확도 손실 적음

- FP8: H100 이후 하드웨어 가속

- INT4 / GPTQ / AWQ: 경량 배포

양자화는:

- 메모리 사용 감소

- 메모리 대역폭 감소

- 더 큰 배치 가능

하지만 정확도 저하 위험이 있다. 최근에는 AWQ, SmoothQuant, QLoRA 기반 추론 최적화가 상용화 단계에 들어갔다.

근거 및 출처

- GPTQ 논문 (Frantar et al.)

- AWQ 논문 (MIT, 2023)

- NVIDIA FP8 Transformer Engine 문서 (2025)

- Hugging Face Inference Optimization Guide (2026)

6. 모델 크기 vs 지연 시간

원문 요지 해석

모델이 커질수록 속도는 느려진다. 단순히 큰 모델이 항상 좋은 선택은 아니다.

보완 설명

2026년 기준으로는:

- 7B–13B 모델: 온프레미스 및 엣지 배포

- 30B–70B 모델: 중대형 SaaS

- 100B+: 고정밀 API 서비스

실제로 많은 기업이 “최소한의 품질을 만족하는 가장 작은 모델” 전략을 채택한다.

Mixture-of-Experts(MoE) 구조는 파라미터는 크지만, 활성화되는 파라미터는 일부이기 때문에 추론 FLOPs를 줄인다. GPT-4계열, Claude 3계열, Mixtral 등이 MoE 기반으로 알려져 있다.

근거 및 출처

- Mixtral 8x7B Technical Report (Mistral, 2024)

- DeepSeek MoE 구조 설명 (2025)

- Anthropic Claude 3 시스템 카드 (2024–2025)

7. 결론: 빠른 추론의 본질

종합 보완 설명

2026년 기준 LLM 추론 최적화의 핵심은 다음 5가지로 정리된다:

- Prefill/Decode 분리 최적화

- KV cache 메모리 최적화

- Continuous batching

- 양자화

- 적절한 모델 크기 선택

추론 최적화는 단순히 “GPU를 많이 쓰는 문제”가 아니라:

- 메모리 대역폭

- 스케줄링

- 모델 구조

- 수치 정밀도

- 워크로드 특성

이 복합적으로 작용하는 시스템 엔지니어링 문제이다.

2026년 AI 인프라 경쟁의 핵심은 “누가 더 큰 모델을 만들었는가”가 아니라

“누가 더 싸고 빠르게 돌릴 수 있는가”로 이동하고 있다.

'07.AI' 카테고리의 다른 글

| 프롬프트 엔지니어 - 프롬프트 캐싱 (Prompt Caching) (0) | 2026.02.22 |

|---|---|

| LLM - 벤치마크 - 데이터셋 가이드 (0) | 2026.02.20 |

| LLM - 검색 증강 생성 (RAG) - Vertex AI Search - Ground Truth (1) | 2026.02.18 |

| LLM - 성능 - 벤치마크 - 벤치마크 데이터셋 현황 분석 및 정부 주도의 벤치마크 마련 필요성 (0) | 2026.02.14 |

| LLM - 검색 증강 생성 (RAG, Retrieval-augmented generation) (3) | 2026.02.02 |