오픈AI가 인공지능의 실질적인 경제적 가치를 평가하겠다는 목적으로 만든 새로운 벤치마크, GDPval을 발표했습니다.

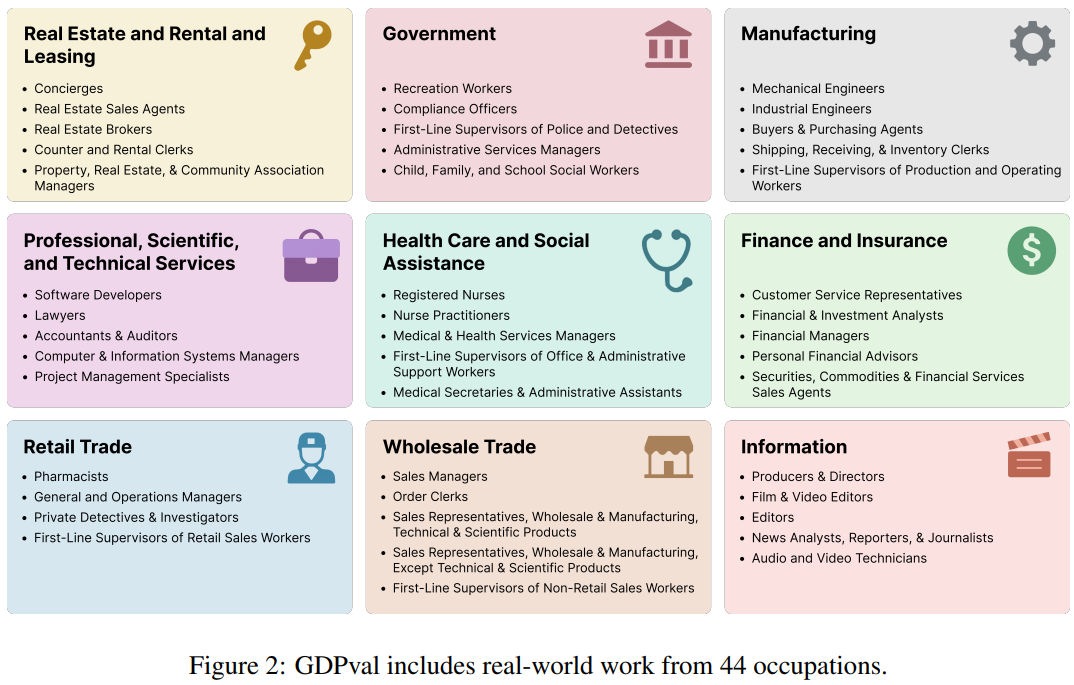

이 벤치마크는 미국 GDP 상위 9개 부문의 44개 직업에 걸쳐서 AI가 수행한 결과물을 평가합니다. 특히, 평균 약 14년 경력의 전문가가 산출한 결과물과 AI의 결과물을 비교하는 방식으로 이루어집니다.

오픈AI는 이 벤치마크를 통해서 경쟁 모델이 자사 모델을 능가하는 경우까지도, 대담하고도 투명하게 공개를 했습니다.

Abstract

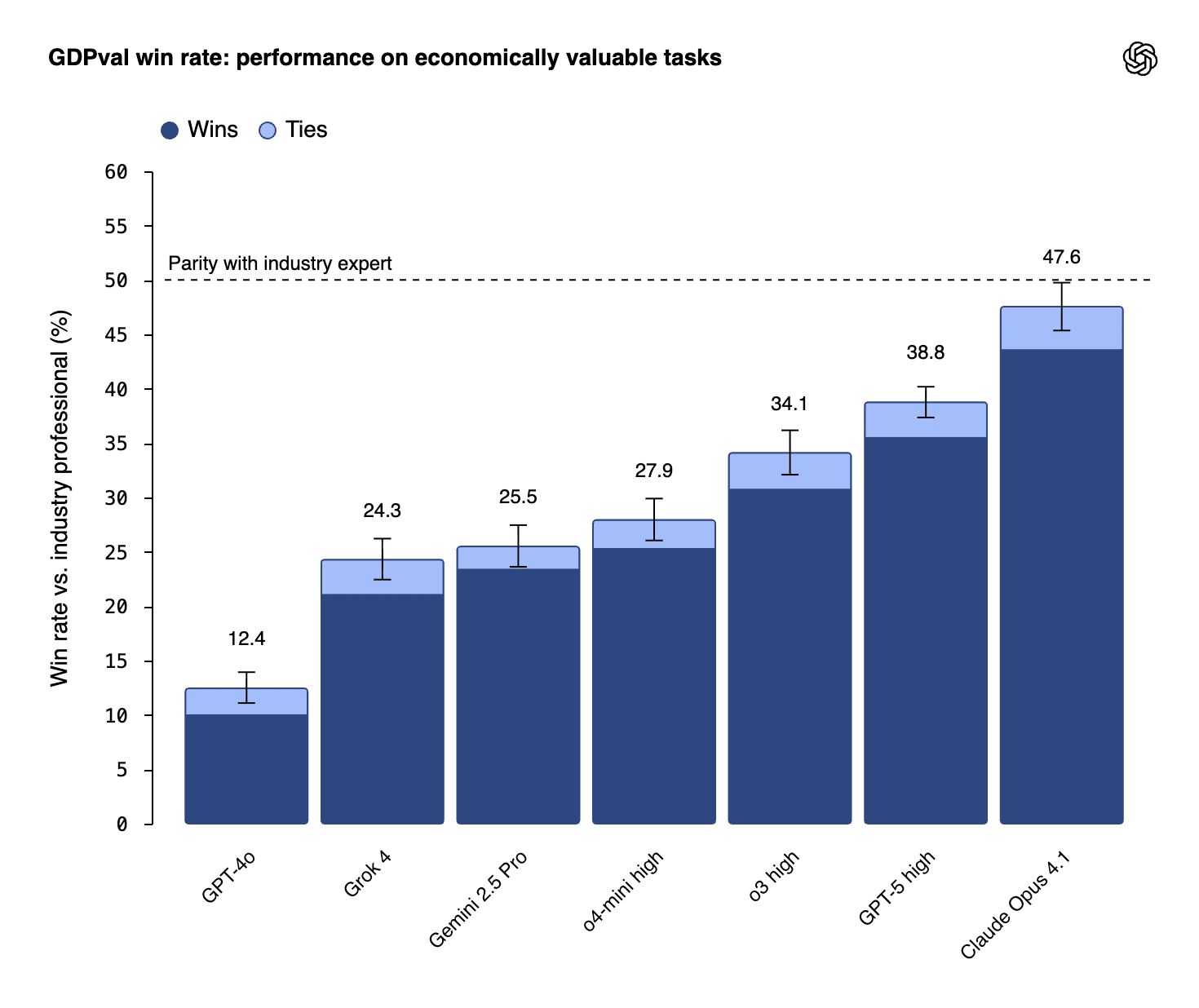

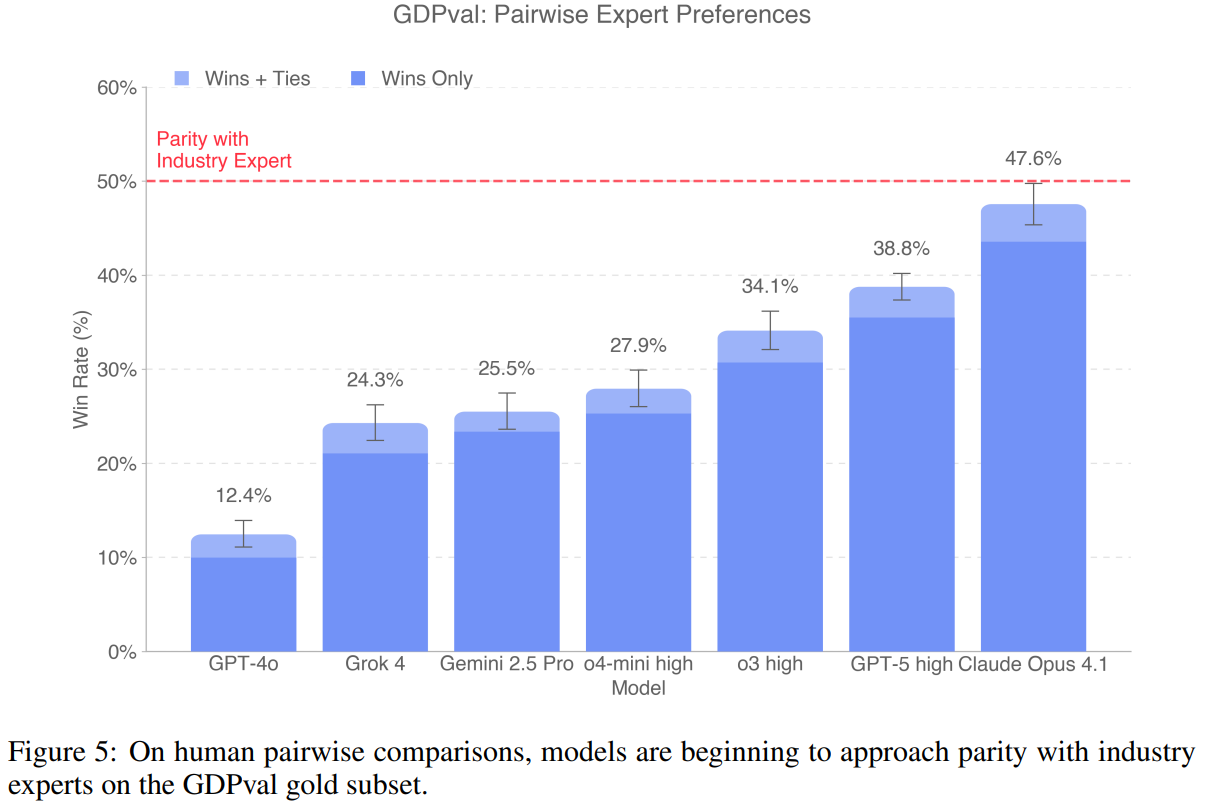

OpenAI는 실제로 경제적 가치가 있는 업무 산출물(real-world deliverables)에 기반해 AI 모델의 실무 성능을 측정하는 새로운 평가체계 GDPval을 공개했다. 초판은 미국 GDP에 기여도가 큰 9개 산업에서 44개 직업을 선정해, 총 1,320개의 과제(그중 220개는 공개된 'gold' subset) 를 만들고, 해당 과제들에 대해 직업별 전문가가 블라인드(익명) 방식으로 AI 결과물과 인간 전문가 결과물을 비교·채점하는 방식으로 실험을 수행한다. 초기(금집합 220과제) 결과에서 일부 최첨단 모델은 인간 전문가와 “동급 혹은 더 나은” 결과로 평가된 경우가 상당수 보고되었다(예: Claude Opus 4.1 ≈ 47.6% wins/ties 등). 그러나 GDPval은 one-shot 설정 등 설계상의 제약을 가지므로 결과 해석에는 주의가 필요하다. OpenAI+1

1. 서론 (배경과 목표)

전통적 벤치마크(예: MMLU 등)는 모델의 이론적·학술적 능력을 평가하는 데 유용했으나, 실무에서 요구되는 산출물(문서·도표·프레젠테이션·스프레드시트·멀티미디어 등)을 직접 평가하지 못한다는 한계가 있다. GDPval은 경제적 관점(‘GDP에 기여하는 직업군’)으로 출발하여, 현업에서 실제로 만드는 deliverable 중심으로 평가해 “AI가 실제로 산업·직무 수준의 가치를 낼 수 있는가”를 가시화하려는 시도다. OpenAI

2. 연구 질문(연구 의문)

- AI 모델은 특정 직업의 ‘실제’ 업무 산출물을 인간 전문가 수준으로 생성할 수 있는가?

- 어떤 직종·과제에서 모델이 상대적으로 강하고 약한가?

- 모델의 추론(inference) 속도와 API 비용만 고려할 때, 모델은 인간 대비 시간·비용에서 어느 정도의 이득을 제공하는가?

- 평가 설계(한 번의 제출/one-shot, 블라인드 비교 등)가 현실 적용 평가에 어떤 편향을 도입하는가? OpenAI

3. 데이터셋·과제 설계 (방법론 — 단계별 재현 서술)

아래는 OpenAI가 공식 문서에 기술한 단계별 작업 흐름을 재구성한 것(가능한 한 재현 가능하게 기술). 각 단계 끝에는 관련 공식 출처를 표기함.

3.1 전체 설계 개요

- 전체 목표: 경제적으로 중요한 직무 과제(knowledge-work deliverables)를 현실적으로 재현하여 모델 성능을 평가. OpenAI

3.2 단계 1 — 산업·직업 선택

- 산업 선택 기준: 미국 GDP에 기여도가 5% 이상인 산업 9개를 선택(연방준비은행(FRB St. Louis) 데이터 활용).

- 직업 선택 기준: 각 산업에서 총 임금·보상(총 보수)에 기여도가 큰 상위 5개 직업을 선택(2024년 5월 BLS 보고서 사용).

- 지식근로(knowledge work) 판정: O*NET의 직무(task) 데이터를 사용하여, 해당 직업의 구성 과제들 중 ≥60%가 비물리적 작업(physical/manual 작업 아님)일 경우 ‘주로 지식근로’로 분류. 이 과정으로 총 44개 직업이 선정됨. OpenAI

3.3 단계 2 — 과제(샘플) 설계 및 검수

- 과제 수: 각 직업에 대해 30개의 완전 심사된 과제(풀셋) 를 만들고, 그중 5개/직업(=220개) 를 골드 공개 셋(gold subset)으로 선정(총 1,320개 과제; 골드 220개).

- 작성자(태스크 라이터): 각 과제는 해당 분야의 경험 많은 전문가(평균 경력 ≈ 14년) 가 설계. 다양한 소스/서브도메인을 포괄하도록 구성.

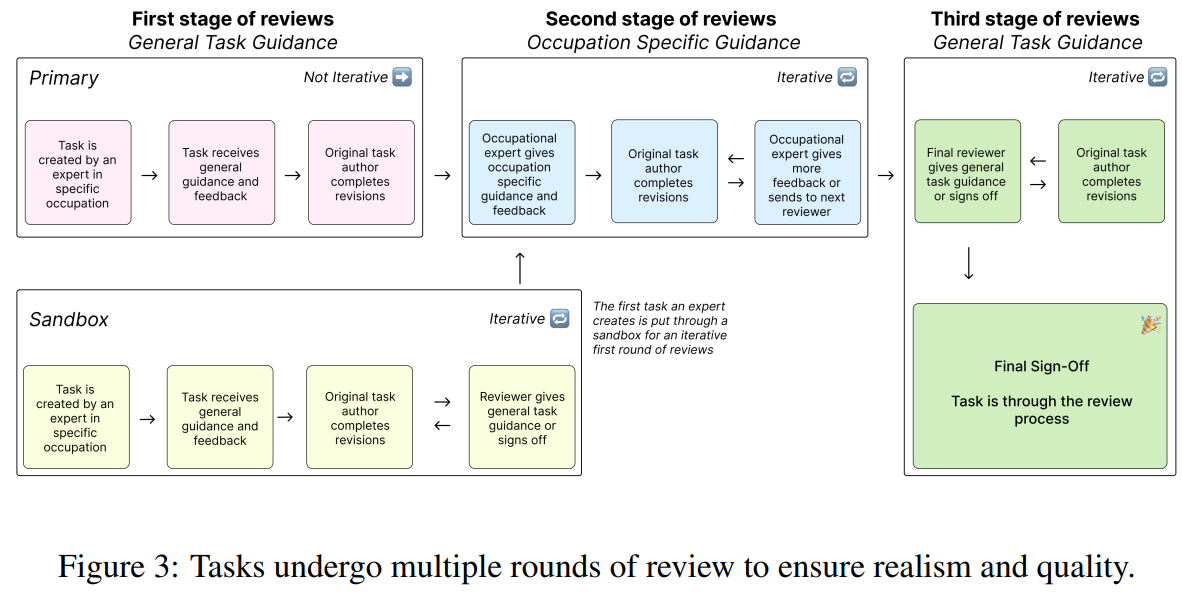

- 검토 과정: 각 과제는 평균 5회의 검토 라운드(다른 과제 작성자 리뷰, 직종별 추가 검토자, 모델 기반 검증 포함)를 거쳐 대표성·명확성 확보.

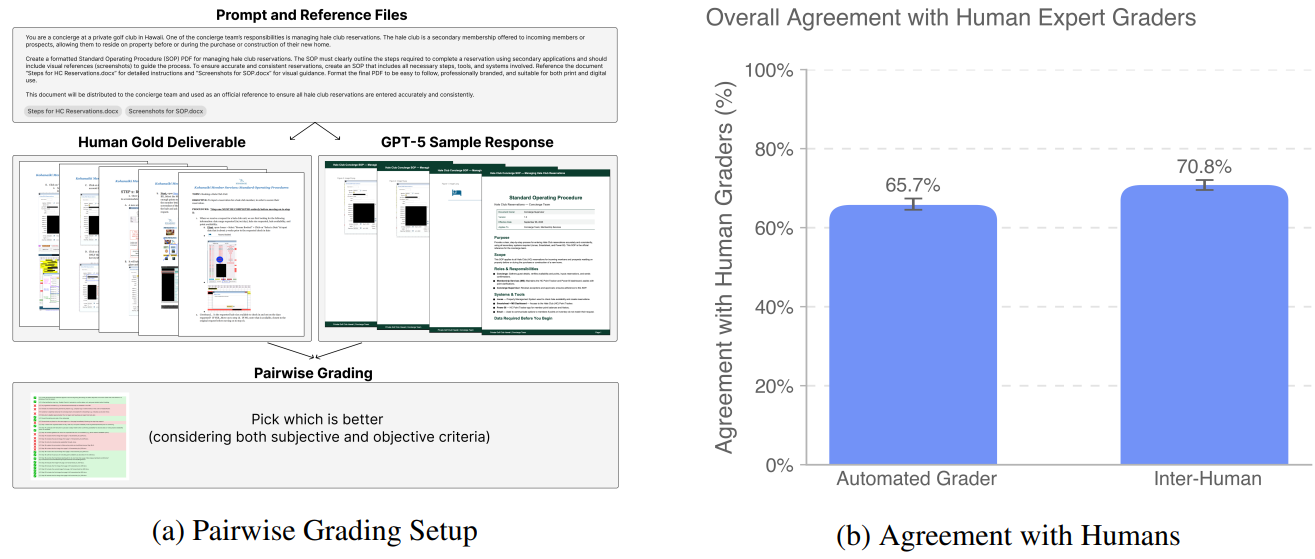

- 산출물 유형: 과제는 단순 텍스트 응답이 아닌, 참조 파일(문서·도표·데이터), 산출물 형식(프레젠테이션·PDF·스프레드시트·도면·오디오·비디오 등)을 명시함. 과제에는 ‘경험 많은 인간 작성자의 모범(고급) 산출물(gold deliverable)’이 함께 제공된다. OpenAI

3.4 단계 3 — 모델 응답 생성

- 시험에 사용된 모델 목록: GPT-4o, o4-mini, OpenAI o3, GPT-5 (여러 설정·variant 포함), Claude Opus 4.1, Gemini 2.5 Pro, Grok 4 등 선도 모델들이 포함됨.

- 호출/설정: 각 과제에 대해 동일한(또는 문서화된) 프롬프트·컨텍스트를 사용해 모델로부터 산출물을 생성. (공식 문서에 모델별 정확한 하이퍼파라미터·추론 설정은 공개되지 않음 — 이 항목은 아래에서 모른다고 명시.) OpenAI

3.5 단계 4 — 채점(블라인드 비교) 프로토콜

- 채점자 모집: 동일 직종(또는 동종 분야)의 경험 많은 전문가들(평균 경력 14년)을 ‘채점자(grader)’로 모집.

- 블라인드 비교: 채점자는 모델 출력물과 인간(태스크 라이터)가 작성한 산출물(두 개) 을 보며 출처(사람/AI)를 알 수 없도록 블라인드로 비교.

- 판정 항목: 채점자는 각 쌍을 “더 좋다 (better)”, “동급 (as good as / tie)”, “더 못하다 (worse)”로 분류. 또한 각 직종별로 작성된 상세 루브릭(rubric)에 따라 품질 세부항목을 평가(루브릭은 과제 작성자가 설계).

- 자동 채점기: 반복적·대량 검토를 위해 OpenAI는 사람 채점자를 예측하도록 훈련한 실험적 ‘자동 채점기(automated grader)’ 도 개발하여 evals.openai.com을 통해 연구 서비스로 공개했으나, 공식 문서는 자동 채점기가 사람을 대체할 정도로 신뢰할 만하진 않다고 밝힘. OpenAI+1

3.6 단계 5 — 집계 지표 및 통계 처리

- 주요 지표: (a) wins (AI가 인간보다 좋음), (b) ties (동급), (c) losses (AI가 인간보다 못함). 통상 'wins or ties' 비율(=AI가 인간과 동급 이상으로 평가된 비율)을 핵심 성능 지표로 사용.

- 신뢰성/합의: (공식 PDF 내 기술) 모델의 최종 인간 간 일치(inter-rater agreement)는 '적어도 두 명 이상의 인간 채점자가 존재하는 샘플'에 대해 샘플 단위 합의 점수를 평균하여 산출한다고 명시함(정확한 채점자 수 분포는 문서 내에 전체 분포로 명시되지 않음). cdn.openai.com+1

4. 실험 설정(요약)

- 데이터셋: GDPval full set (1,320 tasks) 및 gold subset (220 tasks). 공개된 참조 파일·gold set은 HuggingFace 등에서 접근 가능(공개된 파일과 참조문서 포함). Hugging Face+1

- 모델: GPT-4o, o4-mini, o3, GPT-5 (variants 포함), Claude Opus 4.1, Gemini 2.5 Pro, Grok 4 등. OpenAI

- 채점: 동일 직업군의 전문가들이 블라인드 쌍비교 방식으로 채점. 자동 채점기는 실험적 도구로 병행 사용. OpenAI

5. 주요 결과 (정량적 요약)

아래 수치는 OpenAI의 발표자료(웹페이지 및 논문·부록)와 주요 보도 자료를 근거로 한 요약이다. 보도마다 소수점 표기나 모델 variant 표기가 달라 약간의 차이가 존재함 — 그 경우 출처를 함께 표기함.

- Gold subset(220 tasks) 결과(요약): Claude Opus 4.1이 **대략 47.6%**의 'wins or ties' 비율을 기록(골드 집합 기준, fig.5). GPT-5 계열은 기사·보도에 따라 약 38.8% ~ 40.6% 범위로 보도(일부 보도는 GPT-5-high 등 variant를 구분). OpenAI는 전반적으로 “frontier 모델들이 산업 전문가의 산출물 수준에 근접한다”라고 보고함. cdn.openai.com+2OpenAI+2

- 시간·비용: OpenAI는 단순 inference 시간 및 API 청구 기준으로 모델이 인간 전문가보다 약 100배 빠르고 100배 저렴할 수 있다고 계산했으나, 이 수치는 인수(assumption) 가 명확히 한정되어 있으며 사람의 감독·반복·시스템 통합 비용 등은 제외되어 있음(따라서 실무 비용절감 효과는 더 복잡함). OpenAI

- 추세: GPT-4o → GPT-5로의 성능 향상은 뚜렷하여(한 해 내에 여러 모델의 성능이 크게 개선됨), OpenAI는 모델 크기·추론 전략·더 나은 프롬프트·맥락 제공 등이 성능 개선에 기여한다고 보고함. OpenAI

6. 해석(논의) — 의미와 함의

- 벤치마크 패러다임의 전환: GDPval은 ‘실제 산출물’ 기반 평가로 AI 성능 측정의 시각을 바꾼다. 이는 기업·정책결정자가 ‘업무 생산성’ 관점에서 AI를 판단하는 데 더 직접적인 근거를 제공한다. OpenAI

- 산업·직무별 불균형: 일부 직무(예: 리테일·물류·반복적 문서 작업 등)에서는 모델이 비교적 강했고, 고도의 창의성·현장 물리작업·연속적인 피드백 루프가 필요한 과제에서는 한계가 명확함(원문에 걸친 직종별 성과 차이는 세부 표/그림 참조). OpenAI

- 자동화의 경제적 의미: 'wins/ties' 비율과 단순 inference 비용 비교로는 ‘자동화로 인한 고용 영향’을 직접 추정할 수 없다. 실제 채택·통합에는 데이터 파이프라인, 안전성 보장, 인간 감독, 법적/윤리적 제약, 조직 내부 저항 등 다층적 비용이 존재한다. OpenAI도 이 점을 명시함. OpenAI

7. 한계(명확히 기술) — 공식 문서·논문에 기재된 한계와 공개되지 않은 항목

7.1 GDPval이 스스로 밝힌 한계 (공식)

- One-shot 평가: 현재 버전은 ‘한 번의 제출’ 설정이므로, 반복적 피드백·맥락 확장·장기 프로젝트 수행 능력 등 실무의 다중 라운드 과정을 포착하지 못함. OpenAI

- 표본 범위 제한: 미국 GDP 기여 기준·지식근로 중심으로 샘플 편향 존재 — 비(非)미국적 직무·현장 중심 작업·물리적 노동은 제외됨. OpenAI

- 채점 주관성: 전문가 판정에 의존하므로 주관성·루브릭 설계 편향의 가능성이 있다. OpenAI는 루브릭·다중 검토를 통해 이를 줄이고자 했으나 완전히 제거되지는 않음. OpenAI

7.2 문서화/공개되지 않은(또는 모호한) 항목 — 모른다로 명시

아래 항목들은 공식 문서·공개 자료에서 명확한 숫자·세부 절차가 확인되지 않아 모른다:

- 과제별(샘플별) ‘정확한’ 채점자 수 분포(평균/중앙값/분포): 공식 문서는 "최소 2명의 채점자가 있는 샘플"과 같이 기술하나, 샘플별로 몇 명이 실제로 채점했는지 전체 분포(예: 평균 3.2명, 표준편차 등)는 공개되어 있지 않음. 모른다. cdn.openai.com

- 채점자 선발·보상 세부: 채점자 모집·선발의 구체적 알고리듬(선별 기준의 정량화), 채점자 보수/보상 수준(시간당 얼마 등)은 문서에 상세히 나오지 않음. 모른다. OpenAI

- 모델별 정확한 추론(인퍼런스) 설정 및 비용 산출 상세: OpenAI는 ‘100x 빠름/저렴’ 등 수치를 제시했지만, 각 모델의 구체적 추론 설정(예: tokens, temperature, test-time compute 등)과 총 시스템 통합 비용(감독·검토 등 포함)을 반영한 총비용 산정방법의 상세는 공개되어 있지 않음. 따라서 “실제 도입시 총비용 절감”은 문서가 제시한 수치보다 작을 가능성이 크다. 모른다. OpenAI

- 골드셋 이외의 전체 샘플에 대한 공개된 라벨·원문(전부): HuggingFace 등에서 일부 자료가 공개되어 있으나, 모든 참조 파일·원본이 공개 라이선스 하에 완전하게 제공되었는지(또는 일부 민감파일이 제거되었는지)는 자료별로 다르며 명확하지 않음. 모른다. Hugging Face

8. 재현 가능성 체크리스트 (연구 재현을 위해 필요한 항목)

(실무에서 동일 실험을 재현하려면 아래 항목들이 필요 — 공개 여부 표기 포함)

- 데이터셋(과제·참조파일) — 부분 공개(골드 220과제 등), 전체 공개 여부는 부분적으로 확인 가능. Hugging Face

- 채점자 목록·배경·보수·채점수 분포 — 미공개 / 모른다. OpenAI

- 모델 버전·variant·추론 파라미터(각 실험별) — 일부 모델명은 공개되었으나 variant별 정확한 설정은 문서화 부족. 모른다. OpenAI

- 루브릭(채점 가이드) — 직업별 루브릭은 존재하며 일부가 문서화되어 있음(공식 문서 언급), 그러나 전체 루브릭 파일 공개 여부는 과제별로 다름. OpenAI+1

9. 결론 및 제언

- 요약: GDPval은 AI 성능 평가를 ‘실제 경제적 가치’ 관점으로 옮긴 의미 있는 시도이며, 초기 결과는 일부 최첨단 모델이 인간 전문가와 동등하거나 근접한 성과를 보이는 직무가 존재함을 보여준다. OpenAI+1

- 정책·기업 관점 제언: GDPval 결과는 투자·도입 판단의 한 가지 증거로 유용하나, 조직은 통합비용(감독·반복·신뢰성·법적 책임 등)을 반드시 모델 단순 추론비용 외에 포함해 총체적 ROI를 계산해야 한다. OpenAI

- 연구 제언: 향후 버전은 다회차 반복(interactive workflows), 장기 프로젝트, 비미국권 직무, 물리적 작업과의 연계 등을 포함해 외연을 넓혀야 실무적 타당도가 더 커질 것이다. OpenAI

10. 주요 인용(참고자료) — (원문·보도)

- OpenAI — Measuring the performance of our models on real-world tasks (GDPval announcement page). OpenAI

- OpenAI — GDPval paper / technical report (PDF). cdn.openai.com

- OpenAI Evals (automated grader · experimental service) — evals.openai.com. evals.openai.com

- Axios (보도: GDPval 요약 및 주요 수치 보도). Axios

- TechRadar / TechCrunch / 기타 언론 (보도·해설). TechRadar+1

- HuggingFace dataset (openai/gdpval) — 공개 참조파일 일부 확인 가능. Hugging Face

부록 A — “단계별(핵심 절차)” (요약)

- 산업 선정 (GDP 기여 > 5% 산업 → 9개) → 직업 선정(산업별 상위 5개, 총 44개). OpenAI

- 각 직업별 과제 설계(30개), 골드셋 5개/직업(=220). 라이터는 평균 경력 14년 전문가. 각 과제 5회 검토. OpenAI

- 모델 응답 수집(GPT-4o → GPT-5, Claude 등). OpenAI

- 블라인드 쌍비교 방식으로 전문가 채점(더 좋음/동급/더 못함), 루브릭 사용. 자동 채점기는 보조. OpenAI

- 지표 집계(wins/ties/losses), 샘플 수준 inter-rater 처리(최소 2명의 채점자 샘플 기준 평균).

https://cdn.openai.com/pdf/d5eb7428-c4e9-4a33-bd86-86dd4bcf12ce/GDPval.pdf

'12. 메일진' 카테고리의 다른 글

| 2025 - State of AI Report 2025 (0) | 2025.10.26 |

|---|---|

| ITFIND 메일진 제1236호 산업분야별 정보메일 (발행 : 2025-10-24 ) (0) | 2025.10.26 |

| ITFIND 메일진 제1234호 산업분야별 정보메일 (발행 : 2025-10-03 ) (1) | 2025.10.04 |

| 2025 - AX 대응(AI Ready)을 위한 AI 에이전트 활용 방안 : 새로운 '디지털 노동력, AI 에이전트'를 왜 활용해야 하는가? (0) | 2025.09.28 |

| 2025 - 스탠퍼드대학 인간중심 AI연구소(HAI) 2025년 AI 지수 보고서 (0) | 2025.09.28 |