728x90

반응형

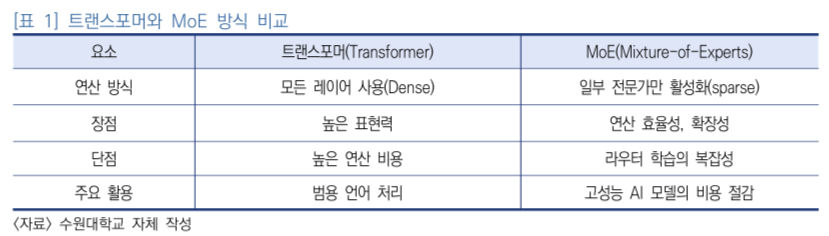

(개념) 인공 신경망 내에서 입력 샘플마다 다른 하위 네트워크(전문가)를 활성화하는 방식으로 작동하는 기법

(활용)

- DeepSeek-V3는 MoE 구조를 이용해서 6,710억개의 매개변수를 활용합니다

- Google의 Gemini 1.5 Pro는 희소 MoE 트랜스포머(Sparse MoE Transformer)를 사용하여 백만개 영역에 대한 예외를 처리하도록 처리합니다.

- Mistral의 Mixtral 8×22B는 각각의 레이어마다 8개의 전문가에게 허용할 수 있어서 비용, 속도 면에서 밀도가 높은 모델보다 우수한 성능을 보여줍니다.

- 20조로 훈련한 3,250억 범위의 MoE인 바바의 Qwen2.5-Max는 반발력과 코딩 능력을 보여주면서 Chatbot Arena에서 상위권에 순위를 유지합니다.

- 메타의 Llama 4는 멀티모달 및 다국어 작업으로 분류 4,000억 파라미터의 Maverick과 2조 파라미터의 Behemoth를 포함하는 모델에 맞춰서 MoE

(차세대 MoE 디자인)

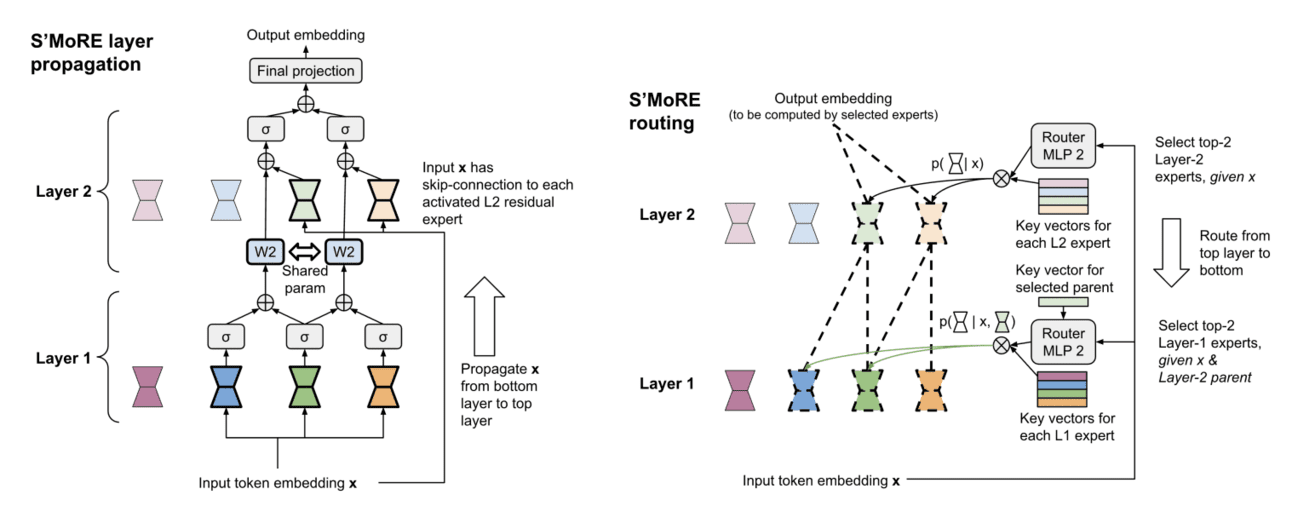

- S'MoRE(잔류 전문가의 구조적 혼합)

4월에 계시는 방식으로 진행되는 관계인데, LoRA의 낮은 순위 어댑터를 반대하는 MoE 트리와 참여하는 방법을 보여줍니다. 밀집형 (Dense) 모델이 따라가기 힘든, 지수적인 수준의 '구조적 적'을 표시합니다. - Symbolic-MoE (노스마다 대학, Chapel Hill)

MoE를 그래디언트 공간에서 새로운 언어 공간으로 이동 알림, GPT-4o-mini보다 더 높은 참여로 수행하고, 배치 가능(일괄 추론) 덕분에 단일 GPU 대체 16개의 전문가를 시작할 수 있습니다.

728x90

'07.AI' 카테고리의 다른 글

| 생성형 AI - AI Scientist (0) | 2025.06.30 |

|---|---|

| 생성형 AI - ResearchAgent (1) | 2025.06.30 |

| LLM - 알리바바, 제로서치(ZeroSearch) (2) | 2025.06.15 |

| 기초 모델 (FM, Foundation Model) - 생성형 AI (5) | 2025.06.12 |

| 데이터 시장 - 데이터 파운드리(Data Foundry) (0) | 2025.06.07 |