△MMMU(Massive Multi-discipline Multimodal Understanding) : 다양한 분야의 대학 수준 과제로 멀티모달 AI 모델을 평가, △GPQA(Graduate-level Google-Proof Q&A Benchmark) : 언어 모델의 고급 추론 능력 평가

△SWE(SoftWare Engineering)-bench : 코드작성, 버그수정, 코드리뷰 등 SW개발 작업에서 AI 모델을 평가

△HLE(Human Last Exam) " 인류의 마지막 난제로 구성되어 50%이상 점수면 AGI로 평가

MMMU (대규모 다분야 멀티모달 이해 및 추론)

개요

MMMU는 전문 인공일반지능(AGI)을 목표로 하는 대규모 멀티모달 모델의 전문적인 멀티모달 이해 능력을 평가하기 위해 신중하게 큐레이션된 새로운 벤치마크입니다.

- 대학 수준의 주제 지식과 신중한 추론을 요구하는 대규모의 다분야 작업에서 멀티모달 모델을 평가하기 위해 설계되었습니다.

- 미술 및 디자인, 비즈니스, 과학, 건강 및 의학, 인문 및 사회 과학, 기술 및 공학의 6가지 핵심 분야를 다룹니다.

- 대학 시험, 퀴즈 및 교과서에서 수집한 11.5K개의 멀티모달 질문이 포함되어 있습니다.

- 차트, 다이어그램, 지도, 테이블, 악보, 화학 구조 등 30가지의 매우 이질적인 이미지 유형을 포함합니다.

- 전문가 수준의 시각적 지각 능력과 주제별 지식을 통한 신중한 추론 모두를 요구합니다.

주요 통계

- GPT-4V는 56%의 정확도를 달성하여 개선의 여지가 큼을 시사합니다.

- MMMU-Pro라는 더욱 강력한 버전이 향상된 평가를 위해 도입되었습니다.

- 시판 중인 다양한 모델들의 성능을 평가한 결과, 사진 및 그림과 같이 학습 중에 더 자주 보이는 범주에서는 오픈 소스 모델이 비교적 강력한 성능을 보였지만, 기하학적 모양, 악보 및 화학 구조와 같이 덜 일반적인 이미지 범주에서는 모든 모델이 매우 낮은 점수를 얻었습니다.

평가 기술

MMMU는 LMM의 지각, 지식 및 추론의 세 가지 필수 기술을 측정하도록 설계되었습니다.

- 모델이 다양한 양식에서 정보를 인식하고 이해할 수 있을 뿐만 아니라 주제별 지식을 통해 추론하여 솔루션을 도출하는 능력을 평가하는 것을 목표로 합니다.

- 평가는 제로샷 설정에서 수행되어 모델이 벤치마크에 대한 미세 조정 또는 퓨샷 데모 없이도 정확한 답변을 생성하는 기능을 평가합니다.

GPQA (대학원 수준의 Google 방지 Q&A 벤치마크)

개요

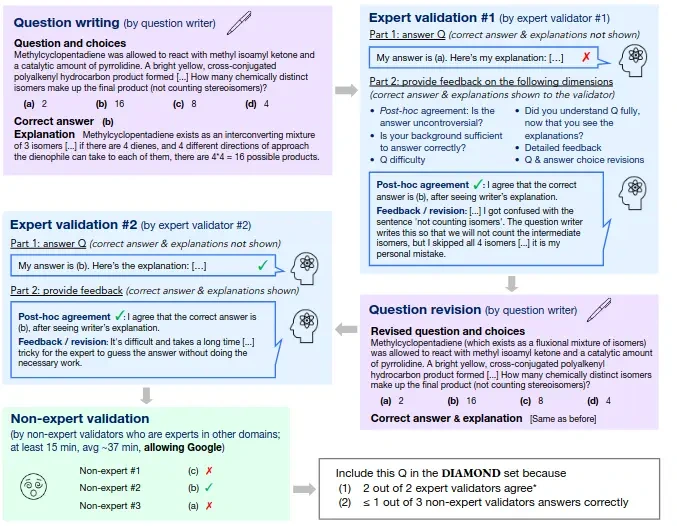

GPQA는 생물학, 물리학 및 화학 분야의 도메인 전문가가 작성한 448개의 객관식 질문으로 구성된 도전적인 데이터 세트입니다.

- 이 질문은 고품질이고 매우 어렵습니다. 해당 분야에서 박사 학위를 취득했거나 취득 중인 전문가가 65%의 정확도에 도달하는 반면, 숙련된 비전문가 검증자는 웹에 대한 무제한 액세스(즉, 질문이 "Google 방지"임)를 통해 평균 30분 이상을 소비했음에도 불구하고 34%의 정확도에만 도달합니다.

- 숙련된 비전문가와 최첨단 AI 시스템 모두에게 GPQA의 어려움은 현실적인 확장 가능한 감독 실험을 가능하게 하며, 이를 통해 인간 전문가가 인간 능력을 능가하는 AI 시스템으로부터 신뢰성 있게 진실된 정보를 얻을 수 있는 방법을 고안하는 데 도움이 될 수 있기를 바랍니다.

- 데이터 세트에는 BigBench 카나리아 문자열의 상위 집합인 카나리아 문자열이 포함되어 있습니다.

성능

- GPT-4 기반 기준선은 39%의 정확도를 달성합니다.

- 도메인 전문가(해당 분야의 박사 학위 소지자)는 65%의 정확도를 달성합니다(전문가가 회고적으로 식별한 명백한 실수 제외 시 74%).

- 숙련된 비전문가 검증자는 34%의 정확도에만 도달합니다. 이들은 웹에 대한 무제한 액세스를 통해 평균 30분 이상을 소비했음에도 불구하고 이 점수를 얻었습니다.

목적

GPQA는 숙련된 비전문가와 최첨단 AI 시스템 모두에게 어려운 과제를 제시함으로써 확장 가능한 감독 실험을 현실적으로 수행할 수 있도록 하여 인공지능 시스템이 인간의 능력을 능가하더라도 인간 전문가가 신뢰할 수 있는 방식으로 진실된 정보를 얻을 수 있는 방법을 모색할 수 있도록 지원합니다.

SWE (소프트웨어 엔지니어링)

개요

SWE는 소프트웨어 엔지니어링과 관련된 다양한 벤치마크를 나타냅니다. 여기에는 다음이 포함됩니다.

- SWE-bench: GitHub에서 발견된 실제 소프트웨어 문제를 해결하는 LLM의 능력을 평가하기 위해 설계되었습니다. 여기에는 2,294개의 소프트웨어 엔지니어링 문제가 포함되어 있습니다. 이 작업은 언어 모델에 코드베이스와 문제 설명을 제공하고 문제를 해결하는 패치를 생성하도록 요청하는 것입니다. 모델의 제안된 솔루션은 리포지토리의 테스트 프레임워크에 대해 평가됩니다.

- SWE-Lancer: Upwork에서 가져온 실제 프리랜서 소프트웨어 엔지니어링 작업을 완료하는 데 있어 프런티어 언어 모델(LLM)의 기능을 평가하기 위해 개발된 벤치마크입니다. 여기에는 단순한 버그 수정에서 최대 $32,000의 가치가 있는 복잡한 기능 구현에 이르기까지 1,400개 이상의 작업이 포함되어 있습니다.

- SWE-PolyBench: AI 코딩 에이전트를 위한 다국어 벤치마크입니다.

역할과 중요성

이러한 벤치마크는 AI 모델의 코드 생성, 이해 및 디버깅 능력을 평가하는 데 중요합니다. SWE 벤치마크는 또한 AI 모델과 프롬프트를 생성하고, 출력을 구문 분석하고, 상호 작용 루프를 관리하는 주변 소프트웨어 스캐폴딩을 포함하는 전체 "에이전트" 시스템을 평가하는 데 중점을 둡니다.

SWE의 의미

SWE는 또한 소프트웨어 엔지니어를 의미할 수도 있습니다. 이 맥락에서 소프트웨어 엔지니어는 풀 스택, 백엔드, 프런트엔드 및 모바일 개발을 포함한 광범위한 역할을 포괄합니다.

HLE (인류의 마지막 시험)

개요

HLE는 AI 모델의 성능을 측정하는 것을 목표로 하는 엄격한 학술 시험입니다.

- 이것은 단일 측정 단위가 되도록 설계된 희귀한 평가 프레임워크 중 하나입니다.

- 이 벤치마크에는 여러 학문 분야에 걸쳐 2700개의 매우 어렵고 멀티모달 작업이 포함되어 있습니다.

- 현재 LLM의 부족한 점과 다른 벤치마크가 현대적인 평가에 불충분한 이유를 입증합니다.

데이터 세트

- HLE 데이터 세트는 원래 3,000개의 질문으로 구성되었지만 텍스트 전용 하위 집합(이미지 입력이 필요한 질문 제외)을 사용한 평가에서는 2,684개의 질문을 사용했습니다.

- 이 데이터 세트는 2025년 1월에 최종 확정되었습니다.

- 여기에는 GPT-4o, Gemini 1.5 Pro, Claude 3.5 Sonnet, o1, o1-mini 및 o1-preview와 같은 모델이 포함된 GPT-4o를 사용한 테스트를 기반으로 한 적대적 질문 선택이 포함되었습니다.

성과

최고 시스템의 점수는 8.80%에 불과합니다. Gemini 2.5 Pro는 도구 없이 18.8%의 정확도를 달성했습니다. 이 점수는 o3-mini(14%) 및 Claude 3.7 Sonnet(8.9%)과 같은 경쟁 모델보다 상당히 높습니다.

https://www.analyticsvidhya.com/blog/2025/03/llm-benchmarks/

14 Popular LLM Benchmarks to Know in 2025

LLM benchmarks: essential tools for evaluating AI models in reasoning, coding, and NLP. Learn their role, top benchmarks, and limitations.

www.analyticsvidhya.com

https://skphd.medium.com/essential-benchmarks-and-metrics-for-responsible-ai-2447156b0276

Essential Benchmarks and Metrics for Responsible AI

The rapid advancement of Large Language Models (LLMs), such as GPT, LLaMA, and Gemini, has profoundly reshaped the landscape of artificial…

skphd.medium.com

'07.AI' 카테고리의 다른 글

| LLM - 성능 - 최적화 - 배치 (Batch) (0) | 2025.05.16 |

|---|---|

| LLM - 성능 - 벤치마크, 빅젠(BIGGEN) 벤치마크 (0) | 2025.05.08 |

| 인공지능 - 위험 관리 (0) | 2025.04.27 |

| 인공지능 - 위험 관리 - 프레임워크 'AI RMF 1.0'(AI Risk Management Framework-AI RMF 1.0) (0) | 2025.04.24 |

| 인공지능 - 법/규제 - 중국 (1) | 2025.04.19 |