기초 모델 (FM, Foundation Model) - 사후 학습(Post-training) - 지도학습 기반 미세 조정(SFT, Supervised Fine-tuning)

07.AI 2025. 2. 8. 15:18

(개념) 정답(Label)이 존재하는 다수의 예시를 포함하는 대규모 데이터셋을 가지고 모델을 학습하는 방법

- 어떠한 입력에 대해서 어떠한 답변이 출력되는지에 대한 정답을 포함하는 데이터셋을 가지고 학습하는 방법

활용 예: ChatGPT가 사용자 질문에 더 적절하게 답변하도록 QA 데이터셋으로 추가 학습하는 방식

연구 요약

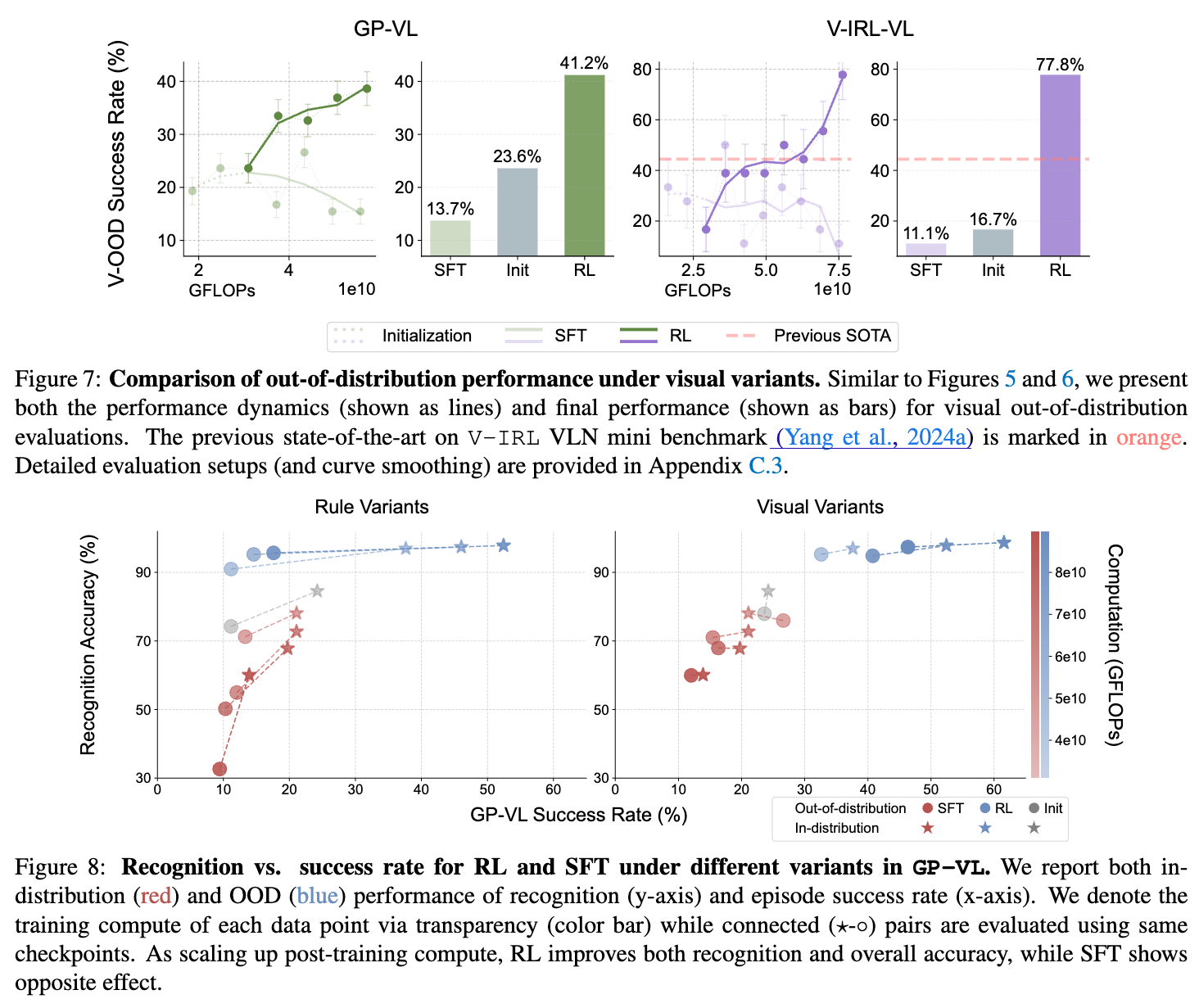

SFT는 모델이 주어진 훈련 데이터에 대해 잘 맞춰지도록 훈련하는 방법으로, 이는 정확도 향상에 기여하지만, 새로운 데이터에 대한 일반화 능력은 떨어지는 경향이 있습니다. 반면에, RL은 보상을 통해 모델을 훈련시키며, 이는 다양한 환경에서의 일반화 능력을 높이는 데 유리하게 작용합니다.

이 논문에서 저자들은 SFT와 RL 각각의 장단점을 분석하며, 사용 환경에 따라 어떤 접근 방식을 선택해야 하는지를 논의합니다. SFT는 주어진 데이터세트에 대한 성능을 극대화하는 데 적합한 반면, RL은 모델의 유연성 및 적응력을 증가시켜 새로운 환경이나 데이터셋에 대한 적용 가능성을 높입니다.

이 연구에서는 SFT가 고정된 데이터 세트에서 최적화된 결과를 제공하며, 훈련된 데이터와 유사한 데이터에 대해서는 성능이 뛰어나지만, 새로운 데이터에 대한 일반화 능력이 떨어질 수 있음을 강조합니다. 이러한 현상은 SFT가 데이터를 암기하는 경향으로 나타납니다. 반면, RL은 모델이 훈련 중에 주어진 보상을 통해 학습하면서 다양한 상황에서 적응할 수 있는 능력을 강화합니다.

이 연구는 또한 Foundation Model이 사전 훈련된 모델의 구조를 어떻게 활용할 수 있는지를 분석하고, RL이 사용되는 다양한 시나리오에서 모델이 어떻게 효율적으로 일반화할 수 있는지를 제안합니다. SFT와 RL 간의 이러한 차이는 특히 AI 시스템이 다양한 환경에서 어떻게 성능을 발휘할 수 있는지에 대한 중요한 통찰을 제공합니다.

또한, 연구에서는 모델의 전반적인 훈련 비용과 효율성을 고려하여 각 방법의 선택이 어떻게 AI 사업에 영향을 미칠 수 있는지를 탐구합니다. 즉, 사용자는 모델의 목적에 따라 SFT와 RL의 적합성을 평가하여 선택할 수 있어야 합니다.

'07.AI' 카테고리의 다른 글

| LLM - Google, 제미나이 2.0 (Gemini 2.0) (0) | 2025.02.11 |

|---|---|

| 자연어처리 (NLP) - 스탠퍼드-워싱턴大-앨런인공지능연구소, 's1' (0) | 2025.02.10 |

| 기초 모델 (FM, Foundation Model) - 사후 학습(Post-training) - 강화학습(RL, Reinforcement Learning) (0) | 2025.02.08 |

| LLM - Open AI, OpenAI o3 mini (1) | 2025.02.08 |

| SW 테스트 - 정적 테스트 - 코드 리뷰 (Review) - AI Code Reviewer (0) | 2025.01.31 |