EU(유럽연합, European Union)는 지난 3월 세계최초로 AI 기술에 대한 포괄적인 규제 법안인 AI 법(AI act)을 본회의에서 통과시켰다. <표 1>과 같이 EU AI법에선 AI의 활용 분야를 위험성에 따라 구분했다.

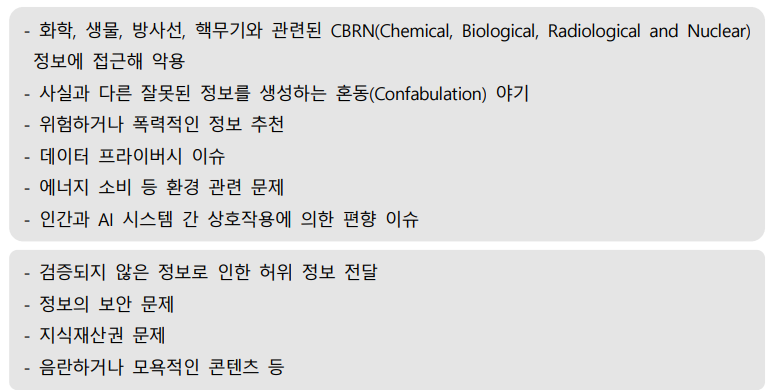

영국은 AI 안전 정상회의를 앞두고 AI 안전 국제과학보고서[6]를 발표했다. 해당 보고서는 범용적으로 개발된 AI가 야기할 수 있는 위험에 대해, 크게 위험(risk)과 교차위험 (cross-cutting risk) 두 가지로 구분했다. 각각의 세부 내용은 <표 2>에 기재했다.

NIST(미국국립표준기술연구소, National Institute of Standards and Technology)는 생성형 AI로 인해 발생하는 여러 가지 위험 요인을 정의했다.

OECD[8]는 AI로 인한 사고(Incident)를 ‘AI 시스템 개발 및 사용으로 인해 실제 피해가 발생하는 사건 또는 상황’으로 정의했다. AI 위험(Hazard)의 경우, AI 시스템 개발 또는 사용으로 인해 잠재적으로 해로운 피해가 발생할 수 있는 사건 또는 상황을 의미한다. 이러한 AI 사고·위험은 심각도(Severity)에 따라 [그림 1]과 같은 단계로 분류되며, 이는 EU AI법과 유사한 맥락을 갖고 있다.

AI 위험성 평가와 관련된 대표적인 최신 연구는 LLM(거대언어모델, Large Language Model)의 위험 요인을 분류하고, 분류된 위험 요인에 따라 안전성을 평가하는 것이다. 해당 연구에선 AI 위험요인을

①정보 위험(Information Hazard),

②악의적인 사용(Malicious Uses),

③차별, 배제, 독성, 증오, 공격성(Discrimination, Exclusion, Toxicity, Hateful, Offensive),

④잘못된 정보로 인한 유해성(Misinformation Harms),

⑤인간-챗봇 상호작용으로 인한 피해(Human-chatbot Interaction Harms) 등으로 분류했다.

각 위험 요인별 주요 피해 유형은 <표 3>과 같다.

https://artificialintelligenceact.eu/

EU Artificial Intelligence Act | Up-to-date developments and analyses of the EU AI Act

The AI Act is a European regulation on artificial intelligence (AI) – the first comprehensive regulation on AI by a major regulator anywhere. The Act assigns applications of AI to three risk categories. First, applications and systems that create an unac

artificialintelligenceact.eu

http://weekly.tta.or.kr/weekly/files/20240729060708_weekly.pdf

'07.AI' 카테고리의 다른 글

| LLM - SLM - HuggingFace 파이-3(phi-3) (0) | 2024.08.26 |

|---|---|

| 인공지능 - AI 신뢰성 - 국제표준 (ISO/IEC JTC1/SC42) (0) | 2024.08.12 |

| LLM - Open AI, SearchGPT (0) | 2024.07.29 |

| LLM - Open AI, GPT-4o mini (1) | 2024.07.23 |

| 인공지능 - 재현 데이터(Synthetic Data) (0) | 2024.07.12 |