728x90

반응형

[개념] AI 시스템의 의사결정 과정과 작동 원리를 설명하기 위한 기술

- 인공지능의 설명가능성(explainability) , 인공지능의 네 가지 윤리 원칙 중 하나 (EU, AI를 위한 윤리 가이드라인)

- 사용자가 인공지능 시스템의 동작과 최종 결과를 이해하고 올바르게 해석하여 결과물이 생성되는 과정을 설명 가능하도록 해주는 기술

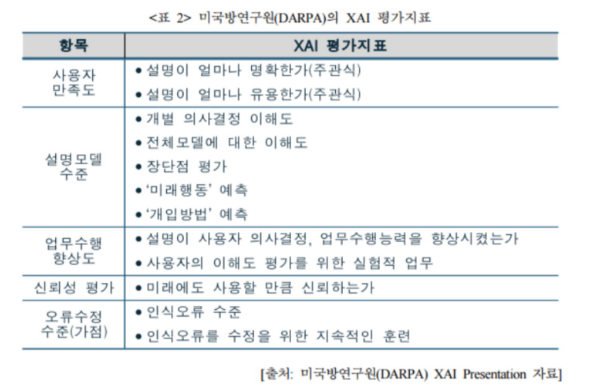

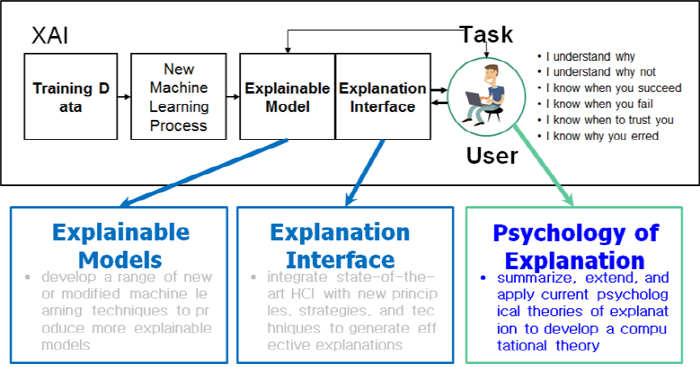

- 미(美) 국방성 산하 국방위고등연구계획국(DARPA)에서는`17년부터 XAI 관련 프로젝트(XAI 학습 모델 개발 및 테스트)를 추진

[연구 동향]

1) 입력 기여도 방법(input attribution method) : 모델 독립적 기여도 방법, 모델 특정적 기여도 방법

2) 사전 설명 기법(ante-hoc explanation method) : 의사결정 나무(decision trees)

[연구방향]

1) 입력 기여도 방법 : 섭동(perturbation) 기반 방법, 기울기 기반 방법

2) 개념 기반 설명 방법(concept-based explanation method)

[평가방법/지표]

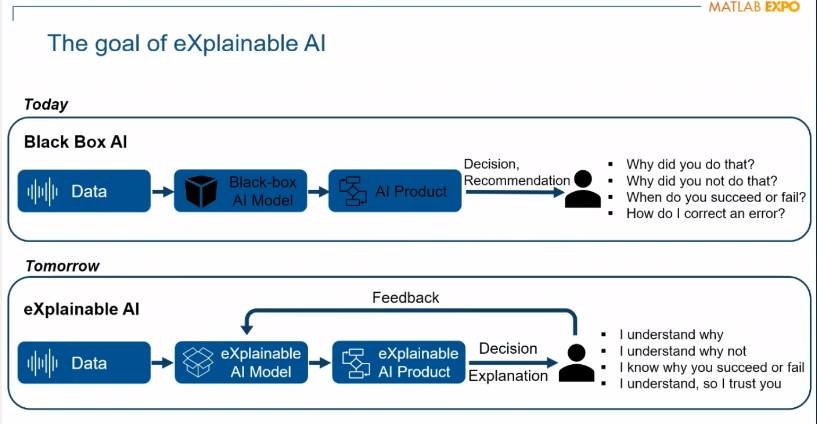

- 문제점 : 알고리즘의 조작 가능성, 의사결정의 편향성 , 머신러닝 AI에 대한 신뢰성 입증 한계

[대안]

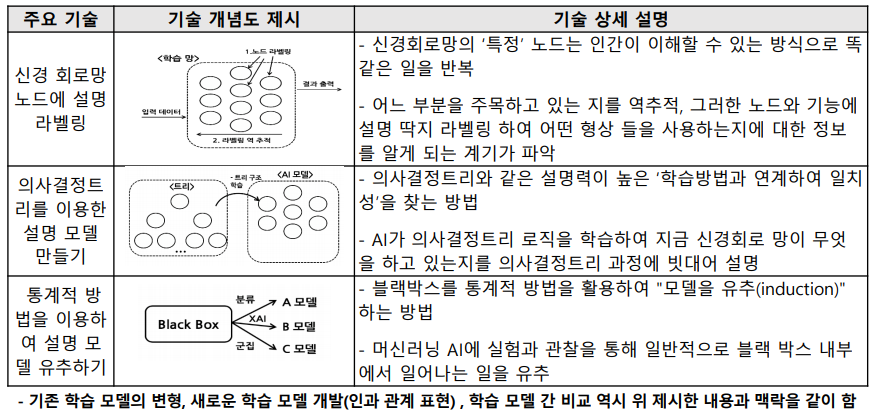

1. 설명모델(의사결정 트리 또는 규칙 기반 모델)

복잡한 인공지능 모델 내부에서 일어나는 결정과정을 간단한 규칙으로서 환원해 설명하는 방법

지도학습 수행 후, 해당 모델을 기반으로 설명 제시

[장점] 직관적이고 쉽게 적용 가능

[단점] 설명 모델이 원래 모델의 모든 결정과정을 대표할 수 없으므로 정확도 및 신뢰도 떨어짐

2. 특성기여도 분석법(Feature Attribution)

인공지능 모델에 사용되는 각 요소들이 출력에 미치는 영향을 수치화함으로써 입력 특성들을 그 중요도에 따라 나열

(결정을 내리는 데 중요한 요소들과 중요하지 않은 요소들로 분리함을 통해 설명 제시

[CSRC@KAIST 차세대보안R&D리포트] 설명 가능한 인공지능과 AI 신뢰가능성

지난 8월 16일, 수백 명의 영국 고등학생들이 런던 시내에 모여 성적표를 불태우며 교육부장관의 사임을 요구하는 일이 있었습니다. 코로나로 인해 대학입시에 필수적인 A-level(Advanced level) 시험

www.boannews.com

https://eventsonline.mathworks.com/conferences/47d921d5a675/bigroom

GDPR은 머신러닝과 인공지능에 대해 어떤 내용을 담고 있을까?

71조에 한 번 등장하는 ‘설명을 요구할 권리(right to explanation)’

통지 대상 내용에는 “자동화된 의사 결정의 존재 여부,

그리고 최소한 그러한 경우에는 관련된 논리에 대한 의미 있는 정보,

또한 정보 주체에 대한 그러한 정보 처리의 의미와 예상되는 결과” 등이 포함되어야 한다.

GDPR 22조는 ‘프로파일링을 포함한 자동화된 의사결정’을 다루고 있다. 알고리즘에 의한 자동화된 결정을 반대하고 인간의 개입을 요구할 권리, 알고리즘의 결정에 대한 설명을 요구하고 그에 반대할 권리를 규정하고 있다. 요컨데 유럽연합은 기업이 이용자에게 자동화된 결정이 어떤 영향을 미치는지 그 예견된 결과와 심각성 등에 대한 정보를 제공해야 한다고 보고 있다. 예를 들어 신용 평가와 관련해 데이터 주체는 자신의 정보가 처리되는 논리를 알 수 있어야 하며 그 과정을 거부할 수 있는 권리도 부여받아야 한다.

설명가능 인공지능은 불완전하고 불공정할 수 있는 일반적인 알고리즘의 문제를 해결하고 보완할 수 있는 한 수단이 된다.

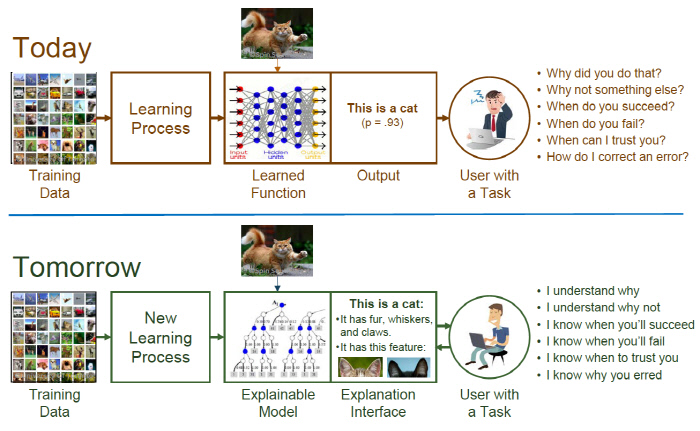

설명가능 인공지능이 사물 인식 딥러닝에 적용될 경우, 어떤 사물을 고양이로 인식했을 때 털과 콧수염, 발톱, 귀 모양 등으로 그 사물을 고양이로 판단한 근거를 설명하게 된다. 출처:DARPA

설명가능 인공지능은 딥러닝이 어떤 사물을 고양이로 인식했을 때 또 다른 인공지능 툴로 무엇을 언제 고양이라고 했고 언제 아니라고 했는지 모니터링하고 분석하는 것이다. 기존 딥러닝 과정에 설명가능 툴을 붙여 사진에서 어떤 특징들을 고양이로 판단하는데 활용했는지 밝히는 것이다. 이를 응용하면 암세포나 질병 진단, 전장에서 적군을 판단하는 데도 적용할 수 있다. 출처:DARPA

1. 의사결정 이유를 설명할 수 있는 인공지능, XAI

의료 진단에서부터 대출 자격 심사에 이르기까지 오늘날 인공지능 관련 기술은 중차대한 업무를 담당함에도 불구하고 딥러닝, 머신러닝 아키텍처의 내부 작동은 점점 더 복잡하고 불투명해지고 있다. 일부 과학자, 정부 관계자, 시만들은 이러한 기술들이 '블랙박스'로 변모해가고 있다고 표현한다. 이 기술의 의사 결정 과정을 드러내고, 비전문가들에게 설명할 수 있는 시스템이 필요하다는 주장이 제기되는 이유다.

여기에서 비롯된 것이다 '설명 가능한 인공지능'(explainable artificial intelligence), 약자로 XAI로 알려진 접근 방식이다.

2. 인간수준으로 비디오를 이해하는 인공지능, VTT

자연어 처리 및 시각 정보 처리 연구가 급속도로 발전함에 따라 이 두가지 정보를 결합하는 멀티모달 연구도 가속화하고있다. 멀티모달 연구는 비디오와 같이 열린 학습 도메인 상에서 지능 체계를 구현할 수 있다는 가능성을 열어 주었다. 비디오튜링 테스트는 대용량 비디오 데이터를 통해 학습한 세계 지식을 바탕으로 인간과 유사한 수준의 인식과 추론 능력을 갖춘 것을 일정하고 객관적으로 평가하는 방법이다. 이러한 일관성과 객관성은 지능 연구가 주관적으로 상대적인 기준에 의해 표류하지 않고 지능 기술의 개발을 가속할 수 있다. 본 연구에서는 비디오 튜링 테스트를 통과할 수준의 비디오 스토리 이해 기반의 질의응답 기술 개발을 위한 비디오 데이터셋을 정의를 제안하고, MovieQA, LSMDC, YouTube-8M을 중심으로 선행 연구를 검토하고 차별점을 논한다.

728x90

'07.AI' 카테고리의 다른 글

| 생성 모델 - 이미지 - 플로우 기반 모델(Flow-based models) (0) | 2024.05.30 |

|---|---|

| 생성 모델 - 이미지 - VAE(Variational Autoencoder) (0) | 2024.05.30 |

| 인공지능 - 신경망 스케일링 법칙(neural scaling laws) (0) | 2024.05.30 |

| 생성 모델 - 이미지 (0) | 2024.05.30 |

| 생성 모델 - 이미지 - GAN (Generative Adversarial Network) (1) | 2024.05.30 |